Centre de données

Un centre de données (en anglais data center ou data centre), ou centre informatique[1] est un lieu (et un service) où sont regroupés les équipements constituants d'un système d'information (ordinateurs centraux, serveurs, baies de stockage, équipements réseaux et de télécommunications, etc.). Ce regroupement permet de faciliter la sécurisation, la gestion (notamment l'exécution de calculs et le refroidissement) et la maintenance des équipements et des données stockées.

Techniquement, un centre de données fournit des services informatiques en environnement contrôlé (climatisation, poussières, alimentation, etc.) et sécurisé (système anti-incendie, contre le vol et l'intrusion, etc.), munis d'une alimentation d'urgence et redondante.

Opérationnellement, un centre de données peut être exploité par une entreprise de façon interne ou mis à la disposition de plusieurs entreprises en tant que service externe. Lorsqu'un centre de données est utilisé commercialement pour fournir une prestation de service à des particuliers ou des entreprises, on parle de cloud (nuage) ou de dématérialisation[2], une solution interne (rapidité, sécurité des données hébergées notamment) et cloud (robustesse, maintenance, location de services à la demande) pouvant être hybridées.

Terminologie

Le terme « centre de données » est la traduction de l'anglais data center / data centre[3] - [4]. Frédéric Bordage, expert en informatique durable et en sobriété numérique, lui préfère le terme « centre informatique »[5]. En effet, un centre informatique comporte non seulement des baies de stockage des données, mais aussi des serveurs, qui effectuent les traitements. D'autre part, sauf dans une logique de cloud computing intégral, les données sont réparties entre les centres informatiques et les terminaux des utilisateurs.

Description et histoire

Un centre de données est un bâtiment sécurisé contre l'intrusion et les risques naturels et technologiques, abritant différents équipements électroniques, des ordinateurs, des systèmes de stockage et des équipements de télécommunications. Le centre peut occuper une pièce, un étage ou de grands immeubles.

On y retrouve des serveurs 1U (surnommés « boîtes à pizza ») ou plus, « U » correspondant à une unité de hauteur de 4,445 cm (1,75 pouce), empilés dans des baies, lesquelles sont arrangées pour former des rangées simples, ce qui permet de circuler facilement parmi les serveurs, tant à l'avant qu'à l'arrière. Quelques appareils, ordinateurs centraux par exemple, sont de dimensions semblables à ces baies. Ils sont souvent placés à leurs côtés.

Avant la bulle Internet, des millions de mètres carrés destinés à abriter de tels centres furent construits dans l'espoir de les voir occupés par des serveurs. Depuis, la concentration des centres s'est poursuivie, avec le développement de centres spécialisés pour lesquels les défis les plus importants sont la maîtrise de la climatisation et surtout de la consommation électrique. Ce mouvement a été intégré dans l'informatique durable et vise à aboutir à des centres de traitement de données dits écologiques pour lesquels sont apparus des outils spécialisés[6].

Vers 2008, les centres de données Hyperscale (centre de données d'au moins 250 000 serveurs, dont la climatisation est optimisée) ont été créés pour les besoins croissants d'Amazon et Google note Bill Carter du projet Open Compute (créé en 2011 pour permettre à Facebook d'économiser l'énergie consommée par ses serveurs).

L'importance prise par les stockages de données associées à une activité et les mouvements d'acquisitions entre les entreprises peuvent pousser celles-ci à acquérir en interne des technologies ou à rechercher des prestataires spécialisés sur les centres de données, ayant la capacité d'assurer une interopérabilité entre des stockages de données disparates[7].

Fonctions

Un centre de données informatique (CDI, à ne pas confondre avec un centre de traitement informatique, CTI) regroupe des serveurs qui stockent des données au moyen de baies de stockage. La plupart des centres de données effectuent également des opérations sur ces données, de sorte qu'ils jouent également le rôle de CTI.

Les données et bases de données sont souvent devenues cruciales pour le fonctionnement des entreprises et de la société en général. Un nombre croissant de données sont dites personnelles ou sensibles, raison pour laquelle de hauts niveaux de sécurité et de service sont demandés aux centres de données, pour assurer l'intégrité et le fonctionnement de leurs appareils et éviter les attaques par déni de service.

Composantes

Elles doivent pour chaque centre assurer la bonne connexion réseau (internet, intranet, etc.) et une haute disponibilité du système d'information. Pour cela, des applications logicielles gèrent les tâches essentielles de l'« activité métier » des clients. Parmi ces applications, on retrouve des gestionnaires de bases de données, des serveurs de fichiers et des serveurs d'applications.

Composantes physiques

- Climatisation (précise et stable)

- Contrôle de la poussière (filtration de l'air)

- Unité de distribution de l'énergie

- Bloc d'alimentation d'urgence, et une unité de secours (Générateur, UPS)

- Système perfectionné d'alerte d'incendie

- Extinction automatique des incendies (par micro-gouttelettes ou gaz inerte)

- Plancher surélevé

- Conduites pour câbles au-dessus et au-dessous du plancher

- Surveillance par caméras en circuit fermé

- Contrôle des accès, ainsi que sécurité physique

- Surveillance 24/7 des serveurs dédiés (ordinateurs)

- Service de sécurité continuellement présent

- Câbles de paires torsadées de cuivre en Ethernet (Fast ou Gigabit) pour liaisons inter-[jarretières/switches/routeurs/firewall]

- Fibres optiques pour liaisons intersites ou inter-[jarretières/switches/routeurs/firewall]

Climatisation

La climatisation entretient une température homogène d'environ 20 degrés Celsius, essentielle car le fonctionnement des systèmes informatiques génère beaucoup de chaleur, et deviennent défectueux au-delà d'un certain seuil de température[8].

Un centre de traitement moderne est conçu pour optimiser le refroidissement de tous les serveurs, et donc réduire le coût énergétique de l'installation, permettant d'aussi réduire le coût d'hébergement.

La climatisation est généralement testée dès la réception du centre, couramment avec des aérothermes générant de l'air chaud, ou avec des bancs de charge (rackables) pouvant être insérés dans les baies si celles-ci sont déjà présentes.

La climatisation et les systèmes de refroidissement représentent de 40 à 50 % de la consommation énergétique des data-centers[9] - [10].

Organisation de la climatisation

Au minimum, de l'air chaud est aspiré et de l'air froid insufflé sans organisation particulière, mais l'architecture du site est de plus en plus conçue pour éviter que l'air chaud et l'air froid se mélangent trop vite, afin d'économiser l'énergie. Des caches obturent les parties inutilisées des baies, pour ne pas perturber le flux d'air froid prévu.

Des couloirs chauds alternent avec des couloirs froids, un couloir sur deux insuffle l'air froid, par le côté avant des serveurs, via des baies grillagées, l'autre couloir aspire l'air chaud par l'arrière. Certains équipements réseau (ex: commutateurs réseau) peuvent avoir le refroidissement avant arrière ou arrière avant selon les besoins, ce qui simplifie le câblage. Le rendement est meilleur, mais l'air chaud peut encore partiellement se mélanger, à l'air froid en bout de rangée de baie ou par-dessus les baies[11]

Utilisation d'un cube de confinement avec corridor chaud, ou froid, selon les choix des constructeurs. Le « cube » dans lesquelles sont placées les baies, comporte un plafond et des portes à double ou triple vitrage, réduisant considérablement les échanges de température, seul un côté des baies échange l'air, avec les serveurs orientés en fonction du choix corridor chaud ou corridor froid. C'est aujourd'hui la solution optimale[12].

L'immersion du système dans un fluide réfrigérant (huile ou fluide minéral) est possible, encore expérimentale et réservée à des serveurs à haute intensité de flux de données et devant les traiter massivement[13].

Systèmes de production de l'air froid

Le compresseur frigorifique est la base des systèmes de refroidissement, cependant, ils peuvent comporter des bains liquides permettant d'améliorer le rendement. Le free cooling (refroidissement à air, éventuellement associé à une pompe à chaleur) permet de limiter le recours à des refroidisseurs et ainsi de réduire la facture énergétique. Le free cooling n'est intéressant que dans les implantations où l'air extérieur est froid suffisamment longtemps durant l'année. La climatisation peut être complétée par un refroidissement à eau (hydrocooling), l'eau étant 4 000 fois plus efficace que l'air pour extraire et évacuer la chaleur, la chaleur évacuée pouvant éventuellement être récupérées.

La chaleur, plutôt qu'évacuée à l'air libre, peut être valorisée dans des installations proches (voir section infra).

Composantes réseau

Les composantes réseau sont notamment[15] :

- les switch et routeurs ;

- les commutateurs ;

- les pare-feu ;

- les passerelles ;

- les systèmes de détection d'intrusion logicielle.

Sécurité

L'environnement physique des centres est sous stricte surveillance.

La surveillance du bon fonctionnement de la climatisation, elle-même essentielle au bon fonctionnement du matériel électronique.

L'alimentation de secours peut être fournie via un UPS et un générateur électrique ou via un groupe tournant (no-break) couplé à un accumulateur cinétique.

Dans le but de prévenir une perte d'alimentation électrique, toutes les composantes électriques, y compris les systèmes de secours, sont habituellement doublées. Les serveurs dits essentiels sont de plus alimentés par un système qui fait appel à deux sources électriques indépendantes à l'intérieur du centre.

Les centres ont habituellement un plancher surélevé de 60 cm, fait de dalles amovibles. Cet espace permet la libre circulation de l'air, tout comme il facilite le câblage d'alimentation et de données par des chemins de câble différents. Cependant, des centres de données sont sans plancher technique (alimentation par le dessus des racks, afin de supporter plus facilement des éléments lourds de type mainframe (IBM z10, etc.).

Ils ont souvent des systèmes complexes de prévention et d'extinction des incendies. Les centres modernes sont souvent équipés de deux systèmes d'alarme. Le premier détecte les particules chaudes émises par les composantes surchauffées de l'équipement, particules qui provoquent souvent un feu. De cette façon, il est possible d'éliminer à sa source un foyer d'incendie (parfois, il suffit d'éteindre un ensemble à soudure pour éliminer le risque d'incendie). Un deuxième système sert à activer un ensemble d'activités si un début d'incendie se manifeste. Ces systèmes sont également dédiés à une portion du centre de traitement de données. Couplés à d'excellentes portes anti-feu et autres appareils de confinement, il est possible de contrôler le feu et de l'éteindre sans affecter le reste du bâtiment.

Les systèmes conventionnels d'extinction du feu sont aussi nocifs que le feu pour les composants électroniques, c'est pourquoi des procédés alternatifs ont été développés. Certains utilisent l'azote, l'Argonite, le FM-200 ou le FK-5-1-12 (Novec 1230), alors que d'autres se rabattent sur l'émission de fines particules d'eau ultra-pure (cette eau n'est pas électriquement conductrice, ce qui n'endommage pas les composants électroniques).

La sécurité est également essentielle au fonctionnement de tels centres. L'accès physique en est restreint au personnel autorisé, des caméras vidéo permettent de suivre les personnes sur place, des gardes de sécurité veillent à l'intégrité du lieu quand le centre est grand ou contient des informations considérées comme essentielles ou sensibles.

Gestion thermique des centres de données

Les centres de traitement de données émettent beaucoup de chaleur. Ils doivent être continuellement réfrigérés ou tempérés, par des systèmes eux-mêmes consommateurs d'énergie. La consommation énergétique cumulée représente ainsi environ 1 % de la demande mondiale d'électricité en 2018[13] - [16]

Dans un centre de traitement de données, les onduleurs et la climatisation absorbent la moitié de l'énergie consommée (début du XXIe siècle). Les serveurs modernes (2012) peuvent supporter jusqu'à 45 °C, mais demandent une température de 20 à 35 °C[17]. Un centre de taille moyenne requiert environ 600 000 mètres cubes d'air brassé par an[17].

L'efficience énergétique du serveur et du centre de données est l'objet d'améliorations, de leur conception à leur utilisation, notamment par adaptation du besoin à la puissance du serveur et par l'adoption du free cooling par eau ou air. Malgré les progrès faits sur les composants, plus efficients, les serveurs tendent à être de plus en plus compacts et denses (par surface).

De la fin des années 2000 à 2012, la part des serveurs virtuels est passée de 10 à 50 %. Ceux-ci peuvent aussi contribuer à optimiser la gestion des flux d'énergie[18].

Microsoft, justifiant que la majeure partie de la population vit près des côtes alors que les serveurs en sont éloignés (ce qui allonge les délais de latence dans les connexions), teste en un « centre de données immergé » en mer (baptisé Natick Project)[19]. Construit par Naval Group (ex-DCNS, français), il doit consommer 5 % de l'énergie qui serait nécessaire pour le même service à terre. Il doit être testé un an, bien que la structure soit prévue pour être immergée cinq ans, un premier serveur étant de capacité équivalente à quelques milliers de PC individuels, soit de quoi stocker près de cinq millions de films numérisés[19]. Le système est immergé dans un cylindre amarré sur le fond au large de l'archipel des Orcades (nord de l'Écosse). Il est téléopéré et son alimentation provient d’énergies marines renouvelables[19].

Récupération de chaleur

L'importante chaleur extraite des serveurs est généralement rejetée à l'air libre. L'énergie extraite peut être valorisée, mais sa température relativement faible la limite à un transport sur moins d'un kilomètre, alors que les serveurs sont souvent isolés en banlieue. Des projets variés sont néanmoins testés ou exploités[17].

Dans les années 2010, des expériences visent à récupérer cette énergie et à la réutiliser pour des besoins énergétiques locaux ou de proximité (chauffage, réseau de chaleur, eau chaude sanitaire).

L'expérience la plus large d'Europe a été mise en place en France à Marne-La-Vallée (Seine-et-Marne), dans le parc d'activités de Val d'Europe, s'étalant aujourd'hui sur 40 ha. Le réseau de chauffage urbain de ce parc utilise la chaleur produite par le data center de la banque Natixis. À terme, ce data center compte fournir près de 26 millions de kilowattheures par an, permettant de chauffer 600 000 m2 de bâtiments tout en évitant l'émission de 5 400 tonnes de CO2[20].

À Amsterdam, l’université d'Amsterdam reçoit une eau gratuitement chauffée par le centre de données d'Equinix. À Roubaix, cinq centres d’OVHcloud, hébergeur français, sont refroidis par eau et contribuent à chauffer des bâtiments proches. À Clichy, Global Switch chauffe une serre tropicale. En Suisse, IBM chauffe la piscine d'Uitikon[21]. À Montluçon, une « chaudière numérique » complétée par une pompe à chaleur fournit l'eau chaude de 48 logements[17]. À Montréal (Canada), un « silo de serveurs », grand comme un bâtiment de ville, est passivement refroidi et voit sa chaleur récupérée par une centrale en toiture et distribuée aux voisins ; il est testé à l'éco-campus Hubert-Reeves dans le Technoparc de Montréal (en)[22].

Réseau

Les communications à l'intérieur d'un centre se font maintenant presque exclusivement par Internet Protocol. Il contient donc des routeurs, des commutateurs et tout autre équipement qui permet d'assurer la communication entre les serveurs et le monde extérieur. La redondance est parfois obtenue en faisant usage de multiples équipements réseau de marques différentes.

Quelques serveurs servent à fournir aux utilisateurs de la société les services Internet et Intranet de base dont ils ont besoin : courriel, proxy, DNS, fichiers, etc.

Des équipements de sécurité réseau y sont aussi présents : pare-feu, VPN, systèmes de détection d'intrusion, etc. ainsi que des systèmes de monitoring du réseau et de certaines applications.

Applications

Les serveurs tendent à être virtualisés. En France, un tiers des serveurs hébergés dans des centres de données serait virtualisé et un cinquième à haute densité en 2011. Ces taux devaient doubler d’ici 2013[23].

Le but principal d'un centre de traitement de données est d'exécuter des applications qui traitent des données essentielles au fonctionnement d'une société. Ces applications peuvent être conçues et développées en interne par l'entreprise cliente ou par un fournisseur de progiciel de gestion d'entreprise. Il peut s'agir typiquement de ERP et CRM.

Souvent, ces applications sont réparties dans plusieurs ordinateurs, chacun exécutant une partie de la tâche. Les composantes les plus habituelles sont des systèmes de gestion de base de données, des serveurs de fichiers, des serveurs d'applications et des middleware.

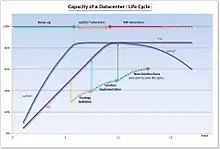

Gestion de la capacité d’un centre de données

La capacité d’utilisation d’un centre de données peut être limitée par plusieurs paramètres. Sur le long terme, les principales limites que rencontreront les exploitants seront la surface utilisable, puis la puissance disponible.

Dans la première phase de son cycle de vie un centre de données verra une croissance plus rapide de sa surface occupée que de l’énergie consommée.

Avec la densification constante des nouvelles technologies des matériels informatiques, le besoin en énergie va devenir prépondérant, équilibrant puis dépassant le besoin en superficie (deuxième puis troisième phase du cycle).

Le développement et la multiplicité des appareils connectés, des besoins en stockage et traitements des données font que les besoins des centres de données croissent de plus en plus rapidement. Il est donc important de définir une stratégie de développement du centre de données avant d’être « dos au mur ». Le cycle de décision, conception, construction est de plusieurs années. Il est donc important d’initier cette réflexion stratégique lorsque le centre de données atteint 50 % de son énergie consommée.

Le maximum d’occupation d’un centre de données doit se stabiliser autour des 85 % tant en énergie qu’en superficie occupée. En effet, les ressources ainsi ménagées serviront d’espace de manœuvre pour gérer les remplacements de matériel et permettra ainsi la cohabitation temporaire des anciennes et nouvelles générations.

Si cette limite vient à être dépassée durablement, il ne devient plus possible de procéder au remplacement des matériels, ce qui conduit inexorablement vers l’étouffement du système d’information.

Le centre de données est une ressource à part entière du Système d’information (SI), avec ses propres contraintes de temps et de gestion (durée de vie 25 ans), il doit donc être pris en compte dans le cadre des plans à moyens termes du SI (entre trois et cinq ans).

Localisation des centres de traitement de données

Le critère de proximité aux bassins d'usagers[24], d'importance pour les opérateurs, se double d’une garantie de sécurité et de connectivité stable. Le coût d’installation est un autre facteur décisif : les entreprises cherchent des zones d'accueil dont le prix du foncier et le coût de construction du bâti sont les plus bas possibles. Les politiques d’allégements fiscaux en leur faveur peuvent se révéler à ce titre un levier d’attractivité majeur, même si la réglementation nationale a évolué vers un cadre plus contraignant. Ainsi, depuis 2022 en France, « l’éligibilité à l’abattement de la TICFE sera conditionnée à l’adoption d’un système de management de l’énergie et à l’adhésion à un référentiel officiel de bonnes pratiques en matière d’énergie »[25].

En 2011, on dénombrait 2 087 centres de traitement de données dans le monde. Le Groupement des industries de l’équipement électrique, du contrôle-commande et des services associés (Gimélec) estime à 130 le nombre de centres de traitement de données d'offreurs en France, dont 40 % en région parisienne[26]. Une dizaine d'années plus tard, leur nombre serait monté à près de 260 entités sur le sol français[27]. Dans ce pays, les centres de traitement sont dispersés sur l'ensemble du territoire ou concentrés dans des zones liées au réseau urbain dans les départements de Paris, d'Île-de-France (essentiellement Hauts-de-Seine, Seine-Saint-Denis), le Nord et les Bouches-du-Rhône ; l'ouest et la région Rhône-Alpes sont également des zones privilégiées[28].

Mél Hogan relève quant à lui 500 000 centres de données dans le monde en 2011, avançant même le chiffre de trois millions comme étant une estimation plus réaliste (estimations par Emerson Network Power et par The Register respectivement)[29]. En 2019, le site danois datacentermap.com recense 4 798 centres de traitement de données dans 122 pays dans le monde[30], dont 1 756 aux États-Unis et 149 en France[31].

Les services informatiques des grandes entreprises sont généralement implantés dans des centres de traitement de données, dédiés ou mutualisés. Les plus gros centres dans le monde sont ceux des géants de l'internet comme Google, qui utilise des infrastructures modulaires en conteneurs, qui peuvent héberger jusqu'à 1 160 serveurs[32] (voir Plateforme Google), ou Facebook qui a étendu son centre de traitement de Prineville dans l'Oregon[33]. Amazon a lui aussi implanté son centre de traitement dans l'Oregon, compte tenu du faible coût de l'énergie dans cet État[34]. Apple a construit son plus gros centre à Maiden en Caroline du Nord[35], pour soutenir sa stratégie de développement de l'iCloud[36].

Enjeux énergétiques

En 2018 les cinq premières entreprises mondiales en capitalisation boursière sont Apple, Amazon, Alphabet, Microsoft et Facebook, qui dépassent des géants pétrogaziers que sont Shell et ExxonMobil (en , l'entrée en bourse de Saudi Aramco change la donne, puisque la capitalisation de cette entreprise dépasse 2 000 milliards de dollars[37]). Ces nouveaux géants et les GAFAM en général contribuent au réchauffement des milieux et au réchauffement climatique par l'énergie grise qu'ils consomment[13]. Cette tendance devrait s'amplifier du fait du développement mondial d'Internet, de la vidéo en ligne, de la téléphonie sans fil, des objets connectés, du big data et de la technologie blockchain. Un rapport de l'Agence internationale de l'énergie atomique de 2017 sur le numérique et l'énergie estime que la quantité de données à stocker et manipuler par les centres de données devrait tripler entre 2014 et 2020, ce qui doit inciter à les gérer avec la plus grande vigilance ; dans un premier temps, l'optimisation énergétique devrait permettre de limiter l'augmentation de la consommation à 3 % entre 2014 et 2020[13], mais ni l'informatique quantique, ni la bio-informatique ne semblent assez mûres pour permettre un saut technologique.

En 2018, 200 térawatts-heures (TWh) ont été nécessaires au fonctionnement des centres de données, soit 1 % de la demande mondiale d'électricité[13], équivalents à la production d'environ la moitié des réacteurs nucléaires de France (379,1 TWh[38] en 2017. L'augmentation de leur efficacité nullifiera encore jusqu'en 2028 l’augmentation de la consommation induite par un accroissement du trafic, selon Dale Sartor (responsable du Centre d'expertise sur l'efficacité énergétique dans les centres de données du laboratoire national Lawrence-Berkeley, du DOE), mais la demande en électricité devrait ensuite de nouveau augmenter rapidement[13]. En 2020, la consommation mondiale atteint 650 térawatts-heures, soit entre 1 % et 3 % de la production électrique mondiale[17].

Deux enjeux sont donc de réduire la consommation informatique mondiale d'énergie et de valoriser sa chaleur de récupération (voir section Gestion thermique des centres de données).

Le seul refroidissement du matériel informatique contribue directement à 0,3 % aux émissions totales de carbone, alors que la totalité de l'informatique émet 2 % de toutes les émissions mondiales, énergie grise non comprise[13]. L'empreinte carbone de l'informatique devrait encore beaucoup augmenter, de même que son empreinte eau (en 2014, les data centers américains ont consommé 100 milliards de litres d'eau dans les tours de refroidissement). La consommation électrique de l'informatique dans le monde dépassera probablement 20 % du total mondial avant 2030, dont le tiers pour les seuls centres de données[13]. La prospective reste délicate dans le domaine informatique, où l'innovation est rapide, mais si la cryptomonnaie (comme Bitcoin ou Ethereum) et la blockchain ou l'IA se développent sans se décarboner[39] et sans économiser l'énergie, notamment dans un contexte de gaspillage d'énergies et d'obsolescence programmée, la demande en énergie et en électricité sera encore très supérieure[13].

Anders Andrae, expert en TIC durables chez Huawei Technologies à Kista en Suède, estime que sans effort important, la consommation électrique des centres de données pourrait être multipliée par 15 entre 2015 et 2030, pour atteindre 8 % de la demande mondiale en électricité[40], mais ce chiffre est controversé[13].

Une hypothèse inverse est qu'une partie des données sera stockée et exploitée sur les millions d'ordinateurs selon le principe d'un centre de données distribuée[41] (voir infra), même si des centres de données sécurisés resteront a priori nécessaires pour les données sensibles, économique, militaires, de renseignement, de santé et personnelles notamment.

Le bas coût de l'énergie dans les années 2000-2010, permis par le gaz de schiste et la crise de 2008, ainsi que l'absence de taxe carbone ou de taxe générale sur les activités polluantes des centres de données, n'ont pas encouragé les économies d'énergie, mais des progrès sont faits[13].

De nombreux serveurs réalisent aussi des taches inutiles ; ainsi Jonathan Koomey a-t-il constaté en 2018 que presque un quart d'un échantillon de 16 000 petits serveurs installés dans des placards, gaines et sous-sols d'entreprises effectuaient en « zombies » des tâches obsolètes que des techniciens ou logiciels avaient oublié de désactiver. Selon une étude du Berkeley National Laboratory, transférer l'activité de 80 % des serveurs de petits centres de données américains vers des centres de très grande envergure plus performants entraînerait une économie de 25 % de leur consommation d’énergie[42].

Le Bitcoin, né en 2008, consommait déjà à lui seul 20 TWh d’électricité par an dans le monde en 2018, l'équivalent d'un peu moins de 10 % de la consommation des centres de données, selon Alex de Vries (consultant en données chez PwC)[43], mais il pourrait ne pas se développer autant que ce qu'espèrent ses promoteurs, ou migrer vers des types de blockchains humaines[44] ou moins énergivores, ou pourrait finalement ne pas répondre aux besoins de confiance dans les transactions[45]. L'utilisation généralisée de la blockchain par les bourses serait plus préoccupant.

Enjeux environnementaux

Le développement massif des centres de données au début du xxie siècle (notamment pour le compte de sociétés de services comme Google, Amazon ou OVH en France) a rapidement soulevé des enjeux environnementaux, notamment liés :

- à leur consommation de métaux rares ou précieux et de terres rares ;

- à une consommation croissante d'électricité de l'ensemble des centres de données.

Les impacts environnementaux se concentrent d'une part lors de la fabrication : des bâtiments, des équipements liés aux bâtiments (groupes froid, groupes électrogènes, onduleurs, etc.) et des équipements informatiques et télécoms qu'ils contiennent ; d'autre part à l'utilisation du centre de données. La fabrication concentre les pollutions et l'épuisement des stocks de ressources non renouvelables. L'utilisation se traduit essentiellement par des émissions de gaz à effet de serre (liées à la production de l'énergie consommée par le centre de données) et des émissions des déchets d'équipements électriques et électroniques (DEEE).

L'empreinte écologique globale des centres de données grandit rapidement, mais elle aurait pu être réduite par une optimisation et un partage des ressources (de 25 % environ en 2010)[46] et pourrait encore l'être (voir ci-dessous).

Émissions indirectes de gaz à effet de serre

Selon les études, les centres de données seraient responsables de 1 %[47] à 2 %[48] des émissions mondiales de gaz à effet de serre en 2020, soit un impact comparable à celui du transport aérien[48]. Les centres informatiques représenteraient près de 15 % de l'impact environnemental du numérique à l'échelle mondiale, tandis que les équipements utilisateurs en concentrent les deux tiers, et le réseau la part restante[49]. En 2018, les centres de données étaient responsables de 0,3 % des émissions mondiales[13].

Selon l'association française The Shift Project, le numérique dans son ensemble était responsable de 3,7 % des émissions de CO2 mondiales en 2018, contre 2,5 % en 2013[50]. La consommation électrique des centres de données de l'Union européenne est estimée[51] à 104 Twh en 2020[52] - [53].

Amélioration du bilan carbone

Une partie de la chaleur qu'ils émettent est parfois récupérée et exploitée par les serveurs et les systèmes de stockage, notamment pour des raisons économiques (coproduction) et commerciales (image de marque).

Deux leviers pour améliorer le bilan carbone sont les économies d'énergie d'une part et l'écoconception avec valorisation de la chaleur produite d'autre part. Des mesures compensatoires (compensation carbone) sont aussi envisagées ou utilisées par certains acteurs. En 2011, le centre GrenoblIX est devenu le premier centre de données « écologique » en France.

Consommation d'électricité

Malgré des gains d'efficience énergétique des processeurs et en matière d'optimisation des réseaux[54] et d'efficacité énergétique des matériels informatiques[55], en raison de l'explosion des besoins, les gros centres de traitement de données sont des systèmes physiques et cybernétiques (Cyber-Physical System[56] - [57]) qui consomment des quantités importantes et croissantes d'électricité[58]. Un centre de données de 10 000 m2 consommerait autant qu'une ville de 50 000 habitants[59] et un grand centre de données consomme 100 MW soit 1/10e de la production d’une centrale thermique[60].

« À l'échelle européenne, la Commission estimait en 2008 que les centres de données consommaient 56 TWh[61], dont la moitié pour refroidir les bâtiments[21] ».

Une des principales métriques utilisées pour évaluer l'efficacité énergétique d'un centre de données est l'indicateur d'efficacité énergétique ou PUE (pour Power Usage Effectiveness en anglais). Cet indicateur évalue la surconsommation électrique due à tous les équipements non informatiques du datacenter. Un datacenter idéal aurait un indicateur d'efficacité énergétique de 1, c'est-à-dire la totalité de la consommation électrique du datacenter serait consommée par les équipements informatiques.

La crise de l'énergie de 2022 réduit les bénéfices des opérateurs de centres de données, les coûts énergétiques passant de 50 €/MWh début 2021 à 200 €/MWh début 2022 et étant attendus à 500 €/MWh en 2023[62].

Alternative distribuée

Pour répondre à ces trois enjeux et après que l'expérience SETI@home a montré l'intérêt du calcul distribué (en utilisant dans ce cas des ordinateurs personnels connectés à l’Internet), certains opérateurs comme AMD ont envisagé de décentraliser leurs centres de traitement de données en un réseau distribué tel que proposé par[57] d'unités (petits centres de traitement de données bénéficiant chacun d'une éolienne, maillés entre eux par des fibres optiques[63]).

Des installateurs et propriétaires de centres de traitement de données et des producteurs d'énergie[64] pourraient à l'avenir associer leurs investissements dans un réseau électrique intelligent, éventuellement intégré dans l'« Internet de l'énergie » que Jeremy Rifkin propose dans son concept de troisième révolution industrielle.

Le cloud computing pourrait alors évoluer vers un modèle totalement décentralisé, nécessitant une « gestion dynamique du refroidissement »[65] - [66] (refroidir là où il faut et quand il faut, et passivement tant que possible[66]), ainsi qu'une conception différente de la sécurité des serveurs et de leurs données, de la gestion distribuée des données, de la gestion de l'énergie[67] et de la capacité des réseaux de centres de traitement de données à s'autoadapter aux fluctuations des besoins, mais aussi de l'énergie disponible[68]. Leurs réponses doivent être plus élastiques[69], sans augmentation globale des consommations d'énergie, dans le cadre d'un green cloud[70] qui reste à inventer.

Au début des années 2000, une solution complémentaire des précédentes apparait, qui pourraient être réservée aux données à fortement sécuriser. Elle consiste à développer des réseaux de serveurs en grande partie virtuels (ou plus précisément partagés et distribués, utilisant une partie des ressources des ordinateurs familiaux et d'entreprises ou les utilisant quand leur propriétaire ne les utilisent pas ou les sous-utilisent[71], ce qui demande aussi de repenser la sécurité informatique). Pour cela, des systèmes d'allocation sécurisée des ressources et de répartition des tâches (éventuellement différées quand elles ne sont pas urgentes) doivent encore être testés et validés à grande échelle. Dans tous les cas la recherche et développement est à développer[72].

Radiateurs numériques : C'est un pseudo radiateur électrique (il irradie la chaleur fatale informatique sous forme de chaleur utile. Les cartes mères et leurs processeurs remplacent tout ou partie de l'élément chauffant à effet joule[73].

En 2013, une expérience propose de délocaliser des serveurs chez des particuliers en lieu et place de radiateurs[74].

Le , dans le cadre du Projet Natick, Microsoft et Naval Group ont immergé leur premier datacenter au large des Orcades en Écosse fonctionnant complètement en autonomie avec des énergies renouvelables.

Indicateurs environnementaux

Les indicateurs proposés par le Green Grid sont les suivants[75] :

- le green energy coefficient (GEC) quantifie la part d’énergie renouvelable consommée par un centre informatique. Il se calcule en divisant la quantité d’électricité consommée (kWh) issue de sources primaires renouvelables par la consommation totale du centre de données ;

- l’energy reuse factor (ERF) mesure la quantité d’énergie utilisée en dehors du centre de données. Cet indicateur est calculé en divisant la quantité d’énergie réutilisée (kWh) par la quantité totale d’énergie consommée par le centre informatique (kWh). L’énergie réutilisée peut prendre différentes formes : chaleur, électricité, etc. ;

- le carbon usage effectiveness (CUE) permet d’extrapoler un volume d’émissions de gaz à effet de serre (GES) à partir de la consommation électrique du centre de données. On le calcule en divisant le total des émissions d’équivalent CO2 (kgCO2eq) par le total de la quantité d’énergie consommée (kWh) par le centre informatique.

L'organisme Uptime Institute a défini une certification des centres de traitement de données en quatre catégories, appelées « Tier ».

Perspectives de régulation

Diverses préconisations sont formulées pour préserver l’écosystème social urbain ou rural en jeu. Si certains élus locaux en appellent à des moratoires communaux ou nationaux — à l'image des Pays-Bas en 2019[76] —, le corps citoyen et militant[77] préconise à court terme un travail de pédagogie auprès des populations d’accueil pour pallier le manque de transparence. À Marseille, dont l'effet d'îlot de chaleur urbain est renforcé par la présence de nombreux centres de données à proximité des nœuds de raccordement électrique et numérique[78] - [27], Sébastien Barles, conseiller métropolitain à Aix-Marseille-Provence, plaide par exemple pour la création de commissions locales d'information[79], comme cela a pu être mis en place au sujet du nucléaire.

Des dispositions législatives spécifiques sont également évoquées pour l'attribution et l'exploitation du foncier occupé, notamment selon une logique de compensation. L’occupation ou l’octroi des sols pourrait ainsi être conditionnée à un ratio d’emplois créés ou à une contribution financière à la transition écologique au bénéfice du territoire concerné[80].

Notes et références

- cf la section terminologie

- Livre Blanc « Datacenters, une chance pour la France », sur globalsecuritymag.fr.

- Commission d’enrichissement de la langue française, « centre de données », sur FranceTerme, ministère de la Culture (consulté le ).

- « centre de traitement de données », Grand Dictionnaire terminologique, Office québécois de la langue française (consulté le ).

- Frédéric Bordage, Sobriété numérique, les clés pour agir, Buchet Chastel, 2019, p. 56.

- Thierry Lévy-Abégnoli, Climatisation et serveurs : vers des salles informatiques plus vertes, ZDNet France, le .

- « Infrastructure : vers la consolidation et la convergence », ZDNet, (lire en ligne).

- Les progrès des équipements informatiques, Christophe Auffray, ZDNet France, le .

- « Énergie consommée par les data centers », sur planetoscope.com (consulté le ).

- « La climatisation, bête noire des datacenters », sur Actu-Environnement (consulté le ).

- Christophe Auffray, Des couloirs chauds et froids, ZDNet France, le .

- Christophe Auffray, Des corridors froids pour accroître le rendement énergétique, ZDNet France, le .

- (en) N. Jones, « How to stop data centres from gobbling up the world’s electricity : The energy-efficiency drive at the information factories that serve us Facebook, Google and Bitcoin », Nature, no 561, , p. 163-166 (DOI 10.1038/d41586-018-06610-y).

- datadock.eu Caractéristiques techniques - Refroidissement.

- (en) Mauricio Arregoces et Maurizio Portolani, Data Center Fundamentals, (ISBN 9781587050237), p. 150.

- Voir la section « Enjeux énergétiques ».

- Benoît Berthelot, « La lourde facture environnemental des data center », Capital, (lire en ligne, consulté le ).

- Baptiste Roux, Dit Riche, Centres de données nouveaux ou existants : l’importance de l’urbanisation Green-IT, Cleantech Republic, .

- Et si on immergeait les data centers dans les océans ?, batiactu.com, .

- « Se chauffer grâce à l'énergie des serveurs informatiques », Le Monde, (lire en ligne, consulté le ).

- « Se chauffer grâce à l'énergie des serveurs informatiques », Le Monde,

- François Huot, Centre de données : Deux approches différentes , mais révolutionnaires [PDF], sur Directioninformatique.com (archive), .

- Markess International, Datacenters & Clouds Privés d’Entreprise, Approches – Perspectives 2013 [PDF]

- belghaoutilina, « Les enjeux derrière la localisation des data centers », Comment voit-on la ville ?, sur Hypothèses.org, (consulté le ).

- Anastasia Gachet, « Data centers : la réduction de la TICFE conditionnée à partir du », sur APL, (consulté le ).

- « Carte des datacenters de Paris », sur france-datacenter.fr (consulté le ).

- « Dans la peau de l'info. Ce qu'il faut savoir sur les data centers, et pourquoi Marseille veut freiner leur installation », sur Franceinfo, (consulté le ).

- Cartographie des centres de données en France à l’ère du cloud computing, sur markess.fr

- (en) Mél Hogan, « Data flows and water woes: The Utah Data Center », Big Data and Society, .

- (en) Data Center Map, « Colocation data centers », sur datacentermap (consulté le ).

- (en) Data Center Map, « Colocation France », sur datacentermap (consulté le ).

- (en) Inside A Google Data Center | Data Center Knowledge

- (en) Facebook Datacenter Category at Data Center Knowledge.

- (en) Amazon Building Large Data Center in Oregon, Data Center Knowledge.

- (en) « The Apple Data Center FAQ. », sur Data Center Knowledge, (consulté le ).

- (en) Timothy Prickett Morgan, « A peek inside Apple's iCloud data center », sur theregister.co.uk, (consulté le ).

- « Aramco atteint une valorisation de 2 000 milliards de dollars », La Liberté, .

- « Le nucléaire en chiffres », sur Électricité de France, (consulté le ).

- (en) J. Truby, « Decarbonizing Bitcoin: Law and policy choices for reducing the energy consumption of Blockchain technologies and digital currencies », Energy research & social science, 2018 (résumé).

- (en) A.S. Andrae et T. Edler, « On global electricity usage of communication technology : trends to 2030 », Challenges, volume 6, numéro 1, 2015, p. 117-157.

- (en) Attias V & Bramas Q, Tangle analysis for IOTA cryptocurrency [PDF], 2018.

- (en) A. Shehabi et al., United States Data Center Energy Usage Report (LBNL), 2016.

- (en) A. de Vries, « Bitcoin's Growing Energy Problem » [PDF], Joule, no 2, volume 5, 2018, p. 801-805.

- (en) Kopp H, Kargl F, Bösch C & Peter A, « uMine: a Blockchain based on Human Miners », 2018.

- (en) M. Campbell‐Verduyn et M. Goguen, « Blockchains, trust and action nets: extending the pathologies of financial globalization », Global Networks, vol. 19, no 3, , p. 308-328 (DOI 10.1111/glob.12214, présentation en ligne).

- (en) Saurabh Kumar Garg, Chee Shin Yeo, Arun Anandasivam, Rajkumar Buyya, « Environment-conscious scheduling of HPC applications on distributed Cloud-oriented datacenters », Journal of Parallel and Distributed Computing, vol. 71, no 6, , p. 732–749 (lire en ligne [PDF]).

- « Les data centers, un gouffre énergétique ? », sur Réseau Étudiant pour une Société Écologique et Solidaire, .

- Joarson, « Data center : l’impact des infrastructures sur l’environnement et les solutions possibles », sur LeBigData.fr, (consulté le ).

- Frédéric Bordage, Sobriété numérique, les clés pour agir, Buchet Chastel, 2019, p. 57.

- Hugues Ferrebœuf (dir.), Lean ICT - Pour une sobriété numérique, The Shift Project, , 88 p. (présentation en ligne, lire en ligne [PDF]), p. 59.

- (en) Howard Geller, « ACEEE 1996 Summer Study on Energy Efficiency in Buildings: profiting from energy efficiency », Energy Policy, vol. 25, no 5, , p. 541–542 (ISSN 0301-4215, DOI 10.1016/s0301-4215(97)89666-8).

- (en) EU Code of Conduct on Data Centre Energy Efficiency : Participant Guidelines and Registration Form, Ispra, European Energy Efficiency Platform, Commission européenne, , 21 p..

- Commission européenne, Joint Research Centre, Trends in data centre energy consumption under the European code of conduct for data centre energy efficiency., Publications Office, (DOI 10.2760/358256).

- (en) S. Nedevschi, L. Popa1, G. Iannaccone, S. Ratnasamy, D. Wetherall, « Reducing Network Energy Consumption via Sleeping and Rate- Adaptation », in Proceedings of the 5th USENIX Symposium on Networked Systems Design & Implementations (NSDI’08), San Francisco, CA, April 2008.

- (en) M. Elnozahy, M. Kistler, R. Rajamony, « Energy-Efficient Server Clusters », Power-Aware Computer Systems, 2003, p. 179-197.

- National Science Foundation. Cyber-physical systems. Technical report, NSF Workshop on Cyber-Physical Systems, 2006. NSF Workshop on Cyber-Physical Systems.

- (en) L Rao, X Liu, Le Xie, Wenyu Liu, Minimizing electricity cost: Optimization of distributed internet data centers in a multi-electricity-market environment [PDF], INFOCOM, 2010 Proceedings, 2010, 9 pages.

- (en) G. Chen, W. He, J. Liu, S. Nath, L. Rigas, L. Xiao, F. Zhao. « Energy- Aware Server Provisioning and Load Dispatching for Connection- Intensive Internet Services », in Proceedgins of the 5th USENIX Symposium on Networked Systems Design & Implementation (NSDI’08), San Francisco, CA, April 2008.

- Quand l'informatique sert aussi à se chauffer, Bati Actu,

- « Numérique : le grand gâchis énergétique », sur CNRS Le journal (consulté le ).

- La citation originale, « 56 milliards de kilowatts », est manifestement erronée et a été corrigée suivant la source sur laquelle elle se fonde : Code of Conduct on Data Centres Energy Efficiency [PDF].

- Ridha Loukil, « La crise énergétique met les opérateurs de datacenters sous pression », sur L'Usine nouvelle, (consulté le ).

- « Installer une fibre optique coûte entre 5 000 euros et 15 000 euros par kilomètre, contre 475 000 euros pour une ligne électrique », source : (en) Steve Kester Greening the Cloud: AMD promotes promising research on Renewable-Powered Data Centers.

- (en) L. Parolini, B. Sinopoli et B. Krogh, Reducing Data Center Energy Consumption via Coordinated Cooling and Load Management, Hot-Power ’08: Workshop on Power Aware Computing and Systems, ACM, 2008.

- (en) Cullen E. Bash, Chandrakant D. Patel, Ratnesh K. Sharma, Dynamic thermal management of air cooled data centers ; IEEE, 2006

- (en) Chandrakant D. Patel, Cullen E. Bash, Ratnesh Sharma, Smart Cooling of Data Centers, p. 129-137, ASME 2003 International Electronic Packaging Technical Conference and Exhibition (InterPACK2003), 6-11 juillet 2003, Maui, Hawaii, volume 2 (ISBN 0-7918-3690-8).

- (en) R. Raghavendra, P. Ranganathan, V. Talwar, Z. Wang, and X. Zhu, No power struggles: coordinated multi-level power management for the data center, in ASPLOS XIII: Proceedings of the 13th international conference on Architectural support for programming languages and operating systems. New York, NY, USA: ACM, 2008, p. 48C59.

- (en) J. Heo, D. Henriksson, X. Liu, T. Abdelzaher, « Integrating Adaptive Components: An Emerging Challenge in Performance-Adaptive Systems and a Server Farm Case-Study », in Proceedings of the 28th IEEE Real- Time Systems Symposium (RTSS’07), Tucson, Arizona, 2007.

- (en) J. Liu, F. Zhao, X. Liu, W. He, « Challenges Towards Elastic Power Management in Internet Data Centers », icdcsw, p. 65-72, 2009 29th IEEE International Conference on Distributed Computing Systems Workshops, 2009.

- (en) L. Liu, H. Wang, X. Liu, X. Jin, W.B. He, Q.B. Wang, and Y. Chen, « GreenCloud: a new architecture for green data center », Proceedings of the 6th international conference industry session on Autonomic computing and communications industry session, Barcelona, Spain: ACM, 2009, p. 29-38.

- (en) Graupner, S., Kotov, V. ; Trinks, H., Resource-sharing and service deployment in virtual data centers (Conference Publications) IEE, Systems Workshops, ; (ISBN 0-7695-1588-6).

- (en) Cullen E. Bash, Chandrakant D. Patel & Ratnesh K. Sharmaa, Efficient Thermal Management of Data Centers—Immediate and Long-Term Research Needs Efficient Thermal Management of Data Centers—Immediate and Long-Term Research Needs ; volume 9, numéro 2, 2003 DOI 10.1080/10789669.2003.10391061, p. 137-152 (résumé).

- Annexe relative à l'arrêté du relatif à l’agrément des modalités de prise en compte des systèmes Qrad de chauffage par recyclage de la chaleur fatale informatique dans la réglementation thermique 2012, ministère de la Transition écologique et solidaire, ministère de la Cohésion des territoires et des relations avec les collectivités territoriales, 2019, numéro NOR : TERL1909697A.

- Anne Drif, « Quand les ordinateurs deviennent radiateurs », Les Échos, .

- Data center : trois nouveaux indicateurs environnementaux, greenit.fr, 27 novembre 2012.

- Yves Gr et montagne, « Le gouvernement néerlandais prolonge le moratoire et veut bloquer les implantations de datacenters hyperscale », sur DCmag (consulté le ).

- « À Marseille, la démesure des data centers », sur Reporterre (consulté le )

- médialab Sciences Po, « Les implications écologiques des data centers à Marseille », sur médialab Sciences Po (consulté le ).

- « À Marseille, la démesure des data centers », sur Reporterre (consulté le ).

- « Qu'apportent les data centers à Marseille ? », sur 20 Minutes (France), (consulté le ).

Voir aussi

Articles connexes

Bibliographie

- (en) Barroso, Luiz André et Hölzle, Urs (2009) The datacenter as a computer: An introduction to the design of warehouse-scale machines ; Synthesis Lectures on Computer Architecture ; (ISBN 9781598295566) ; PDF, 120 p.

- (en) Corcoran P.M & Andrae A (2014). On thin-clients and the cloud; can smartphones and tablets really reduce electricity consumption? . In Consumer Electronics (ICCE), 2014 IEEE International Conference on (p. 81-84). IEEE.

- (en) Kandula S, Sengupta S, Greenberg A, Patel P & Chaiken R (2009) The nature of data center traffic: measurements & analysis ; Microsoft Research ; Proceedings of the 9th ; PDF, 7 p.

- (en) Chaiken, B. Jenkins, P. Åke Larson, B. Ramsey, D. Shaki b, S. Weaver, and J. Zhou. (2008) SCOPE: Easy and Ecient Parallel Processing of Massive Data Sets. In VLDB

- (en) Fichter K & Hintemann R (2014) Beyond Energy: The Quantities of Materials Present in the Equipment of Data Centers. Journal of Industrial Ecology, 18(6), 846-858.

- (en) P. Ruiu, A. Bianco, C. Fiandrino, P. Giaccone & D. Kliazovich, « Power comparison of cloud data center architectures », IEEE International Conference on Communications (ICC), Institute of Electrical and Electronics Engineers, (DOI 10.1109/ICC.2016.7510998, présentation en ligne, lire en ligne [PDF]).

Liens externes

- Notice dans un dictionnaire ou une encyclopédie généraliste :

- Critères de sélection d'un centre de traitement de données

- Syntec - Datacenters et développement durable - État de l'art et perspectives

- Visite du centre de traitement de données de Free

- Visite des centres de données de Google et plus d'information sur les centres de données Google : efficacité énergétique, sources d'énergies, sécurité, etc.

- Data Center Map