Gestion énergétique des centres de calcul

La gestion énergétique des centres de calcul est la mise en œuvre de moyens permettant d'optimiser les besoins importants en énergie de ces centres. Elle fait partie du concept d'informatique durable.

C'est une gestion intelligente qui s'appuie sur des indicateurs de performance énergétique obtenus par une évaluation de chaque site. Pour améliorer ces indicateurs, une étude préalable est nécessaire dès la phase de conception du centre, afin de tirer parti des avantages géographiques du lieu d'implantation (climat, accessibilité à des sources d'énergie) et de l'architecture même du site, liée notamment au choix de la solution de refroidissement.

L'optimisation des logiciels, tant au niveau du traitement des données qu'au niveau du fonctionnement du centre, et l'amélioration continuelle de la performance de l'ensemble des équipements contribuent également à la réduction de la consommation et donc des coûts énergétiques.

Cette efficacité est devenue aujourd'hui un enjeu majeur, aux niveaux tant économique qu'environnemental. Les sociétés consomment de plus en plus de ressources informatiques. Celles-ci leur pourraient leur permettre d'atteindre leurs objectifs et d'accroître leur rentabilité. En conséquence, le nombre de centres de données ne cesse d'augmenter et suscite un besoin croissant en énergie. Il devient nécessaire de privilégier l'électricité décarbonée et de valoriser la chaleur produite par les serveurs.

Gérer efficacement ces centres de calculs, optimiser leur fonctionnement doivent permettre de limiter l'impact environnemental et le coût financier qu'ils engendrent. C'est aussi un moteur de recherche pour le développement de nouvelles technologies dans les domaines de l'alimentation électrique, de la climatisation, de la virtualisation et de la fabrication des composants électroniques.

Remarque préalable

Selon Frédéric Bordage, expert en GreenIT et sobriété numérique, contrairement à une idée répandue, résultant d'une certaine surmédiatisation, l'impact environnemental des centres informatiques, certes important, ne représente en 2019 qu'environ 15 % de l'impact environnemental du numérique à l'échelle mondiale, loin derrière les équipements utilisateurs (plus des deux tiers) et le réseau. En outre, les impacts ne se limitent pas à la consommation d'électricité, mais incluent aussi l'épuisement des ressources abiotiques (métaux)[1].

Problématique

C'est en 1992, via le sommet de Rio, que les premiers engagements sont pris pour protéger notre planète. En 2007, The Green Grid regroupe plusieurs entreprises dont le but est de travailler sur la gestion de l'efficacité énergétique. Face au surcroît de consommation de ces centres de données, deux axes se dessinent : optimiser les besoins en énergie en gérant au mieux la consommation et lutter pour réduire l'impact environnemental.

Gestion

La gestion de l'énergie est mise en avant pour optimiser au mieux la consommation et la dissipation que génèrent ces établissements. Ces centres de données prennent une place prépondérante pour répondre aux besoins toujours plus pressants des entreprises ou même pour de simples utilisateurs. Ils offrent un panel de services très important : les objets connectés, le big data ou encore le cloud qui est un service de stockage des données et représente une des plus importantes activités de ces centres de données.

Il faut être en mesure de recycler ce surplus d'énergie (Par exemple, la dissipation de la chaleur) : c'est devenu un véritable enjeu environnemental, le site Green Data Center News y fait état[2] - [3].

Pour information, l'article de Datacenter Mag donne une revue des différents problèmes qui sont rencontrés, des coûts supplémentaires à prendre en compte dans cette gestion (par exemple les licences logicielles). Il indique les sites les plus performants et montre ainsi la montée en puissance de ces centres dans lesquels, du matériel de plus en plus « hightech » y est concentré à tous les points de vue[4].

Énergie

D'après la thèse de Georges Da Costa, au niveau mondial, la consommation a été multipliée par cinq[5]. En 2020, une estimation montre qu'elle devrait atteindre 1 000 TW h. Autre constat, le nombre de serveurs s'est densifié. En 2014, plusieurs dizaines de milliers de serveurs occupaient une surface de l'ordre de 10 000 m2. D'après l'Uptime Institute, 20 % des serveurs seraient devenus obsolètes et d'après une estimation de Google, ces serveurs seraient utilisés à moins de 50 %. Il faut dès à présent pouvoir répondre à cette croissance, en développant de nouvelles technologies au niveau du refroidissement, de l'alimentation électrique, mais aussi des équipements informatiques et environnements applicatifs. Pour préserver et limiter ces besoins en énergie, il est nécessaire de travailler sur tous ces domaines à la fois. Un article d'Actu-Environnement.com stipule qu'un seul centre de données, consomme en moyenne plus de 30 MW (jusqu'à 100 MW). En comparaison, cette consommation est équivalente au besoin d'une ville de 25 000 à 50 000 habitants. Au niveau mondial, elle représente entre 1,5 % à 2 % de la consommation énergétique et 2 % des émissions de CO2 et en Europe, c'est 56 TW h par an d'électricité, le double d'ici 2020. Si cette gestion était maîtrisée, une économie de 30 TW h par an serait possible[6].

Une conception efficace

L'architecture même de ces centres de calculs est un vecteur important pour gérer efficacement l'énergie de ces établissements. Le but étant de limiter le « gaspillage » énergétique. Pouvoir réutiliser toute cette énergie dite passive, favoriser l'utilisation d'énergie décarbonée sont aussi des enjeux importants. D'autres pistes sont à prendre en considération, décrite ci-après.

Choisir le lieu d'implantation

_-_panoramio.jpg.webp)

Avant de s’intéresser à l'architecture même d'un centre de calcul, il est important de prendre du recul au niveau du choix d'implantation du site. Ces sites dissipent énormément de chaleur. Ils doivent utiliser des systèmes de climatisation puissants, qui consomment autant d’électricité que les équipements informatiques eux-mêmes. Le climat du lieu d'implantation peut diminuer le coût de la facture énergétique et optimiser ainsi son fonctionnement. Exemple de choix géographique : le centre technique de Facebook situé à Lulea, au nord de la Suède, près du cercle polaire, utilise l'air extérieur qui est glacial. Celui-ci est filtré, humidifié puis mélangé à la chaleur dégagée par les serveurs pour réguler la température à l'intérieur[7]. Ainsi le constat est le suivant : 90 % de l’électricité consommée sert à alimenter les calculateurs. D'autres études peuvent être réalisées pour statuer sur le choix d'une région géographique par rapport à une autre en prenant en compte d'autres critères, comme la qualité de l'air à Sapporo au Japon[8].

Définir les solutions de refroidissement

Une fois ce choix géographique acté, la climatisation est un facteur important qui influencera l'architecture et plus particulièrement l'organisation des salles hébergeant le matériel informatique.

Le refroidissement à air est souvent privilégié, car moins coûteux[9]. Plus généralement, par rapport au centre de données de Facebook, le free cooling (refroidissement à partir de l'air extérieur) permet de limiter le recours à des refroidisseurs et entraîne ainsi une réduction de la facture énergétique. Le free cooling n'est intéressant que dans les implantations où l'air extérieur est froid suffisamment longtemps durant l'année.

La climatisation peut être complétée par un refroidissement à eau, qui est 4 000 fois plus efficace que l'air pour conduire la chaleur. Autre constat, d'autres solutions technologiques sont plus largement mises en œuvre : entre autres, la segmentation, le conditionnement d'air dans les salles informatiques (CRAC[note 1]), l'utilisation de blocs de climatisation (CCU[note 2]) qui permettent ainsi le refroidissement et l'humidification de l'air[10] - [11]. Le fait d'appliquer ces nouvelles technologies (free-cooling par exemple), a permis de passer de 55 % d'énergie consommée par les climatiseurs à 18 %[12].

Optimiser les différents flux d'air

En appliquant des règles simples basées sur la maîtrise des flux, le refroidissement de l'air peut être facilité[13] en cloisonnant les baies et en évitant que celles-ci ne présentent des ouvertures à des emplacements non utilisés. Le fait d’espacer les travées pour former des couloirs « chauds » et des couloirs « froids » implique qu'un couloir sur deux insuffle l'air froid, par la face avant des serveurs via des baies grillagées, l'autre couloir aspirant l'air chaud par l'arrière[14]. En lien avec cette gestion de flux, le design du bâtiment est important, à l'image du datacenter d'OVH à Roubaix, qui est conçu avec un grand nombre d'ouvertures sur toutes ses façades. L'air extérieur est introduit via ces ouvrants, traverse des « containers » dans lesquels se trouvent les serveurs. L'air chaud est ensuite évacué par des ventilateurs vers une cheminée (cour intérieur du bâtiment) pour y être refroidi. L'air traverse le bâtiment et les équipements[15].

Réduire la consommation des équipements

Un autre axe d'optimisation est de privilégier l'utilisation d'équipements normés au niveau de la consommation énergétique(80Plus, Energy Star, EPEAT). Ainsi ce matériel ayant un cahier des charges plus restrictif sur les niveaux de consommation, l'énergie utilisée est plus facile à maîtriser. Enfin, il ne faut pas oublier tout simplement de veiller à ce que les serveurs ou autre matériel non utilisés, soient éteints.

Augmenter la température de fonctionnement du matériel

L'un des leviers plus récents dans la réduction du coût énergétique des centres de calcul est d'augmenter la température de fonctionnement des composants, limitant ainsi le refroidissement requis[11]. Ainsi, les recommandations de l'association ASHRAE encouragent de faire fonctionner les équipements informatiques jusqu'à 27 °C sans risque de panne, ce qui permettrait une économie globale d'énergie de 4 %[12].

Autre contrainte à prendre en considération

Enfin, aux contraintes liées à la conception et au choix géographique, s'ajoute également un critère sur les possibilités de raccordement au réseau. Un centre de données doit offrir une gestion efficace de la consommation de son énergie, mais aussi être le plus sécurisé possible (double adduction, maillage...). De plus, un raccordement au réseau doit être optimal pour limiter les temps de latence possible au niveau des liens de transmission. Il faut donc trouver un compromis.

Méthodes d'évaluation

Les étapes d'évaluation

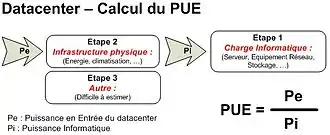

Que ce soit dans les bâtiments « classiques » ou pour ce qui concerne ces centres de données, plusieurs études ont été menées afin d'identifier une méthodologie d'évaluation de l'efficacité énergétique. Cette mesure peut se faire dans un premier temps d'une façon globale, méthode dite « standard » (Sans prendre en compte les problématiques rencontrées), puis elle peut être affinée, en appliquant différents modèles. Parmi toutes ces études, celle réalisée par Schneider Electric éditant un livre blanc définit une méthodologie standard en trois étapes[16] :

- Classement standard des sous-systèmes (charge informatique : serveurs, etc.) ;

- Estimation des ressources partagées charge infrastructure : climatisation, énergie, etc.) ;

- Estimation des appareils difficiles à mesurer (autres).

Avant de commencer ces trois étapes, la phase initiale consiste à lister les différents types d'équipements présents sur le site et de les répartir dans les trois catégories ci-dessus.

Le but est de pouvoir calculer deux indicateurs de performance ou KPI[note 3] :

- l'indicateur d'efficacité énergétique ou PUE (Indicateur d'efficacité énergétique)[note 4], qui est le rapport entre la puissance d'entrée et la charge informatique[17] ;

- le rendement de l'infrastructure ou DCiE[note 5] du centre de calculs[18].

Concernant l'étape deux, les ressources partagées sont aussi appelées : sous-systèmes « mixtes ». Par exemple, la climatisation est commune au matériel informatique, mais également au bureau du personnel. Il est nécessaire dans ce cas, de réaliser une estimation de la perte que cela engendre et de la prendre en compte dans le calcul du PUE[19].

Pour la dernière étape, il est à noter qu'il n'est pas toujours facile de classifier ces sous-systèmes. Il faut donc réaliser une estimation de cette consommation et la déduire de la sortie de l'onduleur. Le résultat donnera la charge informatique. Ces pertes sont ensuite intégrées à la charge de l'infrastructure lors du calcul du PUE. En faisant de la sorte, cette imprécision est ainsi compensée[20].

Modèles et Outils de suivi et de calculs

De plus en plus de projets sont initiés pour diminuer la consommation de ces centres. L’efficacité énergétique devient un enjeu[21]. Au niveau européen, c'est le projet CoolEmAll, financé par la Commission européenne, qui a élaboré des modèles de centres (matériel et logiciel) et différents outils (en open source)[22]. Ces applications ont été mises à disposition des entreprises pour évaluer l’efficacité énergétique et l’empreinte carbone combinées de l'ensemble des équipements du site (tous les sous-systèmes). Le but de ces outils de suivi et de calculs étant, comme le souligne Georges Da Costa dans sa thèse, de répondre à l'attente des différents acteurs. Par exemple, le constructeur sera plutôt intéressé par la consommation du centre de calculs pour en définir son dimensionnement, l'opérateur quant à lui observera l'OPEX... Il faudra donc trouver le juste milieu entre tous ces différents KPI.

Affinement des modèles

L'évaluation de l'efficacité peut aller encore plus loin, détaillée ci-dessous[23]. Pour affiner cette analyse, différents types de modèles sont définis, modèles liés au matériel constituant un centre de calculs. Un autre point est à noter, le fait que la consommation d'un serveur peut varier en fonction :

- de son utilisation : machine virtuelle, ressources partagées;

- de la fréquence à laquelle travaille le processeur;

- de la gestion de la ventilation (alimentation interne ou externe des ventilateurs);

- du voisinage d'un serveur (impact de la température de l’un sur l’augmentation de la température de l’autre).

Cette seconde étude liste de nouveaux indicateurs de performance en plus des deux précédents :

- EDC[note 6]: consommation énergétique d'un centre de calcul;

- EWR[note 7]: gains potentiels au niveau de la gestion des machines et des logiciels;

- Prod Productivity : productivité (utilisé pour comparer deux centres de calculs ayant le même domaine d'application);

- RCILO,HI[note 8]: qualité du refroidissement des serveurs;

- IoT[note 9]: différentiel de température entre les processeurs;

- CAPEX[note 10]: dépenses d'investissement pour l'achat et la mise à jour du matériel;

- OPEX[note 11]: dépenses opérationnelles liées à la consommation électrique dans le cas des centres de calculs;

- CO2[note 12]: impact écologique.

De même après le côté matériel, des modèles peuvent être établis au niveau applicatif (surtout au niveau machine virtuelle). En prenant en compte le détail de leur fonctionnement et surtout de leur consommation. Par contre, l'utilisation de machine virtuelle implique un partage au niveau matériel. difficile à identifier, d'où une gestion assez complexe.

Un modèle en cours de développement s’appuie sur l'intelligence artificielle : Google édite un livre blanc dans lequel il détaille le fait que la gestion de ses centres peut être suivie par une machine qui grâce à des algorithmes, adapterait les besoins en énergie en fonction de la charge des différents équipements[24]. Cette machine, appelée « réseau neuronal », anticiperait et régulerait ainsi l'énergie nécessaire. D'après cette étude, les prévisions de l'indicateur d'efficacité pourraient être définies avec une précision de 0,4 %[25].

Autres Classements et influence

L'Uptime Institute, seul organisme en 2015 à délivrer des certifications de centre de données, classe les centres par niveaux :

- niveau I - Basique

- Site qui ne dispose pas de redondance.

- niveau II - Redondance

- Les composants sont redondants, mais pas les distributions (électricité et froid).

- niveau III - Maintenabilité

- Tous les composants et circuits de distribution sont redondants. Aucune maintenance ne doit provoquer d'arrêt, mais certains incidents peuvent interrompre le système informatique.

- niveau IV - Tolérance aux pannes

- Même un incident grave (comme un incendie) ne doit avoir de conséquences sur le fonctionnement du centre.

L'enjeu environnemental est devenu tellement omniprésent qu'il s'invite à présent dans ce classement. Par exemple, l'entreprise Interxion fait apparaitre en plus du niveau de Tier, la prise en compte du développement durable dans le détail de leur offre commerciale[26].

Quelques exemples d'évaluation

À la mise en place de ces différents indicateurs et plus particulièrement l'indicateur d'efficacité énergétique, en 2008 Google annonçait ses premières mesures. Résultat, l'indicateur moyen de ses différents centres de calcul était à 1,21. Alors qu'à cette même période les valeurs communes se situaient autour d'un PUE à 2, voire plus pour d'autres entreprises. En 2011, ce chiffre atteignait des valeurs situées entre 1,5 et 1,2[27].

Optimisation des logiciels

La volonté d'économiser de l'énergie dans les centres de calcul par des procédés logiciels reste complexe. La notion de proportionnalité énergétique[28] entre en jeu avec le souhait de rendre les serveurs disponibles à la demande et de les gérer de manière dynamique en fonction de la charge de travail. C'est dans ce but que plusieurs recherches ont été réalisées afin d'optimiser les logiciels. Quelques-unes de ces recherches sont abordées dans ce chapitre. Cependant il faut savoir qu'en dépit de leurs promesses théoriques, ces solutions sont rarement utilisées car le besoin de réponse rapide des équipements pour respecter les contrats de service[note 13] prend le dessus sur la politique écoénergétique. En effet, ces contrats exigent des opérateurs de fournir des services en respectant un certain délai et malheureusement, la réduction de la capacité peut modifier la qualité de service[29].

Planification des tâches

Parallèlement aux avancées techniques en matière de virtualisation, de nouveaux algorithmes ont été pensés pour répartir de manière temporaire la charge de travail vers des serveurs écoénergétiques et plus particulièrement vers des centres de données de type HPC[note 14] - [30]. Ces centres de données sont optimisés pour des applications demandant une intensité de calculs importante avec des traitements de gros volumes de données. Ils ne sont en général exploités qu'entre 60 % et 80 %[30]. De plus la virtualisation est très utilisée dans les centres de données pour permettre une transparence matérielle pour exécuter n'importe quel logiciel sur n'importe quelle plate-forme et ainsi avoir moins d'équipements pour réduire la consommation d'énergie[31].

La notion de planificateur de tâches doit permettre de faire une estimation du temps d'exécution des tâches et doit être capable de décider s'il peut répondre ou non aux critères de réalisation de ces tâches liés aux contraintes des contrats de service[note 13] - [31] - [32]. Ainsi, le décalage entre le temps d'exécution estimé et le temps réel d'exécution est mesuré et un travail est fait afin d'améliorer l'efficacité énergétique. De ce fait, des algorithmes sont utilisés et ont pour fonction de lisser la charge de travail permettant de mettre hors tension des serveurs plus longtemps et ainsi économiser considérablement de l'énergie[33] tout en restant performants. Trois algorithmes (SCINT[note 15], FCFS-backfill[note 16], EDF-LRH[note 17]) sont utilisés dans ce cas[30]. D'autres algorithmes tels que MinHR[34] et XInt[note 18] - [35] sont combinés aux précédents et traitent les problèmes de recirculation de chaleur afin de mieux répartir la température.

Par contre, dans certains cas, il n'y a pas que la réduction de la consommation d'énergie qui est la seule visée mais aussi la réduction du coût de l'électricité. Deux idées principales ressortent de cette volonté de faire des économies. La première est de planifier des tâches par lots dans plusieurs centres de données géographiquement différents. On parle alors de centres de calcul géographiquement distribués. Et la deuxième est de transférer les serveurs économes en énergie vers des zones géographiques offrant des prix d'électricité moins élevés[32]. L'algorithme de planification GreFar (Geographical Cost Minimization with Thermal Awareness, « minimisation des coûts géographiques et sensibilisation thermique ») est proposé dans ce cas. GreFar peut économiser jusqu'à 16 %[32] du coût de l'énergie en traitant des opérations en priorité sur des serveurs économes en énergie géographiquement sur différents sites et lorsque les prix de l'électricité sont les moins élevés[36]. Une simulation avec trois modèles utilisés[37] a prouvé que GreFar réduit le coût de l'énergie ainsi que la consommation en énergie du système de refroidissement[38].

DIMMer

Un gaspillage d'énergie est engendré par une faible utilisation des composants des serveurs, qu'ils soient utilisés ou non. La solution DIMMer a pour objectif de diminuer cette consommation d'énergie en identifiant les composants non utilisés[39]. Avec cette solution, ce sont les mémoires qui sont visées avec la volonté de les mettre hors tension afin d'éliminer l'énergie nécessaire à l'auto-rafraîchissement de mémoire non-allouée. La solution a pour action de couper l'alimentation de la mémoire DRAM[40] libre et la mémoire DIMM[40] utilisées par les processeurs.

Une estimation de 50 % d'économie sur les DRAM et 18,8 % sur les processeurs peut être faite avec DIMMer[39]. Un exemple de traces collectées sur un centre de données Google avec 12 000 serveurs à intervalles de 5 minutes pendant un mois[41], montre que 50 % de la DRAM peut être non utilisée et finalement pourrait être éteinte, d'où l'efficacité de DIMMer[40]. Cependant, il faut savoir que la mise en place de DIMMer n'est pas complètement transparente et nécessite des modifications de l'OS Kernel et une nouvelle configuration matérielle. Malgré cela, la solution est une bonne occasion de réduire la consommation d'énergie sans impact sur la performance globale.

eStor

Le constat reste identique : une partie de l'énergie est gaspillée par des équipements en repos. L'objectif ici est de désactiver certains serveurs et de réorienter la charge de trafic afin d'économiser de l'énergie, le tout avec toujours une contrainte de disponibilité des données[42]. Le matériel sur lequel se concentre cette solution est le système de stockage. Le principe de l'étude est de jouer avec les espaces de stockage mais en même temps de pouvoir répliquer les données par sécurité pour ne pas en perdre. C'est le principe de parallélisme de reconstruction des données, ou principe de reconstruction des données en parallèle, qui signifie qu'un nombre de serveurs peut participer au processus de réparation de données perdues ou défaillantes en utilisant des répliques. Cette multiplication de données identiques assure ainsi une sécurité.

Deux stratégies ont été identifiées : la première avec une disposition aléatoire de données avec un parallélisme de reconstruction élevé de ces données mais avec moins de serveurs mis hors tension, la seconde stratégie avec une disposition séquentielle de données avec un grand nombre de serveurs mis hors tension mais avec un faible parallélisme de reconstruction des données. La solution eStor est proposée pour répondre à ces deux stratégies. C'est une sorte de compilation avec une partie des données stockée séquentiellement et une autre partie de façon aléatoire et au besoin de mettre hors tension un grand nombre de serveurs avec en même temps une reconstruction élevée du parallélisme[42]. Des tests ont été réalisés pour définir la performance de cette solution qui doit répondre aux trois critères suivants :

- Économe en énergie en désactivant un certain nombre de serveurs;

- Analyse du parallélisme de reconstruction des données à partir de la disposition des données[43] - [44];

- Répondre à la notion de popularité des données(les données les plus demandées) avec la condition simple de ne pas éteindre deux serveurs voisins[43] - [45].

Un exemple est donné concernant la politique de disposition de données eStor avec pour chaque objet, trois répliques de données stockées dont deux de façon séquentielles sur des serveurs voisins et la troisième donnée de façon aléatoire sur un autre serveur[44]. Certains algorithmes sont également présentés dans ce but[44] - [45]. L'expérimentation a été faite sur un environnement Hadoop basé sur un cluster à 24 serveurs avec une configuration bien déterminée[45]. Elle s'est réalisée selon trois axes :

- Efficacité énergétique[46]

- Les chercheurs pensent que leur solution eStor de gestion de données peut réduire assez de serveurs en fonctionnement pour économiser de l'énergie;

- Tolérance aux pannes[46]

- La solution eStor peut participer au processus de reconstruction des données;

- Popularité des données[46]

- Une bonne prise en compte faite par une stratégie de mise en pages des données.

Finalement, eStor est une stratégie combinant plusieurs procédés qui permettent de désactiver un grand nombre de serveurs économisant ainsi de l'énergie.

Gestion des états de sommeil des équipements

Le principe est de mettre les serveurs dans une sorte d'état de sommeil avec une consommation énergétique faible pour faire des économies[47]. C'est le principe de la gestion dynamique de l'alimentation. L'étude se fait selon trois critères :

- traçage de la charge de travail ;

- type de politique de gestion de l'énergie utilisée ;

- taille du centre de calcul.

Le test a été réalisé avec une configuration à 24 serveurs. Un état des lieux est fait avec un dur constat sur le gaspillage de l'énergie avec près de 60 % ou plus de puissance maximale perdue qui est utilisée par des serveurs en veille. La politique actuelle de gestion de l'alimentation des centres de calculs est en mode Always On[note 19]. C'est-à-dire, que le choix est fait de laisser autant de serveurs en fonctionnement pour répondre à un pic de besoin[47]. L'objectif de l'étude est de mesurer l'efficacité des états de sommeil avec un calcul de la puissance consommée pendant cette période.

De premiers tests, appelés Reactive[48] et SoftReactive[48], ont été réalisés en fonction des changements de charge en mettant en veille les serveurs lorsque la charge diminue et en les rallumant lorsque la charge augmente. Une comparaison est faite entre les modes Reactive et SoftReactive et le mode AlwaysOn avec l'introduction d'une métrique NPPW[note 20]. La valeur de NPPW augmente alors jusqu'à 50 %, aussi bien en mode Reactive que SoftReactive pour une taille importante de centre de calculs, le nombre de serveurs passant dans ce cas de 14 à 140[49].

Une autre étude couple la gestion des états de sommeil avec une gestion de file d'attente des différentes tâches[50]. La gestion des files d'attente se fait selon des modèles respectant le processus de Markov. Dans ce cas, la mise en sommeil des serveurs est plus finement définie avec deux modes :

- un mode veille (serveurs endormis)[50] : il présente une faible consommation d'énergie et permet une réactivation rapide ;

- un mode désactivation (serveurs désactivés)[50] : il nécessite un redémarrage en cas de besoin, donc un temps d'activation plus long.

Le modèle de gestion de file d'attente proposé est un modèle polyvalent pour les centres de calcul avec toujours la même contrainte de répondre à la fois à l'efficacité énergétique et à la performance. D'autres études ont été réalisées avec le même objectif[51] - [52].

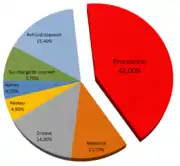

Gestion des prévisions dynamiques des temps d'inactivité des processeurs

Les processeurs sont les plus gourmands dans la consommation énergétique des centres de calculs[53]. Sachant qu'un processeur ne fonctionne jamais à 100 % du temps, la consommation d'énergie pendant les périodes de repos est importante en raison du courant de fuite. De plus, le fait de rendre inactif un processeur n'est pas toujours le bon choix si son mode de veille nécessite un temps de réveil trop long, voire plus long que sa période de repos[53].

Le but de cette étude[53] est de prévoir de façon dynamique les périodes de repos pour faire une estimation des périodes d'inactivité du processeur pour choisir l'état de sommeil le plus approprié[53]. Le meilleur choix donnera la meilleure économie d'énergie. Le schéma proposé par cette solution permet d'économiser de 10 % à 50 % de puissance par rapport au DVFS[note 21]. Trois types de tests ont été réalisés avec des modèles de temps de repos court, moyen et long avec une amélioration de la consommation d'énergie respectivement de 10 %, 25 % et 45 %[54]. Mais les tests ne s'arrêtent pas là[54] et une prochaine étape est l'intégration de ces modèles sur des outils de simulation comme CloudSim[55] ou BigHouse[56] pour réaliser des études futures.

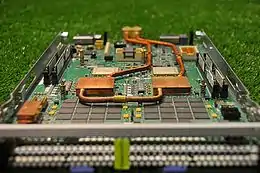

Optimisation du matériel

Les différents aspects de l'optimisation matérielle ont pour but de vouloir réduire la consommation énergétique. Les chercheurs travaillent sur cette optimisation à tous les niveaux matériels : sur la position géographique des baies (projet CoolEmAll[57]), sur les liaisons internes entre serveurs (projet OSA[note 22]), sur une meilleure gestion des ventilateurs des serveurs pour réduire la consommation, sur l'utilisation d'un mode différent d'alimentation électrique... Parfois, la frontière entre l'optimisation du matériel et l'optimisation du logiciel reste mince. Par exemple, un algorithme (le logiciel) peut gérer un nouveau système de refroidissement de serveurs (le matériel) ainsi que leurs mises en veille. Le principe de refroidissement classique utilise l'air et pose un problème d'efficacité avec la recirculation d'air chaud. Mais de nouveaux serveurs avec un refroidissement par liquide plus performant peuvent être utilisés[58]. Un algorithme comme SmartPlace[note 23] peut piloter le déploiement de ce type de serveurs et minimiser la consommation d'énergie. Les résultats montrent qu'avec cet algorithme, on peut atteindre jusqu'à 26,7 % d'économie avec un retour sur investissement au bout de trois ans[59]. Les différentes études présentées ne sont pas exhaustives mais permettent d'avoir une idée des différentes recherches déjà réalisées.

Projet CoolEmAll

CoolEmAll est un projet qui a été financé par la commission Européenne[57]. À partir de simulations et de modélisations, il avait pour objectif de fournir des outils utiles pour les concepteurs de data center mais aussi pour les exploitants et chercheurs, le tout avec une interaction entre le hardware, software, l'énergie nécessaire et le refroidissement à utiliser[60]. C'est un projet qui a commencé en 2011 et qui a fonctionné pendant 30 mois jusqu'en 2014. Le constat a été fait que l'impact énergétique est une préoccupation majeure avec une consommation représentant 2 % de la consommation énergétique mondiale[60]. Pour avoir une idée, elle est équivalente au besoin de l'industrie aéronautique en 2008[60]. Il faut savoir qu'en 2012, plus d'un tiers des centres de données consommaient plus d'énergie pour le refroidissement et les infrastructures que pour la partie informatique elle-même[60]. Il y a une perte d'efficacité énergétique. Des études ont donc été faites sur ce phénomène et pour résoudre ces problèmes, le projet CoolEmAll est né. Son objectif est de combler le fossé entre l'informatique et les installations. Le projet propose deux solutions[61] :

- Fourniture de modèles de blocs de construction DEBB[note 24] - [62]

- C'est une description abstraite d'un matériel ou de composants définissant un bloc de données d'un data center. À partir de ce concept, le DEBB a été modélisé sur la base d'une architecture RECS[note 25] - [63] qui est un système informatique multi-nœuds développé par Christmann[64].

- Fourniture d'outils de centre de données SVD toolkit[note 26] - [62]

Le projet a également proposé une contribution aux métriques d'efficacité énergétique déjà existantes. Les tests de cette étude sont réalisés à partir de modèles utilisés dans la conception et la gestion des outils :

- Le modèle de puissance[65]

- C'est un élément clé pour le développement et la maintenance de Data Centers écoénergétiques. Ce modèle permet d'estimer la dissipation de puissance de l'application avec une granularité élevée de la mesure.

- Le modèle de refroidissement[66]

- Il a pour objectif de calculer la puissance de l'équipement de refroidissement et d'autres dispositifs électriques dans un centre de données en fonction de la charge de travail informatique. Ce modèle a été construit sur la base d'équations thermodynamiques de base[66].

L'utilisation de ces modèles peut améliorer les mesures de compteurs d'énergie[65]. Le projet CoolEmAll utilise donc un ensemble de métriques avec différents niveaux d'analyse pour effectuer les différentes mesures en fonction des tests à réaliser[67]. À partir de toutes ces données, différents tests ont été réalisés avec cinq types de processeurs basés sur l'architecture RECS[note 25]. De plus, des outils tels que FFT[68], Abinit[68], C-Ray[68] ont été utilisées pour ces simulations ainsi que le simulateur DCworms[note 27] - [69] - [70]. Les expériences valident les politiques de gestion des ressources proposées et les mesures d'efficacité énergétique[71] - [72].

Autres projets existants

Au niveau matériel, d'autres projets ont pour objectif d'améliorer la consommation énergétiques, dont les suivants.

Depuis , le projet européen Mont-Blanc a eu pour objectif de concevoir un nouveau type d'architecture informatique capable de définir les futures normes mondiales dans le domaine écoénergétique[73]. C'est la commission Européenne qui a financé ce projet jusqu'en septembre 2016 dans le cadre du programme Horizon 2020. Ce projet s'est déroulé en trois phases avec une troisième phase qui devait s'assurer que les innovations matérielles et systèmes soient facilement traduites en avantages pour les applications HPC[note 14] - [74]. Ce projet vise à concevoir une nouvelle plate-forme HPC capable de fournir un nouveau niveau de rapport performance / énergie lors de l'exécution d'applications réelles.

Le projet Watcher[75] de chez b<>com[76] est destiné à fournir une solution d’optimisation de la consommation des ressources matérielles des data centers. L'objectif de ce projet est l’optimisation du placement des machines virtuelles en améliorant le gestionnaire d'infrastructure. Watcher propose une réorganisation via un algorithme qui utilise des mécanismes de prédiction pour identifier les traitements futurs.

Optical Switching Architecture (OSA)

L'optical switching architecture (OSA, ou architecture de commutation optique) est une technologie qui joue sur la flexibilité des liaisons[77]. Elle s’appuie sur une reconfiguration à chaud des périphériques en modifiant de façon dynamique la topologie et la capacité des liaisons optiques, le tout pour coller au plus près de façon dynamique à la demande de trafic. Cette technique est possible par une gestion complémentaire des ports optiques avec la mise en place d'une fonction « circulateur » pour une transmission simultanée des données dans les deux sens[77]. Cette étude a été réalisée en deux étapes :

- simulation d'analyses sur une configuration appelée OSA-2560[78] ;

- expérimentation réelle sur une maquette[79].

Dans les deux cas, les chercheurs ont réalisé des mesures pour déterminer la meilleure bande passante (qui est appelée bande passante de bissection) en jouant sur la flexibilité de la topologie. Les résultats de ces tests indiquent une bande passante élevée de 60 à 100 %. Comme précisé dans l'étude, ces résultats montrent la faisabilité du prototype OSA[80].

Introduction de l'alimentation en courant continu 380 V

L'utilisation d'une alimentation en courant continu 380 V permettrait d'économiser plus d'énergie que le courant alternatif[81]. En 2016, une expérimentation est en cours au Japon[82] dans le cadre de projets comme le Green IT Project[83] sponsorisé par l'organisation NEDO. Les tests ont démontré une amélioration de l'efficacité de 4 % à 8 %[82]. Pour optimiser cette solution, il faut la coupler avec une source d'énergie solaire[84].

Gestion des ventilateurs sur les micros serveurs

La gestion des ventilateurs sur les micros serveurs porte sur l'utilisation de l'énergie dans la gestion thermique des micros serveurs et leur impact sur la consommation énergétique globale d'un data center[85]. Du point de vue des fournisseurs de matériels, il y a également une volonté de réduire les coûts de refroidissement et aussi de réduire le PUE[note 4]. Une solution récente est d'utiliser des micros serveurs basés sur une architecture à faible consommation[85]. Des modèles ont été nécessaires pour simuler la charge d'un data center afin de permettre l'étude de la dissipation de chaleur et une meilleure utilisation des ventilateurs.

L'objectif principal est de configurer la gestion des ventilateurs pour minimiser la consommation globale et de proposer des modèles à utiliser sur les serveurs des centres de calcul. Cette gestion doit se faire sur un principe de prédiction des changements de température en réduisant au maximum les temps de surchauffe afin d'éviter une détérioration des composants. De nouvelles métriques telles que le PUE[note 4] niveau 4 ont été proposées car les chercheurs ont considéré que le PUE n'était pas suffisant[86]. L'expérimentation s'est faite de la manière suivante :

- utilisation d'un système RECS[63]: Ce système est en quelque sorte une boîte de calculs qui peut héberger de 6 à 18 serveurs avec toute une architecture de ventilateurs qui fonctionnent autour ;

- deux modèles de bases (puissance et thermique): Ils sont utilisés pour définir un nouveau modèle thermique pour réaliser les différents tests[87] ;

- utilisation du simulateur DCworms[note 27] - [69].

Par principe, trois méthodes de tests ont été utilisées en jouant sur les vitesses des ventilateurs : une vitesse constante de 30 % ou 100 %, une vitesse variable et pour finir une vitesse dynamique[88]. La difficulté a été de trouver un compromis entre la vitesse des ventilateurs pour réduire la consommation d'énergie et les périodes de haute température qui sont néfastes aux serveurs et qui provoquent des erreurs[89]. En conclusion, cette étude a montré que la gestion des ventilateurs par principe de prédictions permet d'économiser 12 % d'énergie. Mais l'étude ne veut pas en rester là et permettre à terme une gestion plus automatique pour minimiser la consommation d'énergie.

Alimentation par énergies renouvelables

Si les choix architecturaux et les optimisations tant logicielles que matérielles ont pour but de réduire la forte consommation électrique des centres de calculs, l'emploi de sources d'énergie vertueuses va permettre de réduire l'empreinte écologique et le poids fiscal (taxe carbone) importants de ce besoin toujours plus important. Des mesures incitatives et la progression de la production de nouvelles sources d'énergie renouvelable conduisent à une baisse des coûts à l'achat ou en investissements[90]. L'exemple de l'énergie éolienne est représentatif : fin 2015, 40 % de la demande nationale était satisfaite via cette source au Danemark, 20 à 30 % au Portugal, en Irlande et en Espagne[91].

Domaine expérimental

Des expérimentations ont été menées à partir de sources d'énergie vertes comme l'énergie solaire[92] - [93] - [94], éolienne[95] - [96] - [97], hydroélectrique[97], géothermale[97], en mixant plusieurs sources comme au National Renewable Energy Laboratory (NREL)[note 28], situé à Golden, Colorado aux États-Unis (solaire et éolien), ou encore à GrenoblIX 2, premier centre de calcul écologique français qui a vu le jour en , alimenté par des panneaux solaires, de l'énergie hydroélectrique et éoliennes, et refroidi grâce à l'eau d'une nappe phréatique peu profonde[98].

Grands acteurs de l'industrie informatique

De nombreuses grandes entreprises utilisent aujourd'hui des sources renouvelables pour alimenter leurs centres de données, telles que Microsoft à Dublin en Irlande[96] (éolien) ou Facebook à Prineville dans l'Oregon aux États-Unis[99] (solaire). Apple alimente déjà ses centres de calculs avec 100 % d'énergies renouvelables[97] sur ses 5 sites américains : Maiden (Caroline du Nord), Austin (Texas), Prineville (Oregon), Newark (Californie), Reno (Nevada), et ses 2 sites européens : Cork (Irlande) et Munich (Allemagne)[100]. À Maiden, en Caroline du Nord (États-Unis), 1 km2 de terrain dédié à des panneaux photovoltaïques, couplés à des piles à combustible alimentées par du biogaz[97] permettent de pourvoir à 60 % de l'énergie nécessaire à ce centre. Les 40 % restants proviennent d'opérateurs locaux spécialisés en énergies renouvelables[101].

Coefficient d'énergie verte

Différents organismes gouvernementaux américains, japonais et européens ainsi qu'un consortium industriel (The Green Grid)[102] ont établi en une nouvelle métrique, afin de quantifier la part d'énergie renouvelable consommée, le coefficient d'énergie verte (GEC, « green energy coefficient »). Il s'agit du rapport entre la somme des énergies renouvelables (en kilowatts-heures) et l'énergie totale consommée, calculée de façon identique au PUE.

Soit la somme des énergies renouvelables consommées et la somme totale de l'énergie consommée par le centre de calcul :

Classification

Le choix de la politique d'approvisionnement dépend de la capacité d'investissement de l'opérateur, la facilité et le coût de la mise en œuvre, et surtout la possibilité de faire évoluer facilement la capacité du site en énergies renouvelables[103]. En complément de la classification de l'Uptime Institute qui mesure leur efficacité, les centres de calculs peuvent être classés suivant la politique d'approvisionnement adoptée[104] :

- Les centres qui génèrent leur propre énergie renouvelable

- L'avantage de produire sur place est le peu de perte puisque la puissance subit moins de conversions et n'est pas transmise sur de longues distances. Mais il est difficile de conjuguer tous les facteurs qui interviennent dans l'emplacement optimal d'un centre de calcul (latence du réseau, disponibilité de la main d’œuvre, structures fiscales) avec les lieux qui ont les meilleurs potentiels de production d'énergie renouvelable.

- La source est sur place :

- énergie thermique produite à partir de capteurs solaires;

- électricité produite par des panneaux photovoltaïques, éoliennes ou des turbines hydrauliques;

- énergie thermique extraite de sources de chaleur ambiantes (air, sol ou eau) par des pompes à chaleur.

- La source est hors-site : la source d'énergie est fournie de l'extérieur, mais la production d'énergie utilisable se fait sur place

- biomasse;

- biogaz.

- La génération hors-site

- Dans cette approche, l'opérateur du centre effectue un investissement à long terme dans une usine de production d'énergie renouvelable dans un endroit où la ressource est abondante. Le transport entraîne des pertes d'énergie.

- Achat d'énergie à un tiers

- L'opérateur n'est pas un participant actif à la production électrique. Un système de certificat de suivi de l'électricité permet de certifier l'origine de l'énergie :

- en Europe, le certificat principal est le Guarantee of Origin (en);

- aux États-Unis, le Renewable Energy Certificates (en).

L'opérateur peut également conclure un contrat avec un fournisseur d'électricité qui détermine la quantité d'électricité que le fournisseur s'engage à produire, la vente directe d'électricité. Par exemple, Google a conclu un contrat d'achat de 114 MW d'énergie éolienne pendant 20 ans pour alimenter le centre de calcul de Council Bluffs, Iowa aux États-Unis[105]. Pour alimenter en partie son centre de calcul de Dublin en Irlande, Microsoft achète également de l'énergie éolienne[106].

L’intermittence de la production énergétique

La disponibilité des énergies renouvelables est par essence intermittente : la production solaire dépendra du taux d'ensoleillement et sera nulle la nuit, la production des éoliennes est fluctuante puisque dépendante de la force du vent. En complément des optimisations des logiciels et des matériels qui permettent de réduire la consommation énergétique, les opérateurs doivent donc adapter leurs infrastructures pour répondre à cette nouvelle contrainte[107] - [108].

- Réponse logicielle

La gestion du centre de calcul (machines et applications) et la gestion électrique sont décorrélées : ce sont deux centres de décision différents qui travaillent sans interaction directe. Les traitements du centre de calcul doivent donc être gérés de façon que la consommation électrique soit en adéquation avec la production d'énergie via une planification dynamique de la charge de travail en fonction de la disponibilité des ressources, voire en mettant en pause le lancement des tâches[107]. De nombreux algorithmes ont été développés pour répondre à cette équation, parmi lesquels :

- GreenSlot[109], qui prédit la disponibilité de l'énergie solaire sur 48 heures et planifie les tâches en conséquence afin de limiter l'utilisation de l'énergie non renouvelable;

- GreenSwitch[110], qui planifie dynamiquement les traitements et effectue un choix entre énergie renouvelable ou non suivant la charge de travail, la configuration technique du centre de calcul (puissance maximale, batteries) et le coût des énergies. Cet algorithme a été testé sur un prototype de recherche de centre de données alimenté par panneaux solaires : Parasol[111];

- OL-PICEA-g[112], algorithme multi-objectif d'ordonnancement des tâches, qui maximise l'utilisation des énergies renouvelables et la qualité de service (taux de réussite des tâches), tout en minimisant la consommation énergétique totale et la durée des traitements via l'algorithme the Smart Time Scheduling Strategy[note 29], qui détermine l'heure de début et de fin des traitements suivant le nœud choisi.

- Réponse matérielle

- La pile à combustible :

Les solutions les plus classiquement développées pour produire de l'électricité à partir de sources renouvelables sont aujourd'hui les énergies solaire et éolienne associées à des batteries. Il est nécessaire de surdimensionner ces systèmes afin de répondre aux périodes critiques pendant lesquelles la production électrique est faible[94]. Pour éviter ce surdimensionnement, on ajoute généralement un générateur diesel, mais celui-ci présente deux inconvénients majeurs : le bruit et la pollution (gaz à effet de serre)[113]. La pile à combustible est une alternative intéressante : de l'hydrogène combiné à l'oxygène de l'air ambiant produit du courant capable d'alimenter les serveurs sans émission de CO2 et d'autres polluants nuisibles à la santé et à l'environnement. Par exemple, la pile à combustible associée à des systèmes photovoltaïques-batteries permet une diminution de la capacité des batteries et de la puissance crête du générateur photovoltaïque, notamment dans des régions où les variations d'ensoleillement sont très importantes selon les saisons[94]. Du gaz naturel peut également être utilisé pour produire un flux d'hydrogène pur et alimenter la pile à combustible[114].

- Les supercondensateurs :

En complément aux piles à combustible, les supercondensateurs permettent de gérer dynamiquement les déséquilibres de puissance induits par l'utilisation d'énergies renouvelables avec de nombreux avantages : faible perte d'énergie, charge et décharge rapides avec un courant élevé, durée de vie deux à trois fois plus importante que les batteries[115]. Mais ce système est très coûteux pour un déploiement à grande échelle dans les centres de calcul. Néanmoins, un retour sur investissement élevé peut être atteint via une stratégie adaptative à partir de sources hétérogènes telle que proposée par le HEB (Hybrid Energy Buffering)[116]. Comparativement à un système de batteries classique, le HEB permet d'améliorer de 39,7 % l'efficacité énergétique, de prolonger de 4,7 fois la durée de vie des onduleurs, de réduire le temps d'arrêt du système de 41 % et d'améliorer l'utilisation des énergies renouvelables de 81,2 %[117], ce qui permet d'obtenir un retour sur investissement viable.

Les centres de données modulaires

Une autre approche conceptuelle de centres de calculs verts utilise plusieurs centres en réseau distribué : les centres de traitement de données modulaires. Ils permettent de faciliter l'exploitation de l'énergie en dispersant intelligemment de petits centres près de sources renouvelables[118]. L'imprévisibilité de l'approvisionnement est ainsi résolue par l'équilibrage de la charge d'alimentation et les techniques de migration de machines virtuelles entre les centres délocalisés[119] - [120]. La conception est modulaire : ces petites structures sont assemblées, configurées, câblées, et donc prêtes à l'emploi en sortie d'usine. Elles sont ensuite transportées dans un conteneur vers le site de l'opérateur partout dans le monde. Il ne reste qu'à les alimenter en électricité, en connectivité réseau et en eau réfrigérée[121].

L'université de Cambridge (Royaume-Uni) a ainsi testé en 2011 « Free Lunch »[122], une architecture de centres de données modulaires dispersés sur deux sites ayant un fort potentiel pour la récolte de l'énergie solaire, et situés dans différentes zones temporelles et climatiques pour se compléter (près de la mer Rouge et dans le sud-ouest australien). Des éoliennes venaient compléter l'offre énergétique, une connectivité réseau à haut débit était dédiée entre les deux sites et la migration de la charge de travail étaient basée sur des machines virtuelles. Cette expérience a démontré la viabilité de la solution. Google a commencé à s'y intéresser dès 2005 et depuis, plusieurs grands acteurs du secteur ont investi dans la conception de centres de traitements modulaires[121], comme SUN (en), IBM (en), HP (en) ou Google (en).

Néanmoins, des défis sont à relever concernant le fonctionnement de la migration de machines virtuelles. Il subsiste des délais de latence (délais de réseau et de service) entre les nœuds dispersés géographiquement. Des techniques de compression de contenu ont été proposées pour diminuer le transfert de données et le délai de service[123]. De plus, la sécurité du contenu de la machine virtuelle lors de la migration est une préoccupation importante, car la machine doit migrer sur des liaisons de données vulnérables[124].

Réutilisation de la chaleur résiduelle

L'augmentation de la puissance des serveurs conduit à une exigence de dissipation thermique de plus en plus importante : cette exigence a été multipliée par environ trente fois depuis 1990[125]. La combinaison de récupération et de réutilisation de la chaleur résiduelle, notamment à partir des composants les plus puissants (les processeurs)[126], est une opportunité de réduire les coûts énergétiques associés au refroidissement des centres de données en profitant de cette source d'énergie perdue[127], et de réduire le taux d'épuisement des réservoirs de combustibles fossiles et le taux d'émission de CO2 et d'autres gaz contaminants[128] - [129]. Néanmoins, dans la plupart des cas, la température capturée reste limitée à moins de 85 °C, et cette chaleur de basse qualité complexifie sa réutilisation via des processus thermodynamiques conventionnels[125].

Les températures de capture

Les possibilités d'exploitation de la chaleur résiduelle vont dépendre de sa qualité, qui sera différente suivant la technologie de refroidissement utilisée par le centre de données.

Le point optimum pour récupérer de la chaleur dans les centres de calcul refroidis par air, qui constituent la majorité des centres actuels, pour une capture maximale d'énergie (de 35 à 45 °C) est situé directement à l'échappement de tous les serveurs, avant le mélange à l'air ambiant, ce qui est logistiquement compliqué. Il est plus facile d'opérer la capture au retour de l'unité de climatisation de la salle informatique (de 30 à 40 °C)[11].

Pour les systèmes refroidis par eau, le transfert de chaleur est plus efficace : la chaleur résiduelle est de meilleure qualité (de 60 à 70 °C) et la capture est plus facile en utilisant le flux liquide de décharge directement. Des plaques froides situées le plus près possible des composants générant de la chaleur permettent de collecter jusqu'à 85 % du rejet calorifique[130] - [131].

Sur les systèmes de refroidissement avec un réfrigérant (phase-change cooling), on obtient une chaleur résiduelle allant jusqu'à 70 à 80 °C[132]. Ce système de pompe ou compresseur qui entraîne un liquide de refroidissement a donc un potentiel exceptionnel pour la récupération de la chaleur résiduelle[133].

L'exploitation de la chaleur

Plusieurs techniques sont utilisées, selon l'objectif recherché et la capacité d'investissement des opérateurs, pour exploiter la chaleur résiduelle dans les centres de calcul :

- la production d'eau chaude sanitaire : la chaleur capturée dans des centres refroidis à l'air (de 30 à 40 °C) est suffisante pour des besoins de chauffage domestique[134]. Des chaleurs de qualité légèrement supérieure (de 50 à 60 °C) peuvent alimenter en direct un réseau de chauffage urbain[135] ;

- le refroidissement par absorption[136] et adsorption[137] ;

- la production directe d'électricité : piézoélectricité et thermoélectricité[138] - [139] ;

- la production indirecte d'électricité : cycle de Rankine[140] - [141] ;

- le dessalement : production d'eau potable à partir de l'eau de mer[142].

Le cycle de Rankine et le refroidissement par absorption sont les technologies les plus prometteuses, techniquement et économiquement, pour une optimisation de l'utilisation de la chaleur résiduelle[143].

Outils de mesure de la réutilisation énergétique

Dans la lignée du coefficient d'énergie verte (voir supra), de nouveaux instruments de mesure ont été mis au point afin d'encourager la réutilisation de l'énergie en dehors du centre de calcul plutôt que de la rejeter. On distingue deux types d'applications :

L'efficacité de la réutilisation énergétique (ERE, « energy reuse effectiveness ») est une métrique reposant sur le calcul du PUE et y ajoutant la notion d'énergie réutilisée[144]. En considérant la somme totale de l'énergie consommée par le centre de calcul, l'énergie réutilisée et l'énergie consommée par le système informatique :

Le facteur de réutilisation d'énergie (ERF, « energy reuse factor ») est une métrique qui identifie la portion d'énergie qui est exportée pour être réutilisée en dehors du centre de données[145] :

Soit

L'ERF va de 0 à 1 : la valeur à 0 signifie qu'aucune énergie n'est exportée du centre de données pour réutilisation (ERE = PUE), tandis qu'une valeur de 1 signifie que toute l'énergie apportée au centre de données est réutilisée en dehors du centre de données.

Applications dans le domaine expérimental

Au niveau de la recherche, quelques essais ont eu des résultats significatifs.

Aquasar

Premier prototype de supercalculateur à eau chaude, situé à l'École polytechnique fédérale de Zurich en Suisse, Aquasar (en) utilise un système de refroidissement composé de micros-canaux qui apportent l'eau directement sur les processeurs[146]. Cette solution permet d'atteindre une efficacité de récupération de chaleur de 80 % avec une température de l'eau à 60 °C[147]. La chaleur est récupérée pour chauffer les bâtiments et faire de la réfrigération en utilisant des machines frigorifiques à adsorption[137].

Le Colosse de Québec

Le supercalculateur de l'Université Laval au Canada installé en 2009, le Colosse de Québec est disposé de façon concentrique afin de récupérer la chaleur produite par les serveurs et faciliter la ventilation et le refroidissement. En hiver, la chaleur est récupérée via des serpentins dans le réseau d’eau réfrigérée et chauffe ainsi d'autres pavillons du campus[148]. L'infrastructure ne consomme que 30 % de l'énergie d'une salle standard, et en incluant la récupération de la chaleur, cela représente une réduction de la facture d'énergie de 200 000 $ par an pour l'université[149].

Une moissonneuse d'énergie pyroélectrique

Dans le cadre du projet ARPA-E, le laboratoire national d'Oak Ridge dans le Tennessee (États-Unis) a développé une technologie pour récolter l'énergie pyroélectrique en transformant la chaleur des processeurs en électricité. Une structure en porte-à-faux d'un millimètre de large repose sur l'élément chauffant. À mesure qu'elle se réchauffe, elle se déforme jusqu'à toucher un dissipateur de chaleur. Refroidie, la structure se replie pour toucher à nouveau la surface chaude. Les oscillations rapides créent un courant alternatif d'une puissance de l'ordre de 1 à 10 mW, et peuvent permettre de générer des quantités considérables d'énergie puisqu'un processeur d'une surface de 6,5 cm2 peut accueillir 1 000 de ces convertisseurs, tout en étant une aide au refroidissement[150].

Data furnace

Une autre approche propose de remplacer les grands centres de calcul par des « micro-centres de données » distribués à petite échelle, utilisés comme source principale de chauffage domestique dans des maisons individuelles, des complexes d'appartements ou des immeubles de bureaux[134]. Une armoire métallique est installée dans l'habitation et branchée aux conduites d'eau chaude comme pour un système de chauffage classique. Les bénéfices du concept Data furnace (en)[note 30] sont multiples : une empreinte carbone plus faible en diminuant la part de consommation d'énergie consacrée au chauffage domestique, une réduction substantielle du coût des serveurs pour l'opérateur (gain de 280 à 325 $ par an et par serveur selon une estimation[151]), et une proximité accrue des utilisateurs. Mais la répartition géographique des serveurs conduit à des difficultés de maintenance, de sécurisation du parc, et une limitation de la bande passante du réseau.

Les centres de données modulaires

Tout comme le placement intelligent de centres de données modulaires permet d'optimiser l'exploitation de sources d'énergies renouvelables, ces modules peuvent être placés à proximité d'un site de récupération de chaleur[121]. Lorsqu'ils en sont éloignés, la chaleur résiduelle peut être utilisée comme source pour un système de refroidissement par absorption intégré au module[152].

Mises en place effectives

La réutilisation de la chaleur des centres de calcul est en pleine évolution et de nombreuses initiatives sont déployées dans le monde. Pour illustrer cette tendance, on peut citer :

- le Centre de recherche en informatique de l'université Notre-Dame-du-Lac en Indiana aux États-Unis a placé une baie de serveurs dans une serre municipale locale pour aider à chauffer les plantes et les fleurs[153];

- dans le même esprit, le centre de données Condorcet à Paris chauffe un arboretum récréant les conditions climatiques méditerranéennes afin que les scientifiques de l'Institut national de la recherche agronomique (INRA) étudient l'évolution du changement climatique[154];

- à Bailly-Romainvilliers dans le département de Seine-et-Marne, les rejets thermiques d'un centre de calcul permettent de subvenir à 90 % des besoins en chaleur du parc d'entreprise et d'un centre aquatique voisins[155];

- à quelques kilomètres, à Champs-sur-Marne, le centre de données Marilyn recycle la chaleur pour chauffer des bureaux, salle de sport, douches et alimente un système d'arrosage grâce à la condensation[156] - [157];

- enfin, l'université d'Amsterdam, aux Pays-Bas, reçoit une eau gratuitement chauffée provenant de la chaleur résiduelle du centre de données Equinix[158].

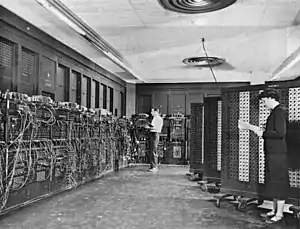

Historique

C'est en présentant l'ENIAC en 1946 que la notion de data center est introduite. Créé par le laboratoire de balistique de l’Armée américaine, cet ordinateur disposait à l'époque de 0,05 MIPS (million d'instructions par seconde). Il est entouré d'autres équipements qui lui offrent des capacités de stockage, mais dispose aussi d'équipements d'énergie permettant de sécuriser son alimentation (consommation 1 500 kW). Suivra en 1954 le CDC 6600 construit par Control Data Corporation. L'ère du transistor est née.

En 1973 le premier réseau local est créé, appelé ARCnet. L'interconnexion d'équipements informatiques devient possible.

Puis arriveront les années 1980 et le développement des premiers ordinateurs personnels ou PC. Les années 1990 et les débuts d'internet, apporteront les premières applications client/serveur : le début des premiers data centers, mais aussi l'apparition des premiers supercalculateurs, qui font partie de la même catégorie[159]. En effet, ils sont assimilés à des centres de calculs. Cray-2 (en) mis en service pour le compte de Météo-France a connu une évolution en 2014 (remplacé par BULL B710 DLC) offrant une capacité de calcul multipliée par 500 000 depuis la première génération[160].

En , une nouvelle classification est créée : issue du TOP500 qui liste les 500 supercalculateurs les plus puissants au monde, le Green 500 classe ces superordinateurs selon l'évaluation de leur efficacité énergétique (performance par watt). Le consortium industriel The Green Grid voit le jour la même année avec une dizaine de membres ayant comme objectif de travailler conjointement pour un secteur des réseaux informatiques plus écologique et plus efficace (en 2016, l'organisation accueille plus de 200 membres)[161].

Les conférences du SIGCOMM (en) organisées par le groupe d'intérêt spécial sur les communications de données de l'Association for Computing Machinery (organisme en systèmes d'information) sont considérées comme le plus important rendez-vous annuel en matière de réseau dans le monde. C'est en abordant le thème des centres de données lors de la conférence de 2008 à Seattle, dans l'état de Washington aux États-Unis[162], que la recherche en matière d'amélioration de la conception, la performance et l'efficacité (notamment énergétique) s'est très fortement accélérée[163]. Depuis, le développement en laboratoire de nouvelles technologies, tant au niveau matériel que logiciel, et de nouveaux concepts perfectionnant l'efficience énergétique sont mis en application industrielle effective. Cette activité continue d'être en pleine effervescence, alors que le besoin de traitement de données est de plus en plus important et conduit au développement massif des centres de calculs.

Notes et références

Termes anglophones

- Computer Room Air Conditioners (« conditionnement d'air dans les salles »)

- Close Control Units (« bloc de climatisation »)

- Key Performance Indicator (« indicateur de performance »)

- Power Usage Effectiveness (« indicateur d'efficacité énergétique »)

- Data Center infrastructure Efficiency (« rendement de l'infrastructure »)

- Total Energy Consumption (« Consommation énergétique d'un centre de calcul »)

- Energy Wasted Ratio (« gains potentiels au niveau de la gestion des machines et des logiciels »)

- Rack Cooling Index (« Qualité du refroidissement des serveurs »)

- Imbalance of CPU temperature (« différentiel de température entre les processeurs »)

- Capital Expenditure (« dépenses d'investissement pour l'achat »)

- Operation Expenditure or Electricity Costs (« dépenses opérationnelles »)

- Carbon Emissions (embedded and power consumption) (« impact écologique »)

- Service Level Agreement (« contrats de service »)

- High Performance Computing (« Haute Performance de Calcul »)

- SCheduling to minimize thermal cross-INTerference (« Planifier pour minimiser l'interférence thermique »)

- First-Come First-Serve (« Premier arrivé Premier servi »)

- Earliest Deadline First - Least Recirculated Heat (« Echéance proche: Préparation en premier - Chaleur minimale recyclée »)

- Intelligent Thermal-Aware Algorithm (« Algorithme Intelligent "conscient" de la problématique thermique »)

- Always On (« Toujours en Fonctionnement »)

- Normalized Performance-Per-Wat (« Performance par Watt normalisée »)

- Dynamic Voltage and Frequency Scaling (« Echelle Dynamique de Tension et Fréquence »)

- Optical Switching Architecture (« Architecture de Commutation Optique »)

- SmartPlace (« Placement Intelligent »)

- Data Center Efficiency Building Block (« Bloc de Construction Efficace pour Centre de Calcul »)

- Resource Efficient Cluster Server (« Efficacité des Ressources de serveur en mode cluster »)

- Simulation, Visualisation and Decision Support toolkit (« Boîte à outils de Simulation, Visualisation et Décision »)

- Data Center Workload and Resource Management Simulator (« Simulateur de Gestion de Ressource et de Charge de Centre de Calcul »)

- National Renewable Energy Laboratory (« Laboratoire national sur les énergies renouvelables »)

- the Smart Time Scheduling Strategy (« stratégie intelligente de planification du temps »)

- Data furnace (« Chaufferie à données »)

Références

- Frédéric Bordage, Sobriété numérique, les clés pour agir, Buchet Chastel, 2019, p. 57.

- Equinix France 2016

- Lisa Rhodes 2016

- Equinix France 2016

- Da Costa 2015, p. 7.

- ActuEnvironnement.com 2016

- Eudes 2016

- Tate 2015

- Frachtenberg 2013

- Rouse 2008

- Ebrahimi 2014, p. 626

- Mark 2015

- Boutherin 2014, p. 23

- Longbottom 2013

- Daubré 2011

- Avelar 2016, p. 3.

- Avelar 2016, p. 12.

- Avelar 2016, p. 2.

- Avelar 2016, p. 10.

- Avelar 2016, p. 11.

- Shi 2016, p. 3

- Fontoura 2014, p. 535.

- Da Costa 2015, p. 15.

- Gao 2014, p. 3

- Hauet 2015, p. 64.

- Interxion 2016

- L'Informaticien 2008

- Lent 2014, p. 554

- Lent 2014, p. 563

- Mukherjee 2009, p. 2890.

- Mukherjee 2009, p. 2889.

- Polverini 2013, p. 71.

- Mukherjee 2009, p. 2903.

- Sun 2014, p. 297

- Hood 2014

- Polverini 2013, p. 72

- Polverini 2013, p. 73

- Polverini 2013, p. 81

- Zhang 2014, p. 1

- Zhang 2014, p. 2

- Zhang 2014, p. 3

- Lin 2012, p. 366

- Lin 2012, p. 367

- Lin 2012, p. 368

- Lin 2012, p. 369

- Lin 2012, p. 370

- Gandhi 2012, p. 1

- Gandhi 2012, p. 2

- Gandhi 2012, p. 10.

- JKuehn 2014, p. 498

- CIbe 1993, p. 1.

- Lui1 998, p. 19.

- Duan 2015, p. 985

- Duan 2015, p. 988

- Humane 2015, p. 207

- Meisner 2012, p. 35

- CoolEmAll 2014

- Li 2014, p. 1

- Li 2014, p. 2

- Cupertino 2015, p. 535

- Cupertino 2015, p. 536

- Cupertino 2015, p. 537

- RECS 2016

- Christmann 2016

- Cupertino 2015, p. 539

- Cupertino 2015, p. 541

- Cupertino 2015, p. 544

- Cupertino 2015, p. 547

- Kurowski 2013, p. 1

- Cupertino 2015, p. 550

- Cupertino 2015, p. 548

- Cupertino 2015, p. 549

- Mont-Blanc 2016

- Rajovic 2014, p. 322

- Watcher 2016

- b-com 2016

- Chen 2014, p. 499

- Chen 2014, p. 503

- Chen 2014, p. 506

- Chen 2014, p. 510

- Yajima 2015, p. 1

- Yajima 2015, p. 2

- Bachour 2010, p. 1

- Yajima 2015, p. 4

- Piatek 2015, p. 253

- Piatek 2015, p. 257

- Piatek 2015, p. 254

- Piatek 2015, p. 256

- Piatek 2015, p. 258

- United Nations Environment Programme 2016, p. 11

- U.S. Department of Energy 2016, p. 6

- Goiri 2013, p. 51

- De Courchelle 2016, p. 2

- Lagorse 2008, p. 2871

- Abbey 2005, p. 1

- Chen 2016, p. 47

- Chen 2016, p. 50

- E-media 2012

- Chen 2016, p. 49

- Chen 2016, p. 48

- Apple 2016

- Global Taskforce Reaches Agreement Regarding Data Center Productivity 2014, p. 13

- Oró 2015, p. 438

- Oró 2015, p. 439

- Google 2013, p. 3

- Oró 2015, p. 440

- Lei 2016, p. 103

- Cioara 2015, p. 2

- Goiri 2011, p. 4

- Goiri 2013, p. 55

- Goiri 2013, p. 54

- Lei 2016, p. 108

- Labouret 2009, p. 16

- Guizzi 2012, p. 57

- Liu 2015, p. 464

- Liu 2015, p. 468

- Liu 2015, p. 474

- Bird 2014, p. 84

- Mustafa 2015, p. 187

- Bird 2014, p. 88

- Shuja 2016, p. 206

- Akoush 2011, p. 206

- Singh 2013, p. 143

- Ali 2015, p. 368

- Ebrahimi 2014, p. 623

- Haywood 2012, p. 27

- Woodruff 2014, p. 42.

- Ebrahimi 2015, p. 385

- Marcinichen 2012, p. 36

- Carbó 2016, p. 140

- Brunschwiler 2009, p. 11:1

- Ohadi 2012, p. 4

- Marcinichen 2012, p. 50

- Liu 2011, p. 1

- Ebrahimi 2014, p. 629

- Haywood 2012, p. 26

- Zimmermann 2012, p. 241

- Ebrahimi 2014, p. 634

- Johnson 2008, p. 27

- Vélez 2012, p. 4175

- Johnson 2008, p. 26

- Li 2011, p. 118

- Ebrahimi 2014, p. 636

- The Green Grid 2010, p. 8

- Global Taskforce Reaches Agreement Regarding Data Center Productivity 2014, p. 17

- Zimmermann 2012, p. 237

- Shuja 2016, p. 199

- Itis Laval 2016

- Université Laval 2015

- Hunter 2014

- Liu 2011, p. 4

- Ebrahimi 2014, p. 631

- Miller 2008

- GreenUnivers 2010

- ADEME 2014

- Marilyn 2016

- E-media 2012

- Equinix 2016.

- Historique 2014

- Météo France SuperCalculateur 2014

- The Green Grid 2016

- SIGCOMM 2008

- Chen 2016, p. 46

Voir aussi

Bibliographie

![]() : document utilisé comme source pour la rédaction de cet article.

: document utilisé comme source pour la rédaction de cet article.

- Problématique

- Emmanuel Tetreau, « Les enjeux des datacenters aujourd’hui et demain », 2010, IBM, (lire en ligne)

- Georges Da Costa, Évaluation et optimisation de performance énergétique des centres de calcul, GIP RENATER, , 7-8 p. (lire en ligne [PDF])

- (en) Lisa Rhodes, « Green Data Center News », site web, Verne Global, (lire en ligne)

- « Datacenter : l’enjeu de l’efficacité énergétique à l’heure du Cloud », site web, TechTarget, (lire en ligne)

- Equinix France, « Usages. Enjeux. Innovation », site web, Equinix France, (lire en ligne)

- « Des milliards de kWh pour des milliards de données informatiques », 2013, ActuEnvironnement.com, (lire en ligne)

- Conception efficace

- Yves Eudes, « Dans le data center de Facebook, aux abords du cercle polaire », 2016, GIP RENATER, (lire en ligne)

- (en) Ryuhei Tate, Shinichiro Kaneko, Yosuke Mino et Masahide Yanagi, « Factor Analysis of Power-saving Effects in Air-side Economizers for Data Centers », 2015, IEEE, (DOI 10.1109/INTLEC.2015.7572487)

- Bernard Boutherin, Romaric David, Robert Ferret, Mathieu Molineris et Didier Pin, « Bonnes pratiques pour l’infrastructure d’un Datacentre éco-responsable », 2014, GIP RENATER, , p. 6,7 et 23 à 26 (lire en ligne)

- (en) Clive Longbottom, « Modern data center cooling systems: No muss, no fuss, no waste », 2013, TechTarget, (lire en ligne)

- (en) Eitan Frachtenberg, Dan Lee et Marco Magarelli, « Thermal design in the open compute datacenter », 2013, IEEE, (DOI 10.1109/ITHERM.2012.6231476, lire en ligne)

- (en) Khosrow Ebrahimi, Gerard F. Jones et Amy S. Fleischer, « A review of data center cooling technology, operating conditions and the corresponding low-grade waste heat recovery opportunities », Renewable and Sustainable Energy Reviews, Elsevier, vol. 31, , p. 622–638 (DOI 10.1016/j.rser.2013.12.007)

- (en) Margaret Rouse, « Computer room air conditioning unit (CRAC) », 2008, TechTarget, (lire en ligne)

- (en) Oleksiy Mark, « Renewable Energy and The Data Center », 2015, ACTU ENVIRONNEMENT.COM, (lire en ligne)

- Méthodes d'évaluation

- Victor Avelar, « Méthode de calcul de l’efficacité énergétique (PUE) dans les datacenters », 2016, APC by Schneider Electric, , p. 2-4 (lire en ligne)

- (en) Weisong Shi et Thomas Wenisch, « Energy-Efficient Data Centers », 2016, IEEE, , p. 2-3 (lire en ligne)

- (en) Leandro Fontoura, Georges Da Costa, Ariel Oleksiak, Wojciech Pia Tek, Jean-Marc Pierson, Jaume Salom, Laura Siso, Patricia Stolf, Hongyang Sun et Thomas Zilio, « Energy-Efficient, Thermal-Aware Modeling and Simulation of Datacenters: The CoolEmAll Approach and Evaluation Results », 2015, Ad Hoc Networks, , p. 3-4 (DOI 10.1016/j.adhoc.2014.11.002, lire en ligne)

- (en) « Développement durable », 2016, Interxion, (lire en ligne)

- « Tout se transforme... même les DATACENTERS ! », 2011, L'Informaticien, , p. 9-10 (lire en ligne)

- (en) Jim Gao, « Machine learning application for data center optimization », 2014, BibTeX / Google, , p. 3 (lire en ligne)

- Jean-Pierre Hauet, « Les data centers », 2014, TIC ET ÉNERGIE, , p. 64 (lire en ligne).

- Optimisation des logiciels

- (en) Ricardo Lent, « Analysis of an energy proportional data center », 2014, AdHocNetworks, , p. 554-564 (DOI 10.1016/j.adhoc.2014.11.001)

- (en) Marco Polverini, Antonio Cianfrani et Shaolei Ren, « Thermal-Aware Scheduling of Batch Jobs in Geographically Distributed Data Centers », 2013, IEEE, , p. 71-84 (DOI 10.1109/TCC.2013.2295823)

- (en) Tridib Mukherjee, Ayan Banerjee, Georgios Varsamopoulos, Sandeep K.S. Gupta et Sanjay Rungta, « Spatio-temporal thermal-aware job scheduling to minimize energy consumption in virtualized heterogeneous data centers », 2009, Ad Hoc Networks, , p. 2888–2904 (DOI 10.1016/j.comnet.2009.06.008)

- (en) Hongyang Sun, Patricia Stolf et Jean-Marc Pierson, « Sustainable Computing: Informatics and Systems », 2014, ScienceDirect, , p. 292-306 (DOI 10.1016/j.suscom.2014.08.005)

- (en) Bin Lin, Shanshan Li et Xiangke Liao, « eStor: Energy efficient and resilient data center storage », 2012, IEEE, , p. 366-371 (ISBN 978-1-4577-1637-9, DOI 10.1109/CSC.2011.6138549)

- (en) Olivier C Ibe et Julian Keilson, « Multi-server threshold queues with hysteresis », 2000, ScienceDirect, (DOI 10.1016/0166-5316(94)E0043-I)

- (en) John C S Lui et Leana Golubchik, « Stochastic complement analysis of multi-server threshold queues with hysteresis », 1998, ScienceDirect, , p. 19-48 (DOI 10.1016/S0166-5316(98)00043-1)

- (en) Anshui Gandhi, Mor Harchol-Balter et Michael A. Kozuch, « Are sleep states effective in data centers? », 2012, IEEE, (ISBN 978-1-4673-2154-9, DOI 10.1109/IGCC.2012.6322260)

- (en) Lide Duan, Dongyuan Zhan et Justin Hohnerlein, « Optimizing Cloud Data Center Energy Efficiency via Dynamic Prediction of CPU Idle Intervals », 2015, IEEE, , p. 985-988 (ISBN 978-1-4673-7287-9, DOI 10.1109/CLOUD.2015.133)

- (en) Dongli Zhang, Moussa Ehsan, Michael Ferdman et Radu Sion, « DIMMer: A case for turning off DIMMs in clouds », 2014, ACM, (ISBN 978-1-4503-3252-1, DOI 10.1145/2670979.2670990)

- (en) Paul J. Kuehn et Maggie Ezzat Mashaly, « Automatic energy efficiency management of data center resources by load-dependent server activation and sleep modes », 2014, Ad Hoc Networks, , p. 497-504 (DOI 10.1016/j.adhoc.2014.11.013)

- (en) Pravesh Humane et J.N. Varshapriya, « Simulation of cloud infrastructure using CloudSim simulator: A practical approach for researchers », 2015, IEEE, , p. 207-211 (ISBN 978-1-4799-9855-5, DOI 10.1109/ICSTM.2015.7225415)

- (en) David Meisner et Junjie Wu, « BigHouse: A simulation infrastructure for data center systems », 2012, IEEE, , p. 35-45 (ISBN 978-1-4673-1146-5, DOI 10.1109/ISPASS.2012.6189204)

- (en) Wolciech Piatek et Oleksiak Ariel, « Modeling Impact of Power- and Thermal-aware Fans Management on Data Center Energy Consumption », 2015, ACM, , p. 253-258 (ISBN 978-1-4503-3609-3, DOI 10.1145/2768510.2768525)

- (en) Hood, « We Didn’t Start the Fire: Using an Agent-Directed Thermal Simulator to Keep Servers Cool », ACM Digital Library, (consulté le )

- Optimisation des matériels

- (en) Hiroya Yajima, Tadatoshi Babasaki, Kenichi Usui, Yasuyuki Ooi et Keiichi Yajima, « Energy-saving and Efficient use of Renewable Energy by introducing an 380 VDC Power-supply System in Data Centers », 2015, IEEE, , p. 1-4 (ISBN 978-1-4799-6582-3, DOI 10.1109/INTLEC.2015.7572291)

- (en) Li Li, Wenli Zheng, Xiaodong Wang et Xiaorui Wang, « Placement optimization of liquid-cooled servers for power minimization in data centers », 2014, IEEE, , p. 1-10 (ISBN 978-1-4799-6177-1, DOI 10.1109/IGCC.2014.7039163)

- (en) Nikola Rajovic, Alejandro Rico, Nikola Puzovic et Chris Adeniyi-Jones, « Tibidabo: MakingthecaseforanARM-basedHPCsystem », 2014, Science Direct, (DOI 10.1016/j.future.2013.07.013)

- (en) Kai Chen, Ankit Singla, Atul Singh, Kishore Ramachandran, Lei Xu, Yueping Zhang et Xitao Wen, « OSA An Optical Switching Architecture for Data Center Networks With Unprecedented Flexibility », 2014, IEEE, , p. 499-510 (DOI 10.1109/TNET.2013.2253120)

- (en) K Kurowski, W Piatek et T Piontek, « DCworms – A tool for simulation of energy efficiency in distributed computing infrastructures », 2013, Science Direct, , p. 135-151 (DOI 10.1016/j.simpat.2013.08.007)

- (en) Wojciech Piatek, Ariel Oleksiak et Micha Vor Dem Berge, « Modeling Impact of Power and Thermal aware Fans Management on Data Center Energy Consumtion », 2015, ACM, , p. 253-258 (ISBN 978-1-4503-3609-3, DOI 10.1145/2768510.2768525)

- (en) Leandro Cupertino, Georges Da Costa, Ariel Oleksiak, Wojciech Piatek, Jean-Marc Pierson, Jaume Salom, Laura Siso et Patricia Stolf, « Energy-efficient, thermal-aware modeling and simulation of data centers: The CoolEmAll approach and evaluation results », 2015, Ad Hoc Networks, (DOI 10.1016/j.adhoc.2014.11.002)

- (en) Nathalie Bachour et Larry Chasteen, « Optimizing the Value of Green IT Projects within Organizations », 2010, IEEE, (ISBN 978-1-4244-5275-0, DOI 10.1109/GREEN.2010.5453804)

- (en) CoolEmAll, « CoolEmAll, next-gen Data Centers Tools » (consulté le )

- (en) Christmann, « PROJECT RECS » [PDF] (consulté le )

- (de) Christmann, « Christmann informationstechnik + medien » (consulté le )

- (en) Mont-Blanc, « EUROPEAN APPROACH TOWARDS ENERGY EFFICIENT HIGH PERFORMANCE » (consulté le )