Ère de l'information

L'ère de l'information (aussi connue comme ère numérique ou ère informatique) est une expression forgée par le sociologue Manuel Castells pour désigner une période historique qui débute au milieu du XXe siècle et qui est caractérisée par un rapide passage de l'industrie traditionnelle établie par la révolution industrielle à une économie principalement basée sur la technologie de l'information[1] - [2] - [3] - [4]. L'apparition de l'ère de l'information peut être associée au développement de la technologie des transistors, en particulier du MOSFET (transistor à effet de champ métal-oxyde-semi-conducteur )[5] - [6] qui est devenu la pierre angulaire de l'électronique numérique et a révolutionné la technologie moderne[7].

.jpg.webp)

Selon le Département des affaires économiques et sociales des Nations Unies, l'ère de l'information est formée en capitalisant sur les progrès de la microminiaturisation informatique[8] - [2].

Aperçu des premiers développements

Expansion des bibliothèques et loi de Moore

L'expansion de la taille des bibliothèques est calculée en 1945 par Fremont Rider (en) pour doubler sa capacité tous les 16 ans si l'espace disponible est suffisant[9]. Il préconise de remplacer les œuvres imprimées volumineuses et en décomposition par des photographies analogiques microformes miniaturisées, qui pourraient être dupliquées à la demande pour les usagers des bibliothèques et d'autres institutions.

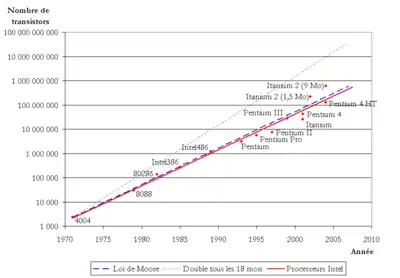

Cependant, Rider ne prévoit alors pas l'arrivée de l'électronique numérique dans les décennies suivantes, grâce à laquelle de vastes augmentations de la rapidité de la croissance de l'information sont rendues possibles avec des technologies numériques automatisées et potentiellement sans perte. En conséquence, la loi de Moore, formulée vers 1965, postule que le nombre de transistors dans un circuit intégré dense double environ tous les deux ans[10] - [11].

Au début des années 80, parallèlement à l'amélioration de la puissance de calcul, la prolifération des ordinateurs personnels plus petits et moins chers permet un accès immédiat à l'information et la capacité de partager et de stocker ces informations pour un nombre croissant de personnes. La connectivité entre les ordinateurs au sein des organisations permet aux employés à différents niveaux d'accéder à de plus grandes quantités d'informations.

Stockage d'informations et loi de Kryder

La capacité technologique mondiale de stockage de données est passée de 2,6 exaoctets (EB) (compressés de manière optimale) en 1986 à 15,8 EB en 1993 puis plus de 54,5 EB en 2000 et enfin 295 EB en 2007[12] - [13]. C'est l'équivalent informationnel de moins d'un CD-ROM de 730 mégaoctets (Mo) par personne en 1986 (539 Mo par personne), environ quatre CD-ROM par personne en 1993, douze CD-ROM par personne en 2000 et près de soixante et un CD-ROM par personne en 2007[14]. On estime que la capacité mondiale de stockage d'informations atteint 5 zettaoctets en 2014, l'équivalent de 4 500 piles de livres imprimés sur la distance Terre-Soleil [15].

La quantité de données numériques stockées semble augmenter exponentiellement, rappelant la loi de Moore. En tant que tel, la loi de Kryder prescrit que la quantité d'espace de stockage disponible semble croître de manière approximativement exponentielle [16] - [17] - [11].

Transmission d'informations

La capacité technologique mondiale de reception d'informations via des réseaux de diffusion unidirectionnels est de 432 exaoctets d'informations en 1986, 715 exaoctets en 1993, 1,2 zettaoctets en 2000 puis 1,9 zettaoctets en 2007, soit l'équivalent informationnel de 174 journaux par personne et par jour[14].

Dans les années 90, la propagation de l'utilisation d'Internet provoque un bond soudain de l'accès et de la capacité de partager des informations dans les entreprises et les foyers du monde entier. La technologie évolue si rapidement qu'un ordinateur coûtant 3 000 dollars en 1997 coûtait 2 000 dollars deux ans plus tard et 1 000 dollars l'année suivante.

Calcul

La capacité technologique mondiale de calculer des informations avec des ordinateurs polyvalents est passée de 3,0×108 MIPS en 1986 à 4,4×109 MIPS en 1993, à 2,9×1011 MIPS en 2000 puis à 6,4×1012 MIPS en 2007[14] Un article publié dans la revue Trends in Ecology and Evolution rapporte que, désormais[15]:

[La technologie numérique] a largement dépassé la capacité cognitive de tout être humain et l'a fait une décennie plus tôt que prévu. En termes de capacité, il existe deux mesures d'importance : le nombre d'opérations qu'un système peut effectuer et la quantité d'informations pouvant être stockées. Le nombre d'opérations synaptiques par seconde dans un cerveau humain est estimé entre 10^15 et 10^17. Bien que ce nombre soit impressionnant, même en 2007, les ordinateurs à usage général de l'humanité étaient capables d'exécuter bien plus de 10^18 instructions par seconde. Les estimations suggèrent que la capacité de stockage d'un cerveau humain individuel est d'environ 10^12 octets. Par habitant, cela correspond au stockage numérique actuel [en 2016] (5x10^21 octets pour 7,2x10^9 personnes).

Concept en trois étapes

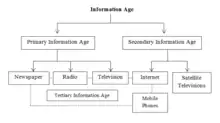

L'ère de l'information peut être définie comme l'ère de l'information primaire et l'ère de l'information secondaire. L'information à l'ère de l'information primaire est gérée par les journaux, la radio et la télévision. L'ère de l'information secondaire s'est développée par Internet, les télévisions par satellite et les téléphones portables. L'ère de l'information tertiaire est apparue lorsque les médias de l'ère de l'information primaire se sont interconnectés avec les médias de l'ère de l'information secondaire[18].

Économie

Finalement, les technologies de l'information et de la communication (TIC) - c'est-à-dire les ordinateurs, les machines informatisées, la fibre optique, les satellites de communication, Internet, etc. - sont devenues une partie importante de l'économie mondiale, car le développement des micro-ordinateurs a considérablement changé de nombreuses entreprises et industries[19] - [20].

Nicholas Negroponte discute par exemple en 1995 dans son livre Being Digital des similitudes et des différences entre les produits faits d'atomes et les produits faits de bits[21]. Essentiellement, une copie d'un produit fait de bits peut être fabriquée à bas prix et rapidement, puis expédiée rapidement à travers le monde à un coût très bas.

Emplois et répartition des revenus

L'ère de l'information affecte la main-d'œuvre de plusieurs manières, par exemple en obligeant les travailleurs à être compétitifs sur un marché du travail mondial. L'une des préoccupations les plus évidentes est le remplacement du travail humain par des ordinateurs capables de faire leur travail plus rapidement et plus efficacement, créant ainsi une situation dans laquelle les personnes qui exécutent des tâches facilement automatisables sont forcées de trouver un emploi là où leur travail n'est pas dispensable. Cela crée particulièrement des problèmes pour les habitants des villes industrielles, où les solutions impliquent généralement de réduire le temps de travail. Ainsi, les personnes qui perdent leur emploi peuvent être poussées à rejoindre les «travailleurs de l'esprit» (par exemple les ingénieurs, médecins, avocats, enseignants, professeurs, scientifiques, cadres, journalistes, consultants, etc.), qui reçoivent des salaires relativement élevés en comparaison.

Parallèlement à l'automatisation, les emplois traditionnellement associés à la classe moyenne (par exemple, sur chaîne de montage, de traitement des données ou de gestion) commencent également à disparaître du fait de l'externalisation[22]. Incapables de concurrencer avec les pays en développement, les travailleurs de la production et des services dans les sociétés post-industrielles perdent leur emploi à cause de la sous-traitance, acceptent des réductions de salaire ou se contentent d'emplois de services peu qualifiés et à bas salaires.

Dans le passé, le sort économique des individus était lié à celui de leur nation. Par exemple, les travailleurs aux États-Unis étaient autrefois bien payés par rapport à ceux d'autres pays. Avec l'avènement de l'ère de l'information et l'amélioration de la communication, ce n'est plus le cas, car les travailleurs doivent désormais être compétitifs sur un marché du travail mondial, où les salaires sont moins dépendants du succès ou de l'échec des économies individuelles.

En créant une main d'œuvre mondialisée, Internet accroît aussi les opportunités dans les pays en développement, permettant aux travailleurs de ces endroits de fournir des services en personne, donc en concurrence directe avec leurs homologues d'autres pays. Cet avantage compétitif se traduit par des opportunités accrues et des salaires plus élevés pour eux[23].

Automatisation, productivité et gain de travail

L'ère de l'information affecte aussi la main-d'œuvre dans la mesure où l'automatisation et l'informatisation aboutissent à une productivité plus élevée associée à une perte nette d'emplois dans le secteur manufacturier. Aux États-Unis, par exemple, de à , le nombre de personnes employées dans les emplois manufacturiers est passé de 17,5 millions à 11,5 tandis que la valeur manufacturière augmentait de 270 %[24].

S'il est apparu au départ que la perte d'emplois dans le secteur industriel pouvait être partiellement compensée par la croissance rapide des emplois dans les technologies de l'information, la récession du début des années 2000 amorce le début d'une forte baisse du nombre d'emplois dans le secteur. Cette tendance se poursuit jusqu'en 2003[25] mais les données ultérieures montrent que, dans l'ensemble, la technologie crée plus d'emplois qu'elle n'en détruit, même à court terme[26].

Industrie à forte intensité d'information

L'industrie devient plus gourmande en informations, mais moins en main-d'œuvre et en capital. Cela laisse des implications importantes pour la main-d'œuvre car les travailleurs deviennent de plus en plus productifs à mesure que la valeur de leur travail diminue. Pour le système du capitalisme lui-même, non seulement la valeur du travail diminue, mais la valeur du capital est également diminuée.

Dans le modèle classique, les investissements en capitale humain et financier sont des prédicteurs importants de la performance d'une nouvelle entreprise[27]. Cependant, comme l'ont par exemple démontré Mark Zuckerberg et Facebook, il est désormais possible pour un groupe de personnes relativement inexpérimentées avec un capital limité de réussir à grande échelle[28].

Innovations

L'ère de l'information est rendue possible par la technologie développée lors de la révolution numérique, qui a elle-même été rendue possible en s'appuyant sur les développements de la révolution technologique à la Belle Epoque.

Transistors

L'apparition de l'ère de l'information peut être associée au développement de la technologie des transistors. Le concept d'un transistor à effet de champ est théorisé pour la première fois par Julius Edgar Lilienfeld en 1925. Le premier transistor pratique est le transistor à point de contact, inventé par les ingénieurs Walter Houser Brattain et John Bardeen aux Laboratoires Bells en 1947, jetant les bases de la technologie moderne[4]. L'équipe de recherche de Shockley invente également le transistor bipolaire en 1952[29] - [30]. Cependant, les premiers sont des dispositifs relativement volumineux qui sont difficiles à fabriquer en série, les limitant à un nombre restreint d'applications spécialisées[31].

Le début de l'ère de l'information, avec l'ère du silicium, remonte à l'invention du transistor à effet de champ à grille métal-oxyde (MOSFET, ou transistor MOS)[32], inventé par Mohamed M. Atalla et Dawon Kahng aux Laboratoires Bells en 1959[6] - [29] - [33]. Le MOSFET est le premier transistor vraiment compact qui peut être miniaturisé et produit en série pour une large gamme d'utilisations[31]. Avec sa grande évolutivité[34], sa consommation d'énergie beaucoup plus faible et sa densité plus élevée que les transistors bipolaires, le MOSFET permet de construire circuits intégres (IC) à très grande échelle[35]. Plus de 10 000 transistors peuvent être placés dans un petit circuit intégré[36] et plus tard des milliards de transistors dans un seul appareil[37].

L'adoption généralisée des MOSFET révolutionne l' industrie électronique[38], comme systèmes de régulation et les ordinateurs depuis les années 1970[39]. Le MOSFET permet notamment à un ordinateur d'exister sur quelques petites puces de circuits intégrés plutôt que de remplir une pièce[7] et rendant ensuite possible les smartphones. Dans les années 2010, des milliards de transistors MOS sont fabriqués chaque jour[29]. Il s'agit de la pierre angulaire de l'électronique numérique depuis la fin du XXe siècle, ouvrant la voie à l'ère numérique[6]. Le transistor MOS est ainsi crédité de la transformation de la société à travers le monde[37] et décrit comme le "cheval de trait" de l'ère de l'information[5] - [40].

Calculateurs

Avant l'avènement de l'électronique, les calculateurs mécaniques, comme la machine analytique en 1837, sont conçus pour fournir des calculs mathématiques de routine et ont des capacités de prise de décision simples. Les besoins militaires pendant la Seconde Guerre mondiale conduisent au développement des premiers ordinateurs électroniques, basés sur des tubes électroniques, notamment le Zuse 3, l'ordinateur Atanasoff–Berry, l'ordinateur Colossus et l' ENIAC.

L'invention du transistor permet l'ère des ordinateurs centraux (années 1950-1970), caractérisée par les IBM 360 et 370. Ces grands ordinateurs de la taille d'une pièce permettent de calculer et de manipuler les données beaucoup plus rapidement qu'humainement, mais coûtent cher à acheter et à entretenir. Ils sont donc initialement limités à quelques institutions scientifiques, grandes entreprises et agences gouvernementales.

Le circuit intégré au germanium est inventé par Jack Kilby chez Texas Instruments en 1958. Le circuit intégré en silicium est ensuite conçu en 1959 par Robert Noyce chez Fairchild Semiconductor, en utilisant le processus planaire développé par Jean Hoerni, qui s'appuyait à son tour sur une méthode de passivation de Mohamed Atalla développée aux Laboratoires Bells en 1957[41] - [42]. À la suite de l'invention du transistor MOS par Mohamed Atalla et Dawon Kahng en 1959[33] le circuit intégré MOS est développé par Fred Heiman et Steven Hofstein au RCA en 1962[43]. Le MOS IC à grille de silicium est conçu par Federico Faggin chez Fairchild Semiconductor en 1968[44].

Avec l'avènement du transistor MOS et du MOS IC, la technologie des transistors s'améliore rapidement suet le rapport puissance de calcul / taille augmente considérablement suivant la loi de Moore, donnant un accès direct aux ordinateurs à des groupes de personnes de plus en plus divers.

Le circuit intégré MOS conduit à l'invention du microprocesseur. Le premier microprocesseur commercial à puce unique lancé en 1971, l'Intel 4004, est développé par Federico Faggin à l'aide de sa technologie MOS IC à grille silicium, avec Marcian Hoff, Masatoshi Shima et Stanley Mazor[45] - [46].

Parallèlement aux bornes d'arcade électroniques et aux consoles de jeux vidéo dans les années 1970, le développement d'ordinateurs personnels comme le Commodore PET et Apple II (tous deux en 1977) permet au plus grand nombre d'accéder à l'ordinateur. Mais le partage de données entre ordinateurs individuels est soit inexistant, soit largement manuel, utilisant d'abord des cartes perforées et des bandes magnétiques, puis des disquettes.

Données

Les premiers développements en matière de stockage de données sont initialement basés sur des photographies, à commencer par la microphotographie en 1851 puis la microforme dans les années 1920, avec la possibilité de stocker des documents sur pellicule, ce qui les rend beaucoup plus compacts. Les premières théories de l'information et les codes de Hamming sont développés vers 1950, mais attendaient que les innovations techniques en matière de transmission et de stockage des données pour être pleinement utilisés.

La mémoire à tores magnétiques est développée à partir des recherches de Frederick W. Viehe en 1947 et d'An Wang à l'Université de Harvard en 1949[47] - [48]. Avec l'avènement du transistor MOS, la mémoire à semi-conducteur MOS est développée par John Schmidt à Fairchild Semiconductor en 1964[49] - [50]. En 1967, Dawon Kahng et Simon Sze conçoivent le MOSFET à grille flottante (FGMOS), qui, selon eux, pourrait être utilisé pour la mémoire morte reprogrammable (EPROM)[51], fournissant la base de la mémoire non volatile (NVM) comme la mémoire flash[52]. À la suite de l'invention de la mémoire flash par Fujio Masuoka chez Toshiba en 1980[53] - [54], la firme commercialise la mémoire flash NAND en 1987[55] - [51].

Alors que les câbles transmettant des données numériques connectés aux terminaux et périphériques d'ordinateurs aux ordinateurs centraux sont courants et que des systèmes spéciaux de partage de messages menant au courrier électronique sont développés pour la première fois dans les années 1960, la mise en réseau indépendante entre ordinateurs commence avec ARPANET en 1969. Cela se développé pour devenir Internet (inventé en 1974), puis le World Wide Web en 1989.

La transmission publique de données numériques utilise d'abord les lignes téléphoniques existantes par accès commuté, à partir des années 1950, et reste le pilier d'Internet jusqu'au haut débit dans les années 2000. La transmission sans fil, l'introduction et la prolifération des réseaux sans fil, commence dans les années 1990 et est rendue possible par l'adoption généralisée des amplificateurs de puissance RF basés sur MOSFET (Power MOSFET et LDMOS) et des circuits RF CMOS[56] - [57] - [58]. Les réseaux sans fil, combinés à la prolifération des satellites de télécommunications dans les années 2000, permettent la transmission numérique publique sans avoir besoin de câbles. Cette technologie conduit à la télévision numérique, au GPS, à la radio par satellite et aux téléphones mobiles dans les années 1990 à 2000.

La mise à l'échelle MOSFET et leur miniaturisation rapide des MOSFET à un taux prédit par la loi de Moore[59] conduit les ordinateurs à devenir plus petits et plus puissants, au point où ils peuvent être transportés. Au cours des années 1980 – 1990, les ordinateurs portables sont développés et les assistants numériques personnels (PDA) peuvent être utilisé debout ou en marchant. Les pagers, largement utilisés dans les années 80, sont remplacés par les téléphones mobiles à partir de la fin des années 90, fournissant des fonctionnalités de réseautage mobile à certains ordinateurs. Désormais courante, cette technologie est étendue aux appareils photo numériques et autres appareils portables. À partir de la fin des années 1990, les tablettes puis les smartphones combinent et étendent ces capacités de calcul, de mobilité et de partage d'informations.

Le codage par transformée en cosinus discrète (DCT), une technique de compression de données proposée pour la première fois par Nasir Ahmed en 1972[60] permet la transmission pratique de médias numériques[61] - [62] - [63] avec des formats de compression d'image tels que JPEG (1992), des formats de codage vidéo tels que MPEG (à partir de 1993)[64], des normes de codage audio telles que Dolby Digital (1991)[65] - [66] et MP3 (1994), et normes de télévision numérique comme la vidéo à la demande (VOD) et la télévision haute définition (HDTV)[67]. La vidéo sur Internet est popularisée par YouTube, une plate-forme de vidéo en ligne fondée par Chad Hurley, Jawed Karim et Steve Chen en 2005, qui permet la diffusion vidéo en continu de contenu généré par les utilisateurs de n'importe où sur le World Wide Web[68].

Le papier électronique, qui remonte aux années 1970, permet aux informations numériques d'apparaître sous forme de documents papier.

Optique

La communication optique joue un rôle important dans les réseaux de télécommunication. La communication optique fournit en effet la base matérielle de la technologie derrière Internet[69].

En 1953, Bram van Heel démontre la possibilité de transmission d'images à travers des faisceaux de fibres optiques avec un revêtement transparent. La même année, Harold Hopkins et Narinder Singh Kapany de l' Imperial College réussissent à créer des faisceaux de transmission d'images avec plus de 10000 fibres optiques, et réalisent par la suite réalisé une transmission d'image via un 75 de cm de long combinant plusieurs milliers de fibres[70].

Tout en travaillant à l'Université de Tohoku, l'ingénieur japonais Jun'ichi Nishizawa propose la communication par fibre optique, l'utilisation de fibres optiques pour la communication, en 1963[71]. Il invente par ailleurs d'autres technologies qui contribuent au développement des communications par fibre optique, telles que la fibre optique à gradient d'indice comme canal pour transmettre la lumière des lasers à semi-conducteurs[72] - [73]. Il dépose un brevet pour cette invention en 1964[69] et crée La fibre optique à l'état solide en 1964[74].

Les trois éléments essentiels de la communication optique sont inventés par Jun-ichi Nishizawa : la diode laser (1957) étant la source lumineuse, la fibre optique à gradient d'indice (1964) comme ligne de transmission et la photodiode PIN (1950) comme optique destinataire[69]. Le développement du laser à semi-conducteur à onde continue par Izuo Hayashi en 1970 conduit directement à l'utilisation de sources lumineuses dans la communication par fibre optique, se trouvant ensuite dans les imprimantes laser, les lecteurs de code-barres et les lecteurs de disques optiques[75].

Les MOSFET permettant la capture photographique commençant à apparaître dans les années 1960, ils conduisent conduit à la transition de l'analogique vers l'imagerie numérique au cours des années 1980 – 1990. Les capteurs d'image les plus courants sont le capteur photographique CCD (CCD) et le Complementary Metal Oxide Semiconductor (capteur CMOS)[76] - [77].

Références

- (en) Cet article est partiellement ou en totalité issu de l’article de Wikipédia en anglais intitulé « Information Age » (voir la liste des auteurs).

- Zimmerman, Kathy Ann, « History of Computers: A Brief Timeline », livescience.com, .

- « The History of Computers », thought.co

- « The 4 industrial revolutions », sentryo.net, .

- Castells Manuel, The information age : economy, society and culture, Oxford, Blackwell, , 1488 p. (ISBN 978-0-631-21594-3, OCLC 43092627)

- Michael G. Raymer, The Silicon Web : Physics for the Internet Age, CRC Press, , 600 p. (ISBN 978-1-4398-0312-7, lire en ligne), p. 365

- « Triumph of the MOS Transistor », YouTube, Computer History Museum, (consulté le ).

- John D. Cressler et H. Alan Mantooth, Extreme Environment Electronics, CRC Press, (ISBN 978-1-351-83280-9, lire en ligne), p. 959

« While the bipolar junction transistor was the first transistor device to take hold in the integrated circuit world, there is no question that the advent of MOSFETs, an acronym for metal-oxide-semiconductor field-effect transistor, is what truly revolutionized the world in the so-called information age. The density with which these devices can be made has allowed entire computers to exist on a few small chips rather than filling a room. »

. - Kluver, « Globalization, Informatization, and Intercultural Communication », un.org (consulté le ).

- Fredmont Rider, The Scholar and the Future of the Research Library, New York City, Hadham Press,

- (en) « Moore's Law to roll on for another decade » (consulté le ) : « Moore also affirmed he never said transistor count would double every 18 months, as is commonly said. Initially, he said transistors on a chip would double every year. He then recalibrated it to every two years in 1975. David House, an Intel executive at the time, noted that the changes would cause computer performance to double every 18 months. »

- (en) Max Roser and Hannah Ritchie. 2013. "Technological Progress." Our World in Data., consulté le 9 juin 2020.

- Hilbert et Lopez, « The World's Technological Capacity to Store, Communicate, and Compute Information », Science, vol. 332, no 6025, , p. 60–65 (ISSN 0036-8075, PMID 21310967, DOI 10.1126/science.1200970)

- Hilbert, Martin R., Supporting online material for the world's technological capacity to store, communicate, and compute infrormation, Science/AAAS, (OCLC 755633889)

- Hilbert et López, « The World's Technological Capacity to Store, Communicate, and Compute Information », Science, vol. 332, no 6025, , p. 60–65 (ISSN 0036-8075, PMID 21310967, DOI 10.1126/science.1200970, Bibcode 2011Sci...332...60H, lire en ligne)

- Gillings, Hilbert et Kemp, « Information in the Biosphere: Biological and Digital Worlds », Trends in Ecology & Evolution, vol. 31, no 3, , p. 180–189 (PMID 26777788, DOI 10.1016/j.tree.2015.12.013, lire en ligne)

- Rizzatti, Lauro. 14 September 2016. "Digital Data Storage is Undergoing Mind-Boggling Growth." EE Times. Archived from the original on 16 September 2016.

- "The historical growth of data: Why we need a faster transfer solution for large data sets." Signiant. 2020. Retrieved 9 June 2020.

- Suroshana Iranga, Social Media Culture, Colombo, S. Godage and Brothers, (ISBN 978-955-30-6743-2)

- « Information Age Education Newsletter », Information Age Education, (consulté le )

- Moursund, « Information Age », IAE-Pedia (consulté le )

- « Negroponte's articles », Archives.obs-us.com, (consulté le )

- McGowan, Robert. 1991. "The Work of Nations by Robert Reich" (book review). Human Resource Management 30(4):535–38. DOI 10.1002/hrm.3930300407. (ISSN 1099-050X).

- Jagdish N. Bhagwati, In defense of Globalization, New York, Oxford University Press,

- Smith, Fran. 5 Oct 2010. "Job Losses and Productivity Gains." Competitive Enterprise Institute.

- Cooke, Sandra D. 2003. "Information Technology Workers in the Digital Economy." In Digital Economy. Economics and Statistics Administration, Department of Commerce.

- Yongsung, Chang, and Jay H. Hong, « Does Technology Create Jobs? », SERI Quarterly, vol. 6, no 3, , p. 44–53 (lire en ligne [archive du ], consulté le )

- Cooper, Gimeno-Gascon et Woo, « Initial human and financial capital as predictors of new venture performance », Journal of Business Venturing, vol. 9, no 5, , p. 371–395 (DOI 10.1016/0883-9026(94)90013-2)

- (en-US) David Carr, « Film Version of Zuckerberg Divides Generations (Published 2010) », The New York Times, (ISSN 0362-4331, lire en ligne, consulté le )

- « Who Invented the Transistor? », Computer History Museum, (consulté le )

- Thomas H. Lee, The Design of CMOS Radio-Frequency Integrated Circuits, Cambridge University Press, (ISBN 978-1-139-64377-1, lire en ligne), « A Review of MOS Device Physics »

- Sanford L. Moskowitz, Advanced Materials Innovation : Managing Global Technology in the 21st century, John Wiley & Sons, , 496 p. (ISBN 978-0-470-50892-3, lire en ligne), p. 168

- « 100 incredible years of physics – materials science », Institute of Physics, (consulté le )

- (en) « 1960 - Metal Oxide Semiconductor (MOS) Transistor Demonstrated », The Silicon Engine, Computer History Museum, (lire en ligne)

- Motoyoshi, « Through-Silicon Via (TSV) », Proceedings of the IEEE, vol. 97, no 1, , p. 43–48 (ISSN 0018-9219, DOI 10.1109/JPROC.2008.2007462, lire en ligne)

- (en) Ian Young, « Transistors Keep Moore’s Law Alive », sur www.eetimes.com,

- Hittinger, « Metal-Oxide-Semiconductor Technology », Scientific American, vol. 229, no 2, , p. 48–59 (ISSN 0036-8733, DOI 10.1038/scientificamerican0873-48, JSTOR 24923169, Bibcode 1973SciAm.229b..48H)

- « Remarks by Director Iancu at the 2019 International Intellectual Property Conference » [archive du ], United States Patent and Trademark Office, (consulté le )

- Yi-Jen Chan, Studies of InAIAs/InGaAs and GaInP/GaAs heterostructure FET's for high speed applications, University of Michigan, (lire en ligne), p. 1

« The Si MOSFET has revolutionized the electronics industry and as a result impacts our daily lives in almost every conceivable way. »

- Duncan Andrew Grant et John Gowar, Power MOSFETS : theory and applications, Wiley, (ISBN 978-0-471-82867-9, lire en ligne), p. 1

« The metal-oxide-semiconductor field-effect transistor (MOSFET) is the most commonly used active device in the very large-scale integration of digital integrated circuits (VLSI). During the 1970s these components revolutionized electronic signal processing, control systems and computers. »

- (en) Jean-Pierre Colinge et James C. Greer, Nanowire transistors : physics of devices and materials in one dimension, New York, Cambridge University Press, , 254 p. (ISBN 978-1-107-05240-6, lire en ligne), p. 2

- (en) Bo Lojek, History of Semiconductor Engineering, Berlin, Heidelberg, Springer Science & Business Media, , 387 p. (ISBN 978-3-540-34258-8, lire en ligne), p. 120

- Ross Knox Bassett, To the Digital Age : Research Labs, Start-up Companies, and the Rise of MOS Technology, Johns Hopkins University Press, , 440 p. (ISBN 978-0-8018-8639-3, lire en ligne), p. 46

- « Tortoise of Transistors Wins the Race - CHM Revolution », Computer History Museum (consulté le )

- « 1968: Silicon Gate Technology Developed for ICs », Computer History Museum (consulté le )

- « 1971: Microprocessor Integrates CPU Function onto a Single Chip », Computer History Museum (consulté le )

- (en) Jean-Pierre Colinge, James C. Greer et Jim Greer, Nanowire transistors : physics of devices and materials in one dimension, New York, Cambridge University Press, , 254 p. (ISBN 978-1-107-05240-6, lire en ligne), p. 2

- « 1953: Whirlwind computer debuts core memory », Computer History Museum (consulté le )

- « 1956: First commercial hard disk drive shipped », Computer History Museum (consulté le )

- « 1970: MOS Dynamic RAM Competes with Magnetic Core Memory on Price », Computer History Museum (consulté le )

- Solid State Design - Vol. 6, Horizon House, (lire en ligne)

- « 1971: Reusable semiconductor ROM introduced », Computer History Museum (consulté le )

- R. Bez et A. Pirovano, Advances in Non-Volatile Memory and Storage Technology, Woodhead Publishing, , 662 p. (ISBN 978-0-08-102585-7, lire en ligne)

- Fulford, « Unsung hero » [archive du ], Forbes, (consulté le )

- Brevet US 4531203 Fujio Masuoka

- « 1987: Toshiba Launches NAND Flash », eWeek, (consulté le )

- Mike Golio et Janet Golio, RF and Microwave Passive and Active Technologies, CRC Press, , ix, I-1, 18-2 (ISBN 978-1-4200-0672-8, lire en ligne)

- Rappaport, « The wireless revolution », IEEE Communications Magazine, vol. 29, no 11, , p. 52–71 (DOI 10.1109/35.109666)

- (en) « The wireless revolution », The Economist, (lire en ligne, consulté le )

- Shubham Sahay et Mamidala Jagadesh Kumar, Junctionless Field-Effect Transistors : Design, Modeling, and Simulation, John Wiley & Sons, , 496 p. (ISBN 978-1-119-52353-6, lire en ligne)

- Ahmed, « How I Came Up With the Discrete Cosine Transform », Digital Signal Processing, vol. 1, no 1, , p. 4–5 (DOI 10.1016/1051-2004(91)90086-Z, lire en ligne)

- William Lea, Video on demand : Research Paper 94/68, 9 May 1994, House of Commons Library, (lire en ligne)

- Frolov et Primechaev, « Compressed Domain Image Retrievals Based On DCT-Processing », Semantic Scholar, (lire en ligne, consulté le )

- Lee, Beck, Lamb et Severson, « Real-time software MPEG video decoder on multimedia-enhanced PA 7100LC processors », Hewlett-Packard Journal, vol. 46, no 2, (ISSN 0018-1153, lire en ligne)

- Stanković et Astola, « Reminiscences of the Early Work in DCT: Interview with K.R. Rao », Reprints from the Early Days of Information Sciences, vol. 60, (lire en ligne, consulté le )

- (en) Fa-Long Luo, Mobile Multimedia Broadcasting Standards : Technology and Practice, New York/London, Springer Science & Business Media, , 674 p. (ISBN 978-0-387-78263-8, lire en ligne), p. 590

- Britanak, « On Properties, Relations, and Simplified Implementation of Filter Banks in the Dolby Digital (Plus) AC-3 Audio Coding Standards », IEEE Transactions on Audio, Speech, and Language Processing, vol. 19, no 5, , p. 1231–1241 (DOI 10.1109/TASL.2010.2087755)

- Shishikui, Nakanishi et Imaizumi, « An HDTV Coding Scheme using Adaptive-Dimension DCT », Signal Processing of HDTV: Proceedings of the International Workshop on HDTV '93, Ottawa, Canada, Elsevier, october 26–28, 1993, p. 611–618 (ISBN 9781483298511, DOI 10.1016/B978-0-444-81844-7.50072-3, lire en ligne)

- Crick Matthew, Power, Surveillance, and Culture in YouTube™'s Digital Sphere, IGI Global, , 36–7 p. (ISBN 978-1-4666-9856-7, lire en ligne)

- The Third Industrial Revolution Occurred in Sendai, Soh-VEHE International Patent Office, Japan Patent Attorneys Association

- Jeff Hecht, City of Light : The Story of Fiber Optics, revised, , 55–70 p. (ISBN 978-0-19-516255-4, lire en ligne)

- Nishizawa, Jun-ichi et Suto, Ken, Physics of semiconductor devices, New Delhi, India, Narosa Publishing House, , 623 p. (ISBN 978-81-7319-567-9), « Terahertz wave generation and light amplification using Raman effect », p. 27

- « Optical Fiber » [archive du ], Sendai New (consulté le )

- « New Medal Honors Japanese Microelectrics Industry Leader », Institute of Electrical and Electronics Engineers

- Semiconductor Technologies, page 338, Ohmsha, 1982

- Bob Johnstone, We were burning : Japanese entrepreneurs and the forging of the electronic age., New York, BasicBooks, , 448 p. (ISBN 978-0-465-09118-8), p. 252

- (en) J. B. Williams, The Electronics Revolution : Inventing the Future, Cham, Springer, , 245–8 p. (ISBN 978-3-319-49088-5, lire en ligne)

- Fossum, « Active pixel sensors: are CCDs dinosaurs? », SPIE Proceedings Vol. 1900: Charge-Coupled Devices and Solid State Optical Sensors III, International Society for Optics and Photonics, vol. 1900, , p. 2–14 (DOI 10.1117/12.148585, Bibcode 1993SPIE.1900....2F)

Voir aussi

Bibliographie

- Oliver Stengel et al. (2017). Digitalzeitalter - Digitalgesellschaft, Springer, (ISBN 978-3658117580)

- Mendelson, Edward (June 2016). In the Depths of the Digital Age, The New York Review of Books

- Bollacker, Kurt D. (2010) Avoiding a Digital Dark Age, American Scientist, March–April 2010, Volume 98, Number 2, p. 106ff

- Castells, Manuel. (1996–98). The Information Age: Economy, Society and Culture, 3 vols. Oxford: Blackwell.

- Gelbstein, E. (2006) Crossing the Executive Digital Divide. (ISBN 99932-53-17-0)

Articles connexes

- Ère de l'imagination (en)

- Société de l'information

Liens externes

- Impact de l'ère de l'information sur les entreprises – Information Age magazine

- Beyond the Information Age de Dave Ulmer

- Information Age Anthology Vol I de Alberts et Papp (CCRP, 1997) (PDF)

- Information Age Anthology Vol II de Alberts et Papp (CCRP, 2000) (PDF)

- Information Age Anthology Vol III de Alberts et Papp (CCRP, 2001) (PDF)

- Understanding Information Age Warfare de Alberts et al. (CCRP, 2001) (PDF)

- Information Age Transformation de Alberts (CCRP, 2002) (PDF)

- The Unintended Consequences of Information Age Technologies de Alberts (CCRP, 1996) (PDF)