Loi de Moore

Les lois de Moore sont des lois empiriques qui ont trait à l'évolution de la puissance de calcul des ordinateurs et de la complexité du matériel informatique.

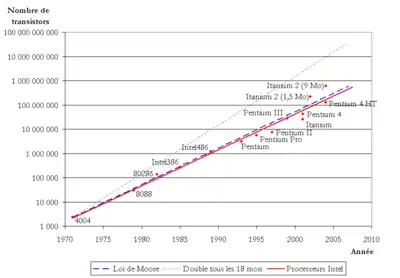

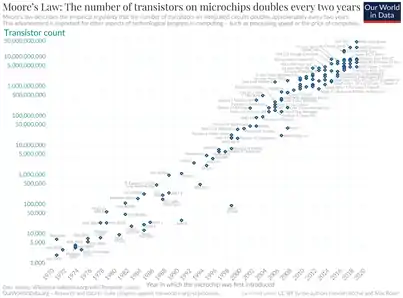

La première de ces lois est émise par le docteur Gordon E. Moore en 1965, lorsque celui-ci postule sur une poursuite du doublement de la complexité des semi-conducteurs tous les ans à coût constant. Dix ans plus tard Moore ajusta sa prédiction à un doublement du nombre de transistors présents sur une puce de microprocesseur tous les deux ans. Ce second postulat se révéla particulièrement exact, et popularisa le terme de « loi de Moore », si bien que ce dernier a fini par s'étendre au doublement d'une capacité quelconque en un temps donné[1].

Énoncés

Le premier microprocesseur (Intel 4004) a été inventé en 1971. Il s’agissait d’une unité de calcul de 4 bits, cadencée à 740 kHz et intégrant 2 300 transistors. La capacité d’intégration des transistors et l'augmentation de la finesse de gravure ont amélioré les performances des processeurs.

- La loi de Moore a été exprimée en 1965 dans le magazine Electronics (en) par Gordon E. Moore, ingénieur de Fairchild Semiconductor, un des trois fondateurs d'Intel. Constatant que la « complexité des semi-conducteurs proposés en entrée de gamme » doublait tous les ans à coût constant depuis 1959, date de leur invention, il postulait la poursuite de cette croissance (en 1965, le circuit le plus performant comportait 64 transistors). Cette augmentation exponentielle fut rapidement nommée « loi de Moore » ou, compte tenu de l'ajustement ultérieur, « première loi de Moore »[2].

- En 1975, Moore réévalua sa prédiction en posant que le nombre de transistors des microprocesseurs (et non plus de simples circuits intégrés moins complexes ) sur une puce de silicium double tous les deux ans[3]. Bien qu'il ne s'agisse pas d'une loi physique mais seulement d'une extrapolation empirique, cette prédiction s'est révélée étonnamment exacte. Entre 1971 et 2001, la densité des transistors a doublé chaque 1,96 année. En conséquence, les machines électroniques sont devenues de plus en plus petites et de moins en moins coûteuses tout en devenant de plus en plus rapides et puissantes.

- Une version commune, variable et sans lien avec les énoncés réels de Moore est : « quelque chose » double tous les dix-huit mois, cette chose étant « la puissance », « la capacité », « la vitesse », « la fréquence d'horloge » et bien d'autres variantes mais très rarement la densité des transistors sur une puce. Ces pseudo « lois de Moore » sont celles le plus souvent diffusées, car elles fleurissent dans des publications grand public et sur de nombreux sites Internet. Leur seul point commun est donc ce nombre de dix-huit mois, qu'on ne trouve pourtant dans aucun des deux énoncés de Moore. Ce nombre vient d'une prédiction de David House, cadre de Intel, qui a combiné la multiplication des transistors et l'augmentation de leur vitesse[4].

Loi de Moore et fréquence d'horloge

L'interprétation erronée de la loi de Moore sur la fréquence d'horloge est à peu près vérifiée depuis 1973, et aurait dû théoriquement continuer jusqu'en 2015 avant qu'on ne bute sur des effets de bruits parasites (effets quantiques, désintégrations alpha). Depuis 2004, la fréquence des processeurs tend à stagner en raison de difficultés de dissipation thermique, qui empêchent une montée en fréquence en dépit de la taille plus faible des composants. Les fréquences de processeurs s'approchent en 2016 du seuil des 5 GHz[5]. Un record de 500 GHz est battu par IBM (en coopération avec Georgia Tech) avec un transistor équipé d'une puce à base de silicium-germanium qui, pour l'occasion, a été refroidi à −269 °C à l'hélium liquide[6]. Ce transistor fonctionne encore à 350 GHz à température ambiante. En 2018, Intel franchit la barre des 7,5 GHz avec son processeur Core i9-9900K par l'optimisation de l'utilisation de l'azote liquide pour le système de refroidissement[7].

Cependant la seconde loi de Moore est toujours respectée, du fait de la capacité d'intégration des processeurs toujours en progression, qui permet de contourner la stagnation de la fréquence par le doublement sur une puce du nombre de transistors, la fréquence restant pour sa part inchangée (Dual PowerPC en 2002, Dual IA en 2004, Intel Core Duo en 2006).

De plus, on expérimente des puces fonctionnant en mode totalement asynchrone. L'idée de circuits asynchrones n'est pas nouvelle puisqu'elle a été expérimentée en 1951 avec l'IAS et en 1952 avec l'ORDVAC. On s'aperçoit en effet que la simple transmission du signal d'horloge à tous les composants peut consommer la moitié de l’espace et de la puissance électrique[8] des microprocesseurs de l'an 2000.

Parallélisme et loi de Moore

Le recours au traitement parallèle est devenu, pendant les années 2000, nécessaire pour que la loi de Moore reste valide. Pendant des années, les fondeurs de processeurs étaient en mesure de fournir des augmentations de fréquence d'horloge et des améliorations de parallélisme au niveau des jeux d'instructions, de telle manière que les applications mono-thread s'exécutaient beaucoup plus vite sur une nouvelle génération de processeurs sans qu'aucune modification ne soit nécessaire. Désormais, pour gérer au mieux la puissance dissipée (directement liée à la fréquence d'horloge), les fondeurs favorisent les architectures multi-cœurs. Ceci a un impact extrêmement important sur le logiciel qui doit être écrit et spécialement adapté pour tirer avantage du matériel[9].

Autres facteurs

Aspects financiers

Un autre facteur peut freiner la progression des performances des processeurs, et qui n'a cette fois-ci plus rien de physique, mais qui est d'ordre financier. Le coût des chaînes de production augmente lui aussi exponentiellement, à un point tel que même des géants concurrents comme IBM et Siemens ont dû grouper leurs investissements pour arriver à suivre le mouvement.

La rentabilité des nouvelles générations de machines dépend d'un futur pour le moins incertain (beaucoup d'utilisateurs de PC, par exemple, commencent à prendre comme critère de choix prioritaire non plus la vitesse d'un PC, mais son niveau de bruit) et il se pourrait que dans ces conditions ce soit une décision économique, et non un palier physique, qui mette fin à la loi de Moore.

Vitesse réelle et vitesse subjective

Des machines de plus en plus puissantes mises à disposition des développeurs ont des effets pervers. À l'époque des processeurs « lents » des années 1980 et 1990, les développeurs investissaient beaucoup de temps pour optimiser les programmes et chaque ligne de code que l'on pouvait économiser permettait de gagner des cycles d'horloge et donc d'aller plus vite. Les ordinateurs actuels offrent un confort de travail qui a pour effet de diminuer la vigilance des développeurs[10]. En outre, les contraintes économiques obligent à toujours produire dans l'urgence, et le temps passé autrefois à optimiser le code a été sacrifié. Ainsi est-on confronté aujourd'hui à un paradoxe : les ordinateurs sont de plus en plus rapides, mais les logiciels de plus en plus lourds et de plus en plus lents (voir Loi de Wirth).

Finalement, l'utilisateur n'a pas la sensation d'une réelle augmentation de la vitesse, surtout pour des tâches élémentaires comme le traitement de texte. Nombre d'utilisateurs regrettent même les ordinateurs plus « rustiques » qui, privés de tous les gadgets dont les systèmes sont chargés aujourd'hui, pouvaient s'avérer plus performants en matière de productivité.

Un autre facteur sans doute explique mieux l'absence de sensation de progrès : les autres composants des ordinateurs n'ont pas forcément évolué aussi vite. Dans un ordinateur moderne équipé de disques durs mécaniques, ce sont ces derniers qui sont le facteur limitant de l'expérience utilisateur. Un ordinateur est un système comparable à une chaîne : le composant le plus lent décide de la vitesse de l'ensemble. L'ajout de mémoire vive ou l'installation d'un stockage SSD dans un système obsolète ou bas de gamme permet un gain de réactivité (démarrage de la machine, lancement des programmes, arrêt) souvent plus apprécié par l'utilisateur qu'une augmentation de la vitesse du processeur.

Contrainte économique

La loi de Moore pourrait également présenter un intérêt économique de contrôle de la demande par répartition distillée de l'offre. En effet, la miniaturisation progresse en principe grâce à des découvertes et à des optimisations ponctuelles, réalité peu conforme à la régularité de l'évolution exponentielle spécifiée par la loi de Moore. En maîtrisant dans le temps la diffusion des applications technologiques nouvelles, il est possible que les géants des semi-conducteurs définissent eux-mêmes un modèle stable de consommation, et s'assurent ainsi d'une correspondance entre leurs efforts d'innovation et les désirs de renouvellement de leur clientèle. L’auto-limitation de l'offre obligerait ainsi les consommateurs à mettre à jour régulièrement leur matériel. Pour être effective, il faudrait néanmoins qu'une telle auto-limitation de l'offre puisse s'appuyer sur une cartellisation forte du marché.

Dans ce cas, assez courant dans l'histoire du capitalisme, les lois du marché favoriseraient le bridage de l'innovation pour assurer une rente à l'ensemble du secteur concerné[11]

The Wall (en français : Le Mur)

La loi de Moore s'est révélée étonnamment exacte jusqu'au début du XXIe siècle.

En 1999, le transistor CMOS dit « ultime » développé au CEA-Leti à Grenoble a poussé à ses « limites » le principe du transistor MOSFET avec une section de 18 nanomètres (la dimension d’environ 70 atomes mis côte à côte), soit sept fois plus petit que le plus petit transistor industriel de 2002 (123 nm en 2002, 83 nm en 2003, 65 nm en 2005, 45 nm en 2008, 32 nm en 2010, 22 nm en 2012, 14 nm en 2016, 7 nm en 2019). Il permettait un degré d’intégration théorique de sept milliards de jonctions sur une pièce d'un euro. Mais, il ne s’agissait là que d’une simple expérience de recherche pour étudier le fonctionnement des techniques CMOS lorsque l’on s’approche de la taille moléculaire.

Le coût de la technique permettant la réalisation de puces intégrant de plus en plus de transistors augmente dans des proportions vertigineuses. Une autre loi empirique de la Silicon Valley, la loi de Rock, stipule ainsi que le coût de fabrication d’une fonderie de puce double tous les quatre ans car le procédé de fabrication utilisé depuis une quarantaine d’années, la photolithographie, se rapproche toujours plus de ses limites physiques. Ainsi en 2004, Intel a annoncé un investissement de plus de deux milliards de dollars dans son usine Fab12 en Arizona pour la fabrication de puces à partir de wafers de 300 mm de diamètre, qui ont remplacé les wafers de 200 mm vers la fin 2005.

Pour fabriquer des transistors toujours plus minuscules, on utilise des rayonnements de longueur d’onde toujours plus courte et la course à la miniaturisation entraînera la photolithographie dans le spectre des rayons X de plus en plus durs (rayonnement UV puis rayons X…). Mais dans cette gamme de longueurs d’onde il devient difficile, voire impossible, de concentrer efficacement les rayons. Au milieu des années 1990, on estimait ne pas être en mesure de fabriquer industriellement des transistors de moins de 400 atomes (100 nm) de section avec un tel procédé. Dans l’industrie du silicium, cette limite s’appelle « the Wall ».

En 2021 la loi de Moore est jugée comme approchant de sa limite. Jusque-là, le nombre de transistors des microprocesseurs a progressé parce qu’ils sont de plus en plus petits grâce à l’augmentation de la finesse de gravure, mais celle-ci ne pourra pas descendre en dessous d’une certaine valeur. Pour continuer à augmenter le nombre de transistors sur la même surface, il est envisagé la construction à la verticale de puces en 3D. Les transistors ne seront pas plus petits, mais leur nombre augmentera comme si leur taille avait été réduite[12].

Changement progressif des besoins, développement durable

Nouveaux besoins

Certains commentateurs[13] mettent en doute la pertinence de la loi de Moore en matière de développement durable :

- le doublement périodique de la puissance de calcul a pour effet de diminuer la durée d'amortissement des équipements, donc de générer des déchets ;

- l'un des problèmes posés est la consommation électrique, plus que la puissance de calcul.

Les nouveaux besoins (informatique « verte », diminution de la taille des ordinateurs avec les netbooks et tablettes…) s'expriment moins en millions de transistors par mm² qu'en performance par énergie consommée.

Par ailleurs, faire descendre le traitement d'une tâche interactive de 20 secondes à 2 secondes, puis à 200 ms, est intéressant. Le faire tomber ensuite à 20 ms n'apporte pas nécessairement quelque chose, et certainement rien si cette tâche est isolée. Si les besoins industriels réclament de plus en plus de puissance, il n'en va pas indéfiniment de même de ceux du particulier.

On voit émerger les besoins des parties prenantes des entreprises, qui réclament que soient pris en compte les impacts environnementaux et sociaux de leur activité en matière de développement durable.

Un rapport d'information du Sénat français sur les nouvelles techniques de l'information[14] mentionne la loi de Moore comme la principale accélération technique de ces dernières décennies. Ce rapport souligne la nécessité de définir un système de valeurs dans la nouvelle société de l'information, qui évite le scientisme.

Dans ce contexte, on est amené à évaluer la performance par watt.

Initiatives

Le Green500 List classe les superordinateurs de la liste TOP500 en matière d'efficacité énergétique. Celle-ci est mesurée en FLOPS par watt[15].

Le constructeur informatique Bull a abandonné la loi de Moore dans ses objectifs, et retient maintenant le rapport performance / énergie dans ses plans d'informatique verte[16].

Certains constructeurs comme ARM introduisent des processeurs ne cherchant plus à suivre la loi de Moore[17]. Ses processeurs de 2009 possèdent parfois 100 000 transistors, soit moins qu'un processeur Intel 286 à 12 MHz de 1982[18], mais ne consomment qu'un quart de watt, équipant en 2009 une dizaine de modèles de netbooks fonctionnant sous Linux ou d'autres systèmes d’exploitation.

La création en 2007 de la Climate Savers Computing Initiative, qui s'est fixé pour objectif de réduire de moitié la consommation électrique des ordinateurs, a probablement signé l'arrêt de mort de la loi de Moore.

Changement de paradigme

Lorsque la loi de Moore aura atteint ses limites, changer de paradigme consistera en la transition de la microélectronique aux nanotechnologies[19], c’est-à-dire un ensemble de techniques radicalement différentes, complémentaires ou concurrentes, telles que l’utilisation des nanotubes dans les transistors moléculaires, les ordinateurs à ADN, l’informatique quantique… Technologies couramment regroupées sous le vocable « nano-informatique » qui introduisent notamment les systèmes ubiquitaires et l'informatique diffuse.

Lors de l’Intel Developer Forum de , Gordon Moore a prédit que sa loi de doublement du nombre de transistors dans une puce tous les deux ans ne serait plus valide dans dix à quinze ans[20]. En effet, l'industrie approche de plus en plus des limites physiques de la micro-électronique, où les transistors ne seront plus constitués que de quelques atomes et l'isolant entre eux. L'industrie devra alors chercher des méthodes entièrement nouvelles, tel que l'empilement des transistors en trois dimensions[21].

En , la fin de la loi de Moore est annoncée par l'International Technology Roadmap for Semiconductors (ITRS) qui entérine officiellement l'abandon de cette loi, le rythme n'étant tout simplement plus tenable[22] - [23] - [24]. A cette occasion, l'ITRS change de nom et de stratégie, elle s'appelle désormais International Roadmap for Devices and Systems[25]. Sa nouvelle feuille de route s'intitule More than Moore en référence à l'abandon de la stratégie More Moore qui permettait de fixer les investissements de l'industrie à un niveau permettant à la loi de Moore de rester valable[26].

Puces mémoires : quelques repères

(Indiqués par Gordon Bell dans son exposé « Computing laws »)

Selon la loi de Moore :

Progressions comparables dans d'autres domaines

Bien que la loi de Moore soit très spectaculaire, elle ne doit pas faire oublier d'autres progrès qui lui sont parfois supérieurs :

- La société Seagate (ex-Shugart) a signalé qu'elle avait fait descendre en 29 ans le coût du mégaoctet sur disque d'un facteur 1 300 000. De fait, les capacités en milliards d'octets étaient destinées aux seules entreprises en 1980, et courants pour les particuliers en 2009.

- Un Red Book IBM de 1995 précise que le coût de transmission d'un million d'octets diminuera de 95 % par an de 1995 à 2005 grâce à la multiplication des débits permise par le déploiement généralisé de la fibre optique entre les standards téléphoniques. L'apparition vers le milieu des années 2010 de la 4G, puis vers 2020 de la 5G rend routiniers et économiques les transferts rapides d'importants volumes de données[27].

Notes et références

- « Quel est le nom de la loi qui prédit le doublement de la densité des puces électroniques tous les 2 ans ? », sur Pix-Data.Com, (consulté le )

- (en) Gordon E. Moore, « Cramming More Components Onto Integrated Circuits », Electronics, vol. 38, (lire en ligne [PDF])Article dans lequel la loi a été énoncée la première fois.

- (en) Gordon E. Moore, « Progress in Digital Integrated Electronics », IEEE Text Speech, (lire en ligne)

- (en) Michael Kanellos, « Moore's Law to roll on for another decade », sur CNET, (consulté le ) : « Moore also affirmed he never said transistor count would double every 18 months, as is commonly said. Initially, he said transistors on a chip would double every year. He then recalibrated it to every two years in 1975. David House, an Intel executive at the time, noted that the changes would cause computer performance to double every 18 months. »

- Jean-François Soutenain et Nicolas Delzenne, Systèmes d'information de gestion : manuel + applications + corrigés, Paris, Sup'Foucher, coll. « DCG , 8; LMD expertise comptable », , 383 p. (ISBN 978-2-216-14652-9, lire en ligne), « Chapitre 1 - Le micro ordinateur Aspects matériels et logiciels »

- (en) R. Krithivasan, Lu Yuan, J.D. Cressler, Rieh Jae-Sung, M.H. Khater, D. Ahlgren et G. Freeman, « Half-terahertz operation of SiGe HBTs », Electron Device Letters, IEEE, vol. 27, no 7, , p. 567-569 (ISSN 0741-3106, DOI 10.1109/LED.2006.876298, lire en ligne).

- +Jérôme Gianoli, « Le Core i9-9900K encaisse plus de 7,6 GHz, nouveau record », sur GinjFo, (consulté le )

- Pascal Vivet, Une méthodologie de conception de circuits intégrés quasi-insensibles aux délais : Application à l'étude et à la réalisation d'un processeur RISC 16-bit asynchrone, (lire en ligne [PDF]), p. 16Thèse présentée en 2001 en vue de l'obtention d'un doctorat de l'Institut polytechnique de Grenoble.

- (en) See Herb Sutter, The Free Lunch Is Over: A Fundamental Turn Toward Concurrency in Software, Dr. Dobb's Journal, 30(3), mars 2005.

- Romain Fallet, « Le désenchantement du logiciel »

- La guerre des brevets, documentaire Arte.

- FRANCOIS FRANCIS BUS, L'EPOQUE OU LES PUCES FONT LEURS LOIS : histoire des semiconducteurs vecue de chez Texas Instruments., BOOKS ON DEMAND, (ISBN 2-322-25685-4 et 978-2-322-25685-3, OCLC 1225066813, lire en ligne)

- Le Développement Durable en informatique, sur viabloga.com, consulté le 2 décembre 2017.

- Rapport d'information du Sénat sur les nouvelles techniques de l'information.

- (en)TOP Greeen500 List - novembre 2008.

- « L'informatique verte : cap sur l'intelligence énergétique[PDF] », bull.com.

- (en) « ARM: Heretic in the church of Intel, Moore's Law », sur Computerworld (consulté le ).

- (en) « Speech FINAL 6 mars 2006 » [PDF], sur ARM.

- (en) IBM smashes Moore's Law, cuts bit size to 12 atoms, sur le site digg.com du 12 janvier 2012.

- Gordon Moore prévoit l'obsolescence de sa loi dans 10 à 15 ans, sur le site pcinpact.com du 20 septembre 2007, consulté le 18 août 2017.

- « La loi de Moore caduque d'ici 10 à 15 ans ? », sur le site clubic.com du 19 septembre 2007, consulté le 18 août 2017.

- (en) « The chips are down for Moore’s law », Mitchell Waldrop, Nature.com, 9 février 2016.

- « La loi de Moore est officiellement enterrée », Virgile Juhan, Le journal du net.com, 23 mai 2018.

- « Processeurs : la loi de Moore c'est terminé. Quid de la suite ? », ZDNet.fr, 15 février 2016.

- (en-GB) « About - IEEE International Roadmap for Devices and Systems », sur irds.ieee.org (consulté le )

- Blamont, Jacques (1926-....)., Réseaux ! : le pari de l'intelligence collective, Paris, CNRS éditions, 270 p. (ISBN 978-2-271-12235-3 et 227112235X, OCLC 1076859120, lire en ligne)

Bibliographie

Voir aussi

Articles connexes

- Chronologie des microprocesseurs

- Climate Savers Computing Initiative

- Invention (technique)

- Liste des ordinateurs à transistors

- Loi de Wirth

- Loi de Koomey

- Progrès

- Progrès accéléré

- Progrès technique

- Singularité technologique

- Nanotechnologies, biotechnologies, informatique et sciences cognitives

- Sobriété numérique

- Informatique durable