Nano-informatique

La nano-informatique est un néologisme qui propose de nouveaux concepts et architectures des systèmes informatiques et de l'électronique numérique. Fondés sur la technologie du silicium ou sur des alternatives radicales, ils ont pour particularité d'exploiter (pour tout ou partie) les molécules elles-mêmes comme éléments de base des futurs ordinateurs. Pour des raisons autant économiques que techniques, on considère leur développement comme inéluctable.

Fatalité de la loi de Moore

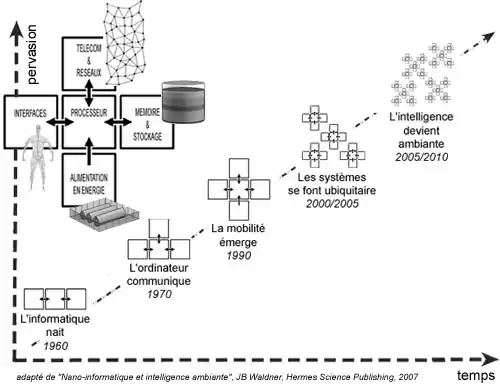

Les semi-conducteurs ont soutenu les progrès des ordinateurs au cours des 50 dernières années. Un demi-siècle durant lequel les circuits intégrés n’ont cessé de voir leur puissance s’accroître. Mais ces performances finiront inéluctablement par atteindre leurs limites physiques. Quelles seront alors les nouvelles voies de développement pour des systèmes toujours plus puissants, toujours plus présents ?

L’essentiel de cette question réside dans la fatalité de la loi de Moore et la transition de la microélectronique aux nanotechnologies.

Les semi-conducteurs ont favorisé les progrès des ordinateurs au cours du demi-siècle passé. Avant 2020, cette technologie matérielle aura évolué jusqu’à ses limites physiques. Alors, soit nos machines auront définitivement atteint leur puissance asymptotique et les seuls progrès futurs seront liés à l’innovation applicative, c'est dire les seuls progrès des logiciels et de la manière d'utiliser une technologie donnée (c’est le scénario pessimiste), soit il existera une technologie de substitution, radicale, qui autorisera à nouveau une progression conjointe des performances du matériel et des applications.

La nano-informatique est un domaine interdisciplinaire très vaste qui regroupe des technologies diverses, complémentaires ou concurrentes telles que l’utilisation des nanotubes dans les transistors moléculaires, l’informatique ADN (Ordinateur à ADN), les systèmes d’information quantiques (cf. calcul quantique),... L'usage industriel du vocable « nano-informatique » à coutume de couvrir également les procédés de fabrication de l’industrie électronique et informatique du XXIe siècle : laser nanoseconde, laser femtoseconde, laser attoseconde.

La nano-informatique introduit une transformation majeure dans le monde de l’entreprise et de la vie quotidienne (comme l'a fait en son temps l'informatique transactionnelle et le PC) : impact sur les activités de codage et de mise en œuvre des systèmes dans l'entreprise, opportunités économiques, mutation des métiers, etc.

Des composants nanométriques à l’auto-organisation de systèmes moléculaires complexes

Les premiers composants nanométriques (c'est-à-dire à l’échelle de la molécule, là où opèrent les phénomènes quantiques) ont déjà vu le jour dans nos laboratoires. Conscients du caractère absolument vital de cette technologie, les grands opérateurs de la filière du silicium (Intel, IBM,...) figurent parmi les grands pionniers du domaine. Ils explorent notamment les filières des nanotubes de carbone.

Mais ce qui est réalisable sur les bancs d’essais des laboratoires à l’échelle unitaire, est encore loin d’être applicable dans le cadre de circuits complexes et encore moins, dans la perspective d’une production industrielle. La principale raison est la difficulté d’intégration de plusieurs centaines de millions de ces dispositifs au sein d’une même puce, à l’instar de nos microprocesseurs actuels (rappelons qu’à l’horizon 2015, ce sont 15 milliards de transistors qu’il conviendra alors d’intégrer sur une même puce).

La nanotechnologie au sens historique du terme, ne consiste pas simplement à réaliser des objets aux dimensions moléculaires. L’idée fondamentale emprunte aux sciences du vivant le principe de l’auto-organisation en systèmes complexes. C'est-à-dire des briques élémentaires qui en fonction de la destination du dispositif, sont capables de s’assembler d’elles-mêmes sous la forme d’un dispositif plus complexe à partir d’une simple consigne macroscopique externe. C’est là le principal défi et la source des débats polémiques qui alimentent la scène scientifique et technique à ce jour.

Puisque la nature peut construire de telles machines et que la biologie moléculaire et le génie génétique ont déjà exploré ces principes, une autre voie s’ouvre également pour les ordinateurs du futur : celle de l’électronique moléculaire organique qui exploite un matériau vivant tel qu’une protéine par exemple, et la réutilise dans un environnement artificiel, pour assurer une fonction de calcul ou une fonction de mémoire par exemple.

Transistor FET à nanotubes de carbone (CNFET)

Le transistor à effet de champ à nanotube (CNFET ou « Carbon Nanotube Field Effect Transistor ») utilise un nanotube de type semi-conducteur en tant que canal, à travers lequel les électrons peuvent circuler d’une manière contrôlée, selon que l’on applique ou non, une différence de potentiel sur une troisième électrode.

Le courant de commande appliquée sur l’électrode gate permet par exemple, de faire varier la conductivité du canal source-drain par un facteur million et même plus, tel que le fait un transistor FET conventionnel issu de la filière silicium.

Circuits électroniques mono-moléculaires hybrides

Ces dispositifs n'utilisent qu'une seule molécule ou un nombre très faible par composant. Il s’agit d'un procédé hybride, car le circuit électronique est réalisé en interconnectant des composants moléculaires élémentaires (c’est-à-dire des « équivalent-transistors », chacun réalisé avec une molécule unique) par de minuscules brins conducteurs métalliques.

Électronique moléculaire organique

Cette approche utilise les propriétés d’un matériau vivant où des molécules biologiques sont extraites de leur contexte naturel et sont ré-utilisées dans un environnement étranger pour en faire une utilisation artificielle différente. On utilise donc un matériau vivant à des fins totalement « non-biologiques ».

L'élaboration de nouveaux dispositifs de stockage capables de stocker plusieurs dizaines de téraoctets dans de minuscules cubes de quelques cm3 (datacubes), sont l'une des applications pionnières de cette filière. Exploitant les propriétés de la bactériorhodopsine, une protéine sensible à la lumière, située dans la membrane des halobactéries. Elle est capable de convertir de l'énergie lumineuse en énergie chimique, plus précisément de transloquer un proton après avoir reçu un photon (pompe à protons). Cette activité repose sur une transition entre l'état d'origine et un état intermédiaire due à l'excitation par un photon. Après l'excitation, la protéine ne se maintient que pendant un certain laps de temps dans l'état intermédiaire, avant de revenir à son état d'origine. Mais, par mutagenèse dirigée, on peut synthétiser une version nouvelle de la bactériorhodopsine conservant l'état intermédiaire, au lieu de revenir spontanément à son état d'origine.

La bactériorhodopsine intéresse ainsi l'industrie du stockage de données, dans la mesure où elle pourrait servir d'unité de stockage d'information binaire extrêmement miniaturisée pilotable par des impulsions lumineuses (à raison d'un bit par molécule, un disque de 12 centimètres de diamètre pourrait contenir de 20 à 50 To).

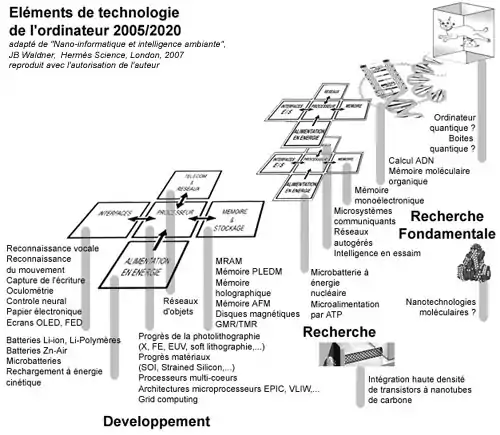

Nano-informatique et Intelligence Ambiante

L’ordinateur de la décennie à venir est donc en pleine mutation. Les nouveaux processeurs hérités de la génération conventionnelle des semi-conducteurs, vont progressivement croiser des architectures empruntées aux technologies organiques ou équipées des premiers composants moléculaires. Les mémoires vont suivre la même voie de miniaturisation à l’échelle moléculaire. Les dispositifs de stockage de masse vont désormais stocker en trois dimensions (dans des protéines ou dans des cristaux) ce qu’ils stockaient jusque-là en deux dimensions à la surface d’un disque optique ou magnétique. Mais ces disques magnétiques, tout comme les composants au silicium, continuent pourtant à se perfectionner en exploitant les phénomènes quantiques.

La mobilité a introduit un autre besoin : celui de l’autonomie énergétique. Les batteries chimiques se font plates comme une feuille de papier, légères et toujours plus puissantes. La nouvelle génération d’objets ambiants et communicants explore de nouvelles approches : des alimentations utilisant les molécules d'ATP comme les êtres vivants, des micromoteurs à combustion, ou encore des microbatteries nucléaires bien éloignées de nos piles conventionnelles.

Ces micro-objets ambiants, diffusés au plus profond du monde réel sont capables de communiquer entre eux et avec les utilisateurs de la manière la plus naturelle. Cela veut dire que les interfaces entre les utilisateurs et la machine ne sont plus limités à nos simples claviers, souris et écrans, mais utilisent désormais nos cinq sens. Certaines interfaces s’affranchissent même de passer par ces sens, puisque les systèmes neuraux ou le contrôle télépathique sont déjà une réalité. Ce n'est pas l'œil qui voit, c'est le cerveau !

Le vaste réseau d’objets minuscules et hétérogènes que constitue la nouvelle génération de systèmes distribués capillaires (l'Intelligence Ambiante ou les réseaux d'objets ambiants), impose une nouvelle vision du logiciel. Les métiers de l’informatique doivent s’adapter. Le développement et la maintenance des applications ne se bornent plus à un ensemble fini de programmes aux durées de vie importantes, mais doit prendre en compte un vaste périmètre de microsystèmes interagissant les uns sur les autres, d’une incroyable diversité et dans un contexte où, comme dans le monde vivant une fois encore, l’instabilité et l’évolution sont la règle.

Bibliographie

- Nano-informatique et Intelligence Ambiante, Jean-Baptiste Waldner, Hermes Science, London, 2006, (ISBN 2746215160)

- Technology Forecast: 2000 - From Atoms to Systems: A perspective on technology, PriceWaterhouseCoopers, PriceWaterhouseCoopers Technology Center, 2000, (ISBN 189186503X)

- Navigating the future of software: 2002-2004, PriceWaterhouseCoopers, PriceWaterhouse Coopers Technology Center, 2002

- The incredible Shrinking Circuit, Charles. M. Lieber, Scientific American, 2001

- Engines of Creation: The Coming Era of Nanotechnology, Kim Eric Drexler, Anchor Books, New York, 1986, (ISBN 0385199732)

- Nanosystems: Molecular Machinery, Manufacturing, and Computation, Kim Eric Drexler, Wiley-Interscience, 1992

- Machine-Phase Technology, Kim Eric Drexler, Scientific American, 2001

- Génie Génétique, Stefan Ryser & Marcel Weber, Editiones Roche, Bâle, 1992, (ISBN 390794674X)

- Le quantronium, Daniel Estève, premier pas vers un processeur quantique, CEA Technologies n°63, 2002

- Vers des processeurs quantiques, Daniel Esteve, Clés CEA n°52, 2005

- Spintronics and Magnetic nanostructures, School of Physics and Astronomy, B.J.Hickey, C.H.Marrows, D. Greig, G.J. Morgan, E.C.Stoner Laboratory, University of Leeds, 2002

- Memory of the future: two directions, Maksim Len, Digit-Life.com, 1997-2004

- Protein-based three-dimensional memories and associative processors, Robert R. Birge, B. Parsons, Q.W. Song & J.R. Tallent, M.A. Ratner and J. Jortner. Oxford, U.K. : Blackwell Science, Ltd, 1997

- La société de l'esprit, Marvin Minsky, Interéditions 1988, (ISBN 2729601880)

- Jonctions tunnel magnétiques, Michel Hehn, LPM Nancy, 2001

- How Much Information? 2003, Peter Lyman & Hal R. Varian, SIMS University of California, Berkeley, 2003

- Nanocomputers & Swarm Intelligence, Jean-Baptiste Waldner, ISTE, London, 2007, (ISBN 9781847040022)

- La Radio-Identification, Philippe Lemoine, CNIL, 2003