Technologies matérielles dédiées au centre de calcul

Définition

Les technologies matérielles dédiées au centre de calcul orienté Cloud Computing sont définies par leur contenant, le centre de données, et son contenu.

L'architecture du centre de données ainsi que la gestion du réseau et la gestion du matériel influent sur la gestion de l’énergie.

La gestion de l'énergie impacte le coût, la puissance et le choix des technologies utilisées.

Matériel pour la Gestion de l'Énergie

Malgré la multiplication des centres de données, selon le site datacentermap[1], l’intensité énergétique des centres de données aurait diminué de 20 % par an depuis 2010. Quant à la consommation d’énergie celle-ci n’a crû que de 6 % entre 2010 et 2018[2]. Cependant les progrès d’efficacité énergétique des centres de données n’auraient pas été mesurés à leur juste niveau au cours des dernières années, selon un article publié par des chercheurs américains dans le magazine Science du 28 février 2020[3]. La prise de conscience des politiques, des chercheurs mais aussi des grands industriels(certification ISO 50001) n'est pas étrangère à ce ralentissement conséquent de la consommation d'énergie. Les paragraphes suivants démontrent par des articles scientifiques, de presse spécialisée, d'études que le sujet « gestion de l'énergie » est au centre des réflexions et c'est par ailleurs un moteur de recherche pour le développement de nouvelles technologies dans les domaines de l'alimentation électrique, la climatisation, la virtualisation et la fabrication des composants électroniques.

Problématiques

Les technologies numériques telles que le « cloud computing », l’Internet des objets, le big data, les plates-formes sociales, nécessitent des infrastructures de traitement et de stockage de plus en plus importantes et de plus en plus énergivores. La plus grande partie de cette énergie est rejetée dans l’atmosphère sous forme de chaleur. Comment la récupérer et l'utiliser ? Des réalisations existent et de nouveaux projets et solutions techniques se développent. En 2016, 3 % de l’électricité mondiale étaient consommés par les centres de données, 650 térawatt-heures : c'est la consommation prévue des centres de données du monde entier en 2020 selon une estimation relayée par le média canadien CBC[4]. De plus en plus de centres de données se construisent aux quatre coins de la planète, une récente étude en dénombre plus 4500. À titre d’exemple, la totalité des centres de données Google[5] représente plus de 900 000 serveurs. Des équipements qu’il faut alimenter en électricité avec des transformateurs électriques, onduleurs, des groupes électrogènes de secours, mais surtout qu’il faut refroidir. Et la 5G qui ne manque pas à l’appel de la production de chaleur par sa vitesse et une capacité de transport des données augmentées, une latence plus faible et une densité de connexion plus élevée que les technologies précédentes. Actuellement le refroidissement consomme souvent 30 à 60 % de l’électricité entrante dans le centre de données suivant l’ancienneté de celui-ci et les technologies utilisées[6]. Avec la 5G, on pourrait s’attendre à une augmentation de la facture dans les prochaines années.

Le refroidissement

•Par évacuation de la chaleur

Évacuer la chaleur des centres de données est l'un des enjeux majeurs et pourtant l’un des moins bien compris des environnements informatiques vitaux. Les équipements informatiques et les nouvelles technologies utilisent une quantité d'électricité identique ou même supérieure à celle des équipements remplacés. La chaleur produite dans les centres de données augmente donc. Des systèmes précis de refroidissement et d'évacuation de la chaleur sont utilisés pour collecter et transporter cette énergie thermique indésirable pour la rejeter à l'extérieur dans l'atmosphère.

Le livre blanc Les différentes technologies de refroidissement des centres de données[7]écrit par Tony Evans et édité par Schneider Electric dénombre 13 grandes méthodes d'évacuation de la chaleur pour refroidir l'environnement informatique et acheminer l'énergie thermique indésirable depuis le matériel informatique jusqu'à extérieur. On retrouve une ou plusieurs de ces méthodes de refroidissement dans la quasi-totalité des salles informatiques et des centres de données vitaux.

La plus grande partie de ces méthodes utilise le cycle de réfrigération comme principal moyen de refroidissement.

•Par Immersion du centre de données

Le projet Natick[8] lancé en 2018 de centre de données aquatique, plongé à environ 36 mètres de profondeur a été ramené à la surface en septembre 2020. L’objectif principal de ce projet est la réduction de l’empreinte carbone des centres de données, un succès selon Microsoft. La zone choisie est entièrement alimentée par des énergies renouvelables, principalement du solaire et de l’éolien, mais aussi par des technologies du Centre européen de l’énergie marine, encore en cours d’expérimentation. Sur les 864 serveurs, seulement 8 ont été retrouvés défectueux.

•La solution « bain d’huile »

50 % de la consommation d’énergie des centres de données est due à la climatisation et aux autres systèmes de refroidissement des infrastructures. Une solution économique qui consiste à plonger les serveurs dans un bain d’huile diélectrique est proposée par une société néerlandaise Asperitas. Cette solution permettrait d’emmagasiner la chaleur produite par les composantes électroniques des serveurs dans l’huile[9] et de limiter ainsi l’utilisation des climatiseurs. Une solution simple et plutôt écologique, qui devrait aider à réaliser des économies significatives sur les factures d’électricité de façon durable.

•Climatisation inter baie

Refroidir au plus près des besoins permet d’améliorer son PUE, gagner en efficacité énergétique et préserver les équipements sensibles : serveurs, matériels actifs. C’est aussi un moyen de gagner de la surface au sol. Sous cet angle, la climatisation inter baie[10] est un refroidissement de proximité efficace et maîtrisé. Il est vraiment adapté aux besoins de l’informatique.

Structure bâtiment

•centre de données préfabriqué

Un centre de données préfabriqué est conçu sur mesure pour correspondre à la géographie, au climat, au profil technologique, aux applications informatiques et aux objectifs commerciaux d'un projet particulier tout en bénéficiant de la vitesse et des économies induites par une conception et une préfabrication modulaires.La modernisation est réalisée unité par unité. Une fois le processus achevé, le système électrique fournira les mêmes 1,5 MW à la charge informatique, toujours avec les mêmes taux d’utilisation qu’avant la mise à niveau, mais avec un rendement bien meilleur, atteignant les 96 %, et une empreinte réduite. Selon les projets l’opérateur d’un centre de données peut économiser plus de 125 000 $ en coûts d’exploitation chaque année en électricité seulement[11]

•Toit végétalisé

.jpeg.webp)

Ce tapis de verdure apporte une isolation thermique des toitures. En restituant l’eau dans l’atmosphère par évapotranspiration, le toit végétal améliore aussi le climat local, notamment en été, puisqu’il refroidit la surface de la toiture et ré-humidifie l’air, asséché par la pollution urbaine[12].

•Réduire les nuisances sonores

À la suite de diverses plaintes[13](en raison de la présence de groupes électrogènes avec moteur à combustion, certes prévus pour fonctionner en secours de l’alimentation électrique et lors des essais mensuels et la maintenance, mais également de systèmes de réfrigération installés à l’air libre sur les terrasses, prévus pour fonctionner en permanence, ainsi qu’en raison d’un trafic quotidien de l’ordre de quinze véhicules poids lourds) et plusieurs assignations en justice, les centres de données situés en zone urbaine sont tenus de respecter certaines règles, notamment la mise en application du Décret no 2006-1099 du [14]. Concernant le bruit à l'intérieur d'un centre de données, c'est l'application du décret no 2006-892 du [15].

•Ressources bibliographiques

→ Le numéro 1 mondial du PC, Lenovo, parie, lui, sur le liquid cooling. Cette technologie achemine à l'aide de tubes de l'eau tiède au plus près des composants[16]

Optimisation du matériel

Des évolutions matérielles permettent de lutter efficacement d'une part contre une propagation trop importante de chaleur et d'autre part à l'intérieur des centres de données.

- Les nouveaux serveurs de 2CRSI

Le concepteur strasbourgeois de serveurs informatiques, 2CRSI, propose une nouvelle infrastructure plus performante et moins énergivore baptisée Octopus[17]. Afin de réduire la consommation de ses nouveaux serveurs, le fabricant s’est attelé à revoir le système de refroidissement avec un système de ventilation mutualisé qui sert différents serveurs. Cette solution assure, selon 2CRSI, une ventilation 6 fois plus performante avec 23 % d’économie d’énergie.

- Reinforcement Learning. Apprentissage par renforcement

Des chercheurs du MIT (Massachusetts Institute of Technology) ont développé un planificateur appelé Decima. Leur système qui tire parti du Reinforcement Learning. Le RL fait référence à une classe de problèmes d’apprentissage automatique, dont le but est d’apprendre, à partir d’expériences successives, ce qu’il convient de faire de façon à trouver la meilleure solution, optimisant et accélérant le traitement des données[18].

Huawei a développé un système de gestion thermique qu'il appelle iCooling, s'appuyant sur l'apprentissage automatique et l'apprentissage en profondeur pour analyser les données historiques et identifier les facteurs clés affectant la consommation d'énergie[19].

- Éclairage

L’éclairage même s’il ne représente qu’entre 3 et 5 % de l’électricité nécessaire au fonctionnement des centres de données informatiques, c'est aussi un levier important pour optimiser la consommation d’électricité et diminuer l’impact environnemental de ces centres tentaculaires[20].

- Le câblage

Gestion de l'alimentation verte grâce aux cordons d'alimentation. Les cordons d'alimentation d'un centre de données peuvent avoir un impact significatif sur le PUE et les coûts opérationnels. Plus le cordon d'alimentation est court, plus la distance parcourue par l'électricité est courte, plus les temps de réponse sont rapides et plus la puissance est distribuée efficacement. Cela permet d'économiser dans tous les domaines, du financier, à l'environnement et aux performances de productivité et de fonctionnalité du centre de données. Un câblage bien organisé avec un jeu réduit libère de l'espace et augmente le flux d'air autour de l'équipement informatique, ce qui permet un meilleur refroidissement. « Passer au vert » avec des solutions de câblage haute densité peut gérer des centaines de connexions pour améliorer les performances et les coûts du centre de données[21].

- HP Virtual Connect (VC) Flex-10

Cette technologie est une solution matérielle qui permet de diviser un réseau de serveurs 10 Gb/s connexion en quatre partitions variables. Technologie Flex-10 permet de remplacer plusieurs ports NIC physiques à bande passante inférieure avec un seul port Flex-10. Cela réduit la gestion d'exigence, le nombre de NIC et de modules d'interconnexion nécessaires, ainsi que les coûts d’énergie et d’exploitation[22].

- COPA Highly Cost-Effective Power Back-Up for Green Datacenters

La COPA apporte trois nouvelles techniques. La première technique, appelée planification de la capacité minimale de l'onduleur, détermine la capacité de puissance la moins nominale et la durée de fonctionnement des onduleurs pour garantir le fonctionnement normal d'un centre de données vert pendant les pannes de courant du réseau.

La deuxième technique, nommée UPS coopérative / alimentation électrique renouvelable, utilise des onduleurs et de l'énergie renouvelable en même temps pour alimenter chaque rack en cas de panne du réseau.

Le dernier, baptisé gestion dynamique de l'énergie sensible aux énergies renouvelables, contrôle la consommation d'énergie de manière dynamique en fonction de la capacité disponible d'énergie renouvelable et d'onduleur[23].

- Ressources bibliographiques

→ La conception et l'amélioration de la configuration matérielle ont également été analysées. L’expérimentation dans le cas du calcul haute performance (HPC), les boucles de contrôle s'attaquent à une consommation d'énergie élevée en ajustant le processeur des serveurs en fonction de la variation de la charge de travail entrante[24]

→ Dell donne ses idées sur l’utilisation de techniques telles que la consolidation, l’hyperscale, la virtualisation, les solutions intégrées pour une consommation d’énergie réduite grâce à de meilleures conceptions matérielles[25]

→ Nous avons lancé une étude et nous avons observé que la quantité de CO2 majoritaire était générée lors de la production des serveurs et non lors de l’utilisation. Aujourd’hui, on change uniquement certains composants de certains serveurs[26]

→ Lorsque certains composants électroniques entrent dans un état inactif, Dynamic Power Management (DPM) exploite cette période et met ces composants à un état inactif afin de réduire la consommation d'énergie[27]

→ Depuis des années, la consommation énergétique du centre de données a pris une importance croissante suivant une explosion de demandes dans le cloud computing[28]

→ Les processeurs Intel Xeon E5 v3 présentent un rendement énergétique amélioré de jusqu'à 24 %, 1, 31 ce qui en fait les puces qui consomment le moins au monde[29]

Virtualisation

.svg.png.webp)

La virtualisation dans les centres de données permet de réduire de 50 % le nombre de postes et serveurs physiques dans le parc informatique (source : Gartner), mais également de réduire leurs performances diminuant ainsi la consommation énergétique jusqu'à 15 W par poste.

La réduction du nombre de postes et de serveurs peut entrainer une baisse de consommation électrique pouvant aller jusqu’à 80 %.

L’adoption de la virtualisation de serveur permet de diminuer le bilan carbone d'une entreprise. En passant à la virtualisation de serveur, les entreprises se dirigent vers une politique de « GREEN IT » (informatique verte).

–Remplacer un poste par un client léger permet de diviser par dix la consommation électrique.

–Qui dit moins de postes, dit moins de chaleur propagée dans vos locaux.

–Une durée de vie allongée : le matériel utilisé en virtualisation de serveur a une durée de vie supérieure à sept ans, ce qui diminue la fréquence de changement du matériel.

–En réduisant la fréquence de changement du matériel, vous réduisez également l’injection de matériaux polluants dans l’environnement.

•Ressources bibliographiques

→ Les technologies impliquées dépendent du matériel et ne sont pas contrôlées en fonction des besoins des fournisseurs de cloud. A review of green cloud computing techniques and algorithms[30].

→Les serveurs sont d'une importance vitale car ils effectuent le traitement des données dans un centre de données. En raison de la consommation d'une grande partie de l'énergie du centre de données, il est essentiel de réduire leur consommation tout en tirant le meilleur parti de leurs ressources informatiques. La virtualisation sur un serveur de type lame est un bon moyen d’atteindre cet objectif[31].

→ La technologie HP Virtual Connect (VC) Flex-10 est une solution matérielle qui permet de diviser une connexion réseau de serveur 10 Gb/s en quatre partitions variables. La technologie Flex-10 permet de remplacer plusieurs ports NIC physiques à bande passante inférieure par un seul port Flex-10

→ La stratégie proposée utilise une nouvelle technologie appelée consolidation de serveur, c’est un type de virtualisation qui permet d’atteindre l'efficacité énergétique et en même temps elle réduit l’impact des gaz à effet de serre rendant les centres de données plus écologiques[32].

Planification de charge

Les solutions DCIM sont devenues indispensables pour les personnes responsables d’un centre de données, les services de maintenance ou surveillance pour assurer le bon fonctionnement des équipements informatiques et des infrastructures, en matière de sécurité mais aussi d’efficacité énergétique et de maîtrise de tous les coûts d’exploitation[33].

•Ressources bibliographiques

→ Certains chercheurs améliorent également l'efficacité énergétique en ajustant l'énergie du centre de données. Damian et ses collaborateurs ont proposé un système intelligent pour diverses politiques énergétiques en réponse à une consommation d'énergie élevée dans les centres de données[34].

Recyclage

•Batteries de voitures électriques de seconde vie

Une entreprise de Normandie, spécialisée dans le stockage de données, a inauguré en juin 2016 le premier centre de données green d'Europe. Un projet innovant sur le plan environnemental. Les panneaux sont reliés un onduleur spécifique conçu par les équipes d’Eaton et à des batteries de voitures électriques Nissan[35] de seconde vie, qui ont chacune une capacité de 17 000 watts », précise Emmanuel Assié. « Un très gros travail d’optimisation du refroidissement de la salle a été réalisé par Axel Betton du bureau d’étude AB Ingé afin d’exploiter au mieux l’air extérieur comme principal vecteur de refroidissement de la partie IT.

Devant l'augmentation de l'efficience énergétique des serveurs et des équipements de stockage, des critères de réparabilité et de durabilité sont mis en place[36].

•Ressources bibliographiques

→ Autres indicateurs clés de performance durable d'Oracle Cloud comprennent l'utilisation de matériels hardware recyclés et reconditionnés, la gestion de l'énergie pour le système de refroidissement dans les centres de données[37].

Gestion power supply

Gestion fiable de l'énergie des racks serveurs et équipements réseau par bandeaux d'alimentation PDU intelligents.

Ces PDUs intelligents sont disponibles dans un certain nombre de configurations et par différents fabricants, tels que Avocent / Emerson, Geist, Raritan, Dataprobe, Servertech et Uptime Devices.

Beaucoup d'iPDU peuvent être gérés par leur serveur web embarquée qui permet la gestion de la configuration et la surveillance / mesure de paramètres environnementaux. Ces capacités combinées avec les fonctions DCIM traditionnelles du centre de données permettent une gestion sécurisée et une surveillance du réseau d'alimentation de haut niveau.

La surveillance de la puissance électrique et de l'environnement est possible en utilisant la solution innovante sans fil de Packet Power. Celle ci recueille et enregistre les paramètres de puissance et permet d'évaluer et d'optimiser leur PUE (Power Usage Effectiveness). Cette solution est adaptée pour la modernisation ou pour la création de nouveaux centres de données.

•Ressources bibliographiques

→ Les résultats montrent que COPA réduit respectivement 47 % et 70 % du coût de secours électrique pour un centre de données alimenté par l'énergie solaire et un centre de données alimenté par l'énergie éolienne[38].

Le partage en solution

Les centres de données Hyperscales sont apparus il y a une dizaine d’années lorsque des entreprises comme Amazon et Google ont commencé à avoir besoin de flottes d’un quart de million de serveurs ou plus. Lancé par Facebook en 2011 pour partager des solutions matérielles et logicielles pour rendre l’informatique plus économe en énergie.

•Ressources bibliographiques

How to stop data centres from gobbling up the world’s electricity[39].

Généralités

• Ressources bibliographiques

→ Characterization of the Current Conditions of the ITSA Data Centers According to Standards of the Green Data Centers Friendly to the Environment[40].

→ Il serait aussi possible de rendre l’utilisation d’énergie des centres de données plus efficace. Selon une étude menée par Control Up, 77 % des serveurs sont suréquipés en hardware et ceci augmente inutilement leur consommation[41]

→ Conception des centres de données: dispositifs écologiques qui améliorent l'efficacité énergétique et la conservation d'énergie des centres de données (c.-à-d. Systèmes mécaniques et électriques écoénergétiques, énergie verte, utilisation de la lumière naturelle, etc.)[42].

→ La chaleur fatale rejetée par les centres de données constitue une source d’énergie récupérable pour d’autres usages[43].

→ Diverses techniques, y compris la structure des données, le matériel, le système ou l’optimisation au niveau du réseau ont été proposées pour réduire la consommation d’énergie des routeurs et/ou commutateurs[44]

→ Environnement et économie : une relation équivoque[45]

Technologie matérielle pour le réseau

Le réseau informatique d'un centre de calcul est une ressource critique car il est responsable de l'interconnexion des serveurs et de l'infrastructure de stockage[46].

Ce réseau est composé notamment de routeurs, commutateurs, pare-feu et de câblages.

L’interconnexion de ces composants avec le reste du système d’information d’un centre de calcul contribue à l’échange de donnée en intra centre de calcul, en inter centre de calcul, et en externe avec les clients.

L'augmentation des exigences et des besoins des centres de calcul nécessite de gérer l'infrastructure réseau. Que cela soit dans le centre de calcul traditionnel ou moderne type Cloud, il est nécessaire de passer par des supports de transmissions adéquats pour interconnecter l’ensemble de ces équipements.

Les supports de transmission

Les technologies de transmission filaire (cuivre, optique) et sans fil sont largement utilisées dans les réseaux informatiques. Et sont déterminants en fonction de l'usage spécifique qui en fait. Les câbles et connecteurs Ethernet cuivre sont largement utilisés dans les réseaux de centres de calcul, les fibres optiques sont privilégiées pour des besoins de transfert de données élevé, une faible perte de transmission et une faible consommation d'énergie[47]. Le réseau sans fil offre une interconnexion avec plus de flexibilité.

| Type de Câble | Standard | Largeur de bande | Distance | Usage |

|---|---|---|---|---|

| Cuivre | 1000BASE-T, 10GBASE-T | 1000 Mbps, 10 Gbps | 100m | intra Centre de Calcul |

| Fibre Optique | 40GBASE-LR, 100GBASE-LR4, Infiniband | 40 Gbps, 100 Gpbs | 10 km | intra et inter Centre de Calcul |

| Onde Radio/ Sans fils | IEEE 802.11.ad | 7 Gpbs | 10 m | intra Centre de Calcul |

La limite de 100Gbps ne suffit pas, poussés par de plus en plus applications gourmandes en bande passante, les services cloud et applications 5G à venir. Les réseaux de centres de calcul augmentent en capacité pour des solutions plus rapides. Principaux fournisseurs de services cloud, tels qu'Amazon, Facebook, Google, et Microsoft, ont déjà adopté 100Gbps et vont rapidement passer à 400Gbps (norme 802.3bs) et au-delà.

En effet, la portée d'une liaison non amplifiée est limitée en puissance, et elle dépend principalement de l'optique la puissance de sortie de l'émetteur, la perte de liaison de la fibre et la sensibilité du récepteur optique. Cela est possible en utilisant avec des modules optiques enfichables CFP2 à 100Gbps et CFP8 à 400Gbps.

Aujourd'hui, l'industrie s'oriente vers des modules optiques enfichables à 400Gbps avec encore plus compacts avec les modules QSFP enfichables[48].

Pour répondre à ce besoin énorme de bande passante notamment pour interconnecter les centres de calcul, le multiplexage optique par division de longueur d'onde (WDM) est une technologie appréciée. Celle-ci peut prendre en charge plus de 100 longueurs d'onde par fibre et un taux de transmission de 100 Gbps par longueur d'onde. Ces réseaux optiques sont généralement basés sur la commutation de circuits optiques, par exemple, le commutateur de systèmes micro-électromécaniques (MEMS)[49].

Le choix de l’architecture physique d’un réseau est important et à impact très fort sur le coût, la fiabilité, l'exploitabilité et l'évolutivité du câblage.

Dans un centre de calcul, il existe plusieurs types d'architectures pour le câblage, dont TOR (Top of Rack) et EOR (End of Row).

Architecture hiérarchique

L'architecture classique d'un centre de calcul est répartie sur trois niveaux, Core, Aggregation, et Accès.

ToR consiste à installer un commutateur d’accès dans chaque baie pour raccorder tous les serveurs qui y sont insérer. Les serveurs sont directement liés au commutateur d'accès dans cette méthode.

Il s'agit d'un commutateur 1RU qui est placé en position supérieure dans une baie et se connecte à tous les nœuds de calcul de cette baie.

Chaque baie de serveur possède généralement un ou deux commutateurs d'accès. Ensuite, tous les commutateurs d'accès sont connectés au commutateur d'agrégation situé dans la baie. Seule une petite quantité de câbles est nécessaire pour passer de la baie de serveur au baie d'agrégation[50].

Le but est de garder le plus gros du câblage à l’intérieur de la baie serveur. Le seul câblage vers l’extérieur étant celui des liaisons montantes du commutateur ToR vers les commutateur d’Agrégation/Core.

EOR (End of Rack) fait référence au déploiement centralisé des commutateurs d'accès dans une ou deux baies à l'extrémité de chaque baie.

Dans cette architecture EoR, chaque serveur est directement lié à un commutateur d'agrégation éliminant l'utilisation de commutateurs individuels dans chaque baie[51]..

Il réduit le nombre de périphériques réseau et améliore l'utilisation des ports du réseau. Cependant, une grande quantité de câbles est nécessaire pour le câblage horizontal. Parallèlement à l'approche EoR, il existe également un modèle de variante nommé MoR (Middle of Row). Les principales différences sont que les interrupteurs sont placés au milieu de la rangée et que la longueur du câble est réduite.

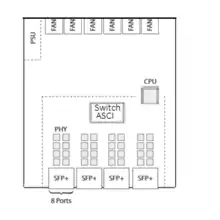

Disposition d'un commutateur TOR 10GbE 16 ports. L'unité d'alimentation (PSU) et les ventilateurs sont physiquement séparés du circuit imprimé principal pour l'intégrité du signal. Chaque cage SFP + permet jusqu'à 8 modules SFP +. Il y a une puce physical layer (PHY) qui implémente la couche physique du modèle OSI par module SFP.

L'ASIC est utilisé pour créer des commutateurs TOR. Un commutateur ASIC en lui-même n'est pas un commutateur Ethernet, c’est une facilité pour construire un commutateur fonctionnel, plusieurs autres puces sont nécessaires (PHY), ainsi que des logiciels de gestion de protocoles de mise en réseau Spanning-Tree ou OSPF. Le CPU n’est pas très puissant, tourne sous Linux et VxWorks et nécessite de la mémoire système DRAM et la mémoire flash pour du stockage secondaire[50].

Architecture maillée

Ce système hiérarchique est en train de trouver ses limites avec l’explosion des trafics de données entre serveurs (trafic dit Est- Ouest, par opposition au trafic Nord-Sud, qui va des serveurs vers les utilisateurs), une alternative à l’architecture hiérarchique traditionnelle, connue sous le nom de Leaf-Spine (littéralement, feuille-épine dorsale)[52].

Dans ce modèle, une série de commutateurs, généralement positionnés en haut de rack, constituent la couche d’accès. Ces commutateurs disposent de liens complètement maillés avec des commutateurs de plus haut niveau qui constituent l’épine dorsale du réseau.

Les architectures Leaf-Spine sont adaptées aussi bien à un réseau de niveau 2 que de niveau 3, ce qui veut dire que les liens entre une feuille et le tronc peuvent aussi bien être commutés (au niveau Ethernet) que routés (au niveau IP)[53].

L'un des composants clés de pratiquement tous les commutateurs de couche 2 ou 3 est la mémoire adressable de contenu ternaire, ou TCAM.

La mémoire TCAM est utilisée pour une recherche rapide car elle parcourt toute la mémoire en une seule opération.Mais c'est une mémoire coûteuse, qui consomme également des ressources ASIC et de haute puissance. Par conséquent, les commutateurs et routeurs sont généralement équipés d'une mémoire TCAM de taille limitée. D'une taille de stockage 2K à 4K, un Virtual TCAM qui peut stocker jusqu'à 40K.

la taille mémoire TCAM défini le nombre de règles de flux gérable, pour une taille de 36 Mo, on compte jusqu'à 64K à 128K règles de flux, et jusqu'à 384 000 entrées de flux pour un routage et une commutation rapides[53]

Commutateurs Bare Metal / White-box

Ce sont des commutateurs fabriqués par des ODM (Original Design Manufacturers) sans système d'exploitation réseau chargé sur eux. Un ODM, comme Accton ou Alpha Networks, est une entreprise qui conçoit et fabrique un produit tel que spécifié par une autre entreprise pour être rebaptisé[54]. Les clients doivent se procurer, séparément, un système d'exploitation réseau tiers NOS (Network Operating Systems) - comme Big Switch Light OS, Cumulus Linux OS, Pica8 PicOS - ou créer le leur comme Facebook avec Wedge[55] l'a fait. Le support et les services du système d'exploitation réseau doivent être obtenus auprès du NOS tiers.

Virtualisation de la fonction réseau

Les éléments virtualisables du réseau d’un centre de calcul sont nombreux, pare-feu, commutateur, répartiteur de charge, Sonde. Ces produits sont développés sous forme logiciel pour les intégrer dans l’infrastructure virtualisée. On parle de NFV (Network function virtualization), en français « la virtualisation des fonctions de réseau », et de SDN. Un socle d’infrastructure constitue le NFV (les stockages, les mémoires, les processeurs et les réseaux), ces ressources sont allouées via un hyperviseur aux machines virtuelles.

Le matériel et l’hyperviseur constituent le NFV Infrastructure Les VNF (Virtualized Network Function), en français « fonction réseau virtualisée », sont implantés sous forme de logiciels à exécuter sur ces VM avec des fonctions pare-feu, commutateur, répartiteur de charge, routeurs, etc. La fonction réseau virtualisée est un concept d'architecture de réseau qui utilise les technologies de virtualisation informatique pour virtualiser des fonctions réseau en blocs de construction qui peuvent se connecter, ou s'enchaîner, pour créer des services de communication.

Les différents organes de contrôle et d'orchestrations permettent gérer à chaque niveau les ressources physiques, virtuelles et applicatives[56]. La gestion et la configuration du réseau peuvent être centralisées avec le SDN Controller. NFV est une technologie développée par l'Institut européen des normes de télécommunication ETSI[57].

Matériel pour la Gestion du Calcul

La Gestion du Calcul sur un serveur est historiquement porté par son processeur CPU et sa mémoire vive dynamique RAM.

Dans le Cloud, il évolue de ce schéma standard vers de nouveaux modèles, avec des architectures CPU différentes, mixtes avec GPU ou en remplacement avec GPGPU.

La multiplicité des types de Cloud, Public, Hybride, Privé et Edge implique une architecture scalable ou hyperscale.

De ce fait, une vision globale est nécessaire pour choisir quel type de matériel utiliser en fonction des besoins: sa puissance en flops, son coût, son efficience énergétique.

D’autre part, ce choix doit aussi répondre la problématique principale du Cloud qui est la Latence (informatique). Celle-ci réduit la puissance de calcul par un goulot d'étranglement des Entrées-sorties qui augmentent mécaniquement la charge de travail des processeurs.

Afin de présenter l'évolution matériel par l'usage, nous avons séparé la scalabilité en 3 parties: horizontale, verticale et perpendiculaire.

- Scalabilité Horizontale pour une tendance du Cloud Public vers la "boîte à pizza" avec du 1RU.

- Scalabilité Verticale, où on notera cette tendance dans le Cloud privé avec des machines puissantes et énergivores pour le HPC.

- Scalabilité Perpendiculaire, avec la partie Cloud Edge, qui répond aux traitements en série effectués par les IoT en amont, en traitements parallèles effectués en aval.

Cette classification n'est pas rigide, plus qu'un système manichéen, c'est une nuance de gris en fonction d'une tendance.

La scalabilité diagonale, illustrée par le Cloud Hybride n'est pas présentée, car elle consiste au mélange Cloud Public / Cloud Privé, avec une prédominance verticale ou horizontale.

Scalabilité Horizontale

L'image montre le serveur 1 auquel on ajoute deux autres serveurs clone pour augmenter la puissance de calcul en 2.

La scalabilité horizontale a, comme le Parallélisme (informatique), la capacité d'étendre la puissance de traitement d'une application en multipliant le nombre de machines physiques qui lui sont attribuées. Elle se base sur une consommation d'énergie adaptative en corrélation avec les gains économiques inhérent comprenant une tolérance aux pannes et une disponibilité plus ou moins élevée en fonction des SLA

Dans ce cadre, les modèles d'architecture x86 et x64, historiquement basées sur CISC Microprocesseur à jeu d'instruction étendu Jeu d'instructions x86 avec des CPU Intel majoritaires dans le Cloud Computing, sont challengés par des modèles x86 AMD et Architecture ARM, comme ceux choisis par Amazon, est basée sur RISC Processeur à jeu d'instructions réduit.

Le Cloud Public[58] illustre cet usage. Une infrastructure informatique dans laquelle un fournisseur de services met des ressources à la disposition du public via internet. Les ressources varient selon le fournisseur mais peuvent inclure des capacités de stockage, des applications ou des machines virtuelles.

Coté puissance, une étude montre que « l'utilisation de systèmes basés sur ARM s'est avérée être un bon choix lorsque l'efficacité énergétique est nécessaire sans perte de performances[59].

Côté efficience énergétique, une évaluation à grande échelle ( 1600 vCPUen ARM64) indique que la famille de produits A1 atteint le même rapport qualité-prix dans le service Web multi niveau, jusqu'à 37% d'économies en transcodage vidéo et jusqu'à 65 % d'économies en tri à l'échelle du téraoctet, par rapport aux produits I3 et M5. familles. - The Power of ARM64 in Public Clouds[60]

Les architectures ARM sont initialement utilisées par les appareils mobiles, les architectures x86 et x64 par les serveurs.

Ci-dessous, tableau des différentes architectures, matériels, jeu de données utilisés

Tableau des CPU

| Architectures | Micro-architectures | Processeurs | jeux d'instructions | Utilisateurs |

|---|---|---|---|---|

| X86 | Skylake | Xeon | Jeu d'instruction x86 | Intel |

| X64 | Zen 2 | Epyc | Jeu d'instruction x86 | AMD |

| ARM | ARMv8 | Graviton2 based ARM Cortex A76 | Jeu d'instruction ARMv8 | Amazon |

Scalabilité Verticale

Dans notre illustration, le serveur 1 a été modifié pour avoir trois fois plus de ressources en 2.

La scalabilité verticale est la capacité d'étendre la puissance de traitement d'un composant matériel ou logiciel en lui allouant davantage de ressources physiques telles que des processeurs (CPU, GPU, xPU) ou de la mémoire sur une même machine physique.

Le Cloud Privé[61] se définit comme un ensemble de services de calcul accessibles via Internet ou un réseau interne privé à un ensemble restreint d’utilisateurs sélectionnés plutôt qu’au grand public.

Cette tendance est caractérisée par un choix matériel avec des niveaux de performances plus importants pouvant répondre aux besoins : Cloud gaming, Big Data, l'Intelligence artificielle, Machine learning, Deep learning, Simulateur quantique Cloud-based quantum computing (en), blockchain

Pour effectuer le Calcul haute performance nécessaire à ces usages, l'architecture basée sur des CPU utilisée notamment dans les Xeon Phi est remplacée par le XPU (Xeon Scalable + GPU)[62] et GPGPU comme Tesla (NVIDIA) et AMD Fusion

Pour le Deep Learning en particulier, une étude montre que le GPGPU permet d’effectuer une simplification de calcul et donc un gain de puissance en utilisant le FPU directement dans la mémoire associative (Deep Learning GPGPU = Efficient neural network acceleration on GPGPU using content addressable memory[63])

Pour le jeu, c’est l’avènement du Cloud gaming, où à la fois pour la latence d'interaction et la qualité du streaming, sont des défis critiques vers le déploiement généralisé (Cloud gaming: architecture and performance[64])

Scalabilité Perpendiculaire

Dans notre exemple, la montre connectée Smartwatch fait un premier traitement, le téléphone intelligent smartphone 5G un second et le serveur portant le Cloud en centre de calcul prend le relais.

La scalabilité Perpendiculaire est la capacité d'étendre la puissance de traitement par la puissance de travail d'une ou plusieurs autres machines, en Frontal (serveur) et/ou en middleware.

Le Edge computing illustre cet usage. L’idée est de déporter la puissance de calcul vers la périphérie pour fournir un traitement parallèle distribué et adapter QoS pour différents types d'appareils.6

Machine Learning at the Edge: Efficient Utilization of Limited CPU/GPU Resources by Multiplexing[65]

En ajoutant une dimension nouvelle, à l’horizontal et à la verticale, le partage spatial permet de fournir pour les appareils des utilisateurs finaux des capacités de calcul plus importantes que ce dont ils disposent. (Multimedia Cloud Computing[66])

Les Consoles de jeux vidéo de neuvième génération basées sur une micro-architecture CPU AMD Zen 2 associée avec une micro-architecture GPU RDNA 2 Radeon sont proposées avec le Cloud gaming. Par exemple pour PlayStation 5 deux modèles existent, le modèle Cloud comprend moins de composants et le prix d’achat moins cher.

"Deus Ex Silicium" sur Youtube présente une analyse détaillée du démontage des consoles, PlayStation 5[67] et Xbox Series[68]

Les architectures ARM sont disponibles en image dans une étude portant sur la puissance et l'efficience énergetique (Arm Neoverse N1 Cloud-to-Edge Infrastructure SoCs[69])

Côté innovation française, une entreprise grenobloise, Kalray[70] propose une architecture MIMD dans une matrice de processeurs massivement parallèle MPPA

Matériel de Gestion du Stockage

Le matériel de stockage dans les centres de données existe sous forme de bande magnetique, Disque dur, SSD dans des baies de stockage

Ce stockage est utilisé en Grappe de serveurs configurée en RAID et il est mis à disposition en NAS ou en SAN

Traditionnellement, les systèmes de stockage ont pu atteindre des taux d'E / S faibles pour les petites opérations d'E / S en raison des limitations du disque dur (HDD) qui sont capables d'environ 100-150 IOPS (opérations d'E / S par seconde) par broche - Reducing CPU and network overhead for small I/O requests in network storage protocols over raw Ethernet[71]

Alors que la désagrégation a été utilisée avec succès pendant plus de deux décennies pour séparer le stockage du calcul (c'est-à-dire les systèmes SAN / NAS), la désagrégation des ressources étroitement couplées telles que le processeur, la mémoire ou les accélérateurs a été jusqu'à présent considérée comme irréalisable en raison de la forte dépendance entre leurs performances et la latence et la bande passante fournies par leur interconnexion physique[72].

L'évolution côté stockage avec le SSD NAND 3D augmente les performances du stockage. Elle représente une solution pour sortir de cette problématique[73]

Perpectives technologiques

En 2018, l’analyste Dave Cappucio[74] annonçait que 80% des entreprises prendraient la décision de fermer leur centre de données traditionnel d’ici 2025 tout en constatant une forte croissance du marché du cloud. Le récent rachat par Spie[75] de la société allemande Planen & Bauen GmbH en décembre 2020, possédant une forte expertise dans le domaine des centres de données et le discours du ministre de l'Économie Bruno Le Maire[76] déclarant en février 2019 vouloir faire de la France « la première terre d'accueil des data centers en Europe » est de bon augure.

L’émergence de la 5G implique de revoir les stratégies de gestion d’un volume toujours plus important de données. Aujourd’hui, en effet, ce sont les centres de données centraux qui supportent l’essentiel du volume des données générées par l’Internet mobile. Or, avec l’augmentation du trafic, les réseaux backbone des opérateurs ne vont pas manquer d’être saturés.

Une saturation des réseaux et des centres de données que les opérateurs seront en mesure d’éviter à la condition d’adopter rapidement de nouvelles stratégies de dimensionnement et d’intégration de nouvelles technologies adaptées à ces évolutions. Ce qui passe notamment par un rapprochement entre les données et les antennes, afin de garantir un délai de latence satisfaisant.

Cette nouvelle approche implique de multiplier les centres de données de proximité (Euclyde25 à Besançon, Berry Data à Bourges… Sisteron lance à son tour une étude préalable de faisabilité pour la construction d'un centre de données écoresponsable) et de déployer les technologies dédiées au Edge computing.

La création de ces mini centres de données décentralisés (ou Edge data centers), reliés aux infrastructures existantes, offrira une meilleure répartition des lieux de stockage et de calcul, de façon à soulager les réseaux nationaux hors grandes villes, et par voie de conséquence, à la création d’emplois induits par les besoins d’exploitation et de maintenance associés. Les Edge data centers nécessitent les mêmes expertises en matière de connectivité réseau, d’alimentation électrique ou de refroidissement que les centres de données centralisés. En particulier dans un contexte d’ultra-densification et d’exigences réglementaires fortes, notamment en matière de consommation énergétique. Les aspects liés à la sécurité devront, quant à eux, faire l’objet d’une attention toute particulière : plus d’échanges de données, plus de centres de données et plus de terminaux élargissent d’autant l’assiette d’attaques potentielles, et complexifient, dans les mêmes proportions, les mesures de protection.

Pour autant, le délai de construction de ces mini centres de données sera plus rapide. Ils pourront être implémentés dans des endroits atypiques, comme des locaux vides en plein centre-ville. Pour leur refroidissement, le développement des technologies à base de bain d’huile pour les serveurs ou de refroidissement à eau des processeurs, pourrait favoriser leur déploiement.

En d’autres termes, le monde du centre de données s’adapte aujourd’hui aux exigences des opérateurs et évolue au gré des besoins d’autonomie des industriels. Le tout dans une démarche de sobriété énergétique, d’autant plus essentielle que l’impact du secteur numérique est croissant et engage, à cet égard, la responsabilité de toutes les parties prenantes : opérateurs, fournisseurs de contenus, constructeurs d’infrastructures, fabricants de terminaux ou encore consommateurs.

Bibliographie

- (en) Ali Abdullah Hamed Al-Mahruqi, Bernardi Pranggono, Brian Hainey et Brian Stewart, « A review of Green Cloud Computing Techniques and Algorithms », 2nd International Conference on Next Generation Computing and Communication Technologies (ICNGCCT 2015), Mudranik Technologies, , p. 8 (ISBN 9789383701353)

- (en) Yan Yin, Xu Zhou, Lieven Eeckhout, Amer Qouneh, Tao Li et Zhibin Yu, « COPA: Highly Cost-Effective Power Back-Up for Green Datacenters » (Document universitaire), IEEE Computer Society, vol. XXXI, , p. 967-980 (ISSN 1045-9219, e-ISSN 1558-2183, DOI 10.1109/TPDS.2019.2948336)

- Cécile Diguet, Fanny Lopez et Laurent Lefèvre, et Caisse des depots et consignations, fondation tuck, institut national de recherche en inform, « L' Impact spatial et énergétique des data centers sur les territoires » (rapport et synthèse), Projet Enernum, , p. 10

- (en) Filippo Vanara et Vladimir Kroa, « Datacenter Efficiency and Carbon Footprint: The New Battleground for Cloud Providers in Europe » (Document Scientifique), IDC, , p. 12

- (en) Yuling Li, Xiaoying Wang, Peicong Luo et Qingyi Pan, « Thermal-Aware Hybrid Workload Management in a Green Datacenter towards Renewable Energy Utilization » (Document scientifique), MDPI, Basel, Suisse, , p. 18 (e-ISSN 1996-1073, DOI 10.3390/en12081494)

- (en) Mueen Uddin et Azizah Abdul Rahman, « Server Consolidation: An Approach to Make Data Centers Energy Efficient & Green », International Journal of Scientific & Engineering Research, , p. 7 (DOI 10.14299/ijser.2010.01.002, arXiv 1010.5037)

- (en) Kim, Jae.H H, Lee et J Myung, « Green IT Technologies Applications , » (Livre en ligne), Projet Enernum, Berlin, Springer, , p. 445 (ISBN 978-3-642-22178-1, DOI 10.1007/978-3-642-22179-1)

- (en) Reddy Narsimha, « Hardware Based I/O Virtualization Technologies for Hypervisors, Configurations and Advantages - A Study », 2012 IEEE International Conference on Cloud Computing in Emerging Markets (CCEM), , p. 99 -104 (ISBN 978-1-4673-4421-0, DOI 10.1109/CCEM.2012.6354610)

- (en) Nicola Jones, « How to stop data centres from gobbling up the world’s electricity », Nature, (DOI 10.1038/d41586-018-06610-y)

- Jean-Marc Pierson et Laurent Lefèvre, CNRS, « Le Big Data est-il polluant ? » (dossier scientifique), Le journal du CNRS,

- (en) Leonel Hernandez et Genett Jimenez, « Characterization of the Current Conditions of the ITSA Data Centers According to Standards of the Green Data Centers Friendly to the Environment » (Publication conférence), Springer International Publishing AG 2017, Cybernetics and Mathematics Applications in Intelligent Systems, , p. 13 (ISBN 9789383701353, DOI 10.1007/978-3-319-57264-2_34)

- (en) Shi Liang, Guo Xintong, Luo Lailong et Qin Yudong, « Green and Fault-Tolerant Routing in Data Centers » (article scientifique), College of Information System and Management, National University of Defense Technology, vol. 9196, , p. 14 (ISBN 978-3-319-22046-8, DOI 10.1007/978-3-319-22047-5_38)

- (en) Andrea Reale et Dimitris Syrivelis, « Experiences and challenges in building next-gen optically disaggregated datacenters : (invited paper) », Photonics in Switching and Computing (PSC), , p. 1 (ISBN 978-1-4673-4421-0, DOI 10.1109/CCEM.2012.6354610)

- (en) Toni Mastelic, Ariel Oleksiak, Holger Claussen, Ivona Brandic, Jean-Marc Pierson et Athanasios V.Vasilakos, « A Cloud computing: survey on energy efficiency », article scientifique, Open Archive Toulouse Archive Ouverte, , p. 37 (ISSN 0360-0300, DOI 10.1145/2656204)

- (en) Luca Ardito et Maurizio Morisio, « Green IT - available data and guidelines for reducing energy consumption in IT Systems » (Article Scientifique), Politecnico di Torino, Elsevier, , p. 24-32 (ISSN 2210-5379, DOI 10.1016/j.suscom.2013.09.001)

- (en) Jyrki Huusko, Hermann de Meer, Sonja Klingert et Andrey Somov, Energy Efficient DataCenters, Madrid, Spain, Springer-Verlag Berlin Heidelberg, , 163 p. (ISBN 978-3-642-33645-4, ISSN 0302-9743, e-ISSN 1611-3349, DOI 10.1007/978-3-642-33645-4)

- (en) Leylane Ferreira, Patricia Takako Endo, Daniel Sanders, Daniel Rosendo et Guto Leoni Santos, « Standardization Efforts for Traditional Data Center Infrastructure Management: The Big Picture », IEEE Engineering Management Review, vol. 48, no 1, , p. 92-103 (ISSN 1937-4178, DOI 10.1109/EMR.2020.2969864)

- (en) Rafael Vidal Aroca et Luiz Marcos Garcia Gonçalves, « Towards green data centers: A comparison of x86 and ARM architectures power efficiency », Journal of Parallel and Distributed Computing, vol. 72, no 12, , p. 1770-1780 (ISSN 0743-7315, DOI 10.1016/j.jpdc.2012.08.005)

- (en) Wenfeng Xia, P Zhao et H Xie, « A Survey on Data Center Networking (DCN): Infrastructure and Operations », IEEE Communications Surveys Tutorials, vol. 19, no 1, , p. 640-656 (ISSN 1553-877X, DOI 10.1109/COMST.2016.2626784)

- (en) Pilar Gonzalez-Ferez et Angelos Bilas, « Reducing CPU and network overhead for small I/O requests in network storage protocols over raw Ethernet », 2015 31st Symposium on Mass Storage Systems and Technologies (MSST), , p. 1 (ISSN 2160-1968, DOI 10.1109/MSST.2015.7208293)

- (en) Andrea Pellegrini et Chris Abernathy, « Arm Neoverse N1 Cloud-to-Edge Infrastructure SoCs », 2019 IEEE Hot Chips 31 Symposium (HCS), , p. 1-21 (ISBN 978-1-7281-2089-8, ISSN 2573-2048, DOI 10.1109/HOTCHIPS.2019.8875640)

- (en) Qingye Jiang, Young Choon Lee et Albert Y Zomaya, « The Power of ARM64 in Public Clouds », 2020 20th IEEE/ACM International Symposium on Cluster, Cloud and Internet Computing (CCGRID), , p. 459 - 468 (ISBN 978-1-7281-6095-5, DOI 10.1109/CCGrid49817.2020.00-47)

- [(fr) What-are-data-center-class-switches]

- (en) Nathan Farrington, Erik Rubow et Amin Vahdat, « Data Center Switch Architecture in the Age of Merchant Silicon », 2019, , p. 2-6 (DOI 10.1109/HOTI.2009.11)

- [(en) Data Center Spine Leaf Architecture]

- (en) M.K Khattak et Y Tang, « Effective Routing Technique: Augmenting Data Center Switch Fabric Performance », 2020 IEEE Access, , p. 37373-37374 (ISBN 978-1-7281-2089-8, ISSN 2169-3536, DOI 10.1109/ACCESS.2020.2973932)

- (en) Ryan Shea, Liu Jiangchuan, Edith C H Ngai et Yong Cui, « Cloud gaming: architecture and performance », 2013 IEEE Network, , p. 16 - 21 (ISSN 0890-8044, DOI 10.1109/MNET.2013.6574660)

- (en) Wenwu Zhu, Chong Luo, Jianfeng Wang et Shipeng Li, « Multimedia Cloud Computing », 2011 IEEE Signal Processing Magazine, , p. 59 - 69 (ISSN 1558-0792, DOI 10.1109/MSP.2011.940269)

- (en) Aditya Dhakal, Sameer G Kulkarni et K K Ramakrishnan, « Machine Learning at the Edge: Efficient Utilization of Limited CPU/GPU Resources by Multiplexing », 2020 IEEE 28th International Conference on Network Protocols (ICNP), , p. 1 - 6 (ISBN 978-1-7281-6992-7, ISSN 2643-3303, DOI 10.1109/ICNP49622.2020.9259361)

- (en) Diego Kreutz et Fernando Ramos, « Software-Defined Networking: A Comprehensive Survey », 2014 ResearchGate VOL 103, , p. 9 (ISSN 1558-2256, DOI 10.1109/JPROC.2014.2371999)

- (en) Mohsen Imani, Daniel Peroni, Yeseong Kim, Abbas Rahimi et Tajana Rosing, « Deep Learning GPGPU = Efficient neural network acceleration on GPGPU using content addressable memory », 2017 Design, Automation & Test in Europe Conference & Exhibition (DATE), 2017, , p. 1026 - 1031 (ISBN 978-1-5090-5826-6, DOI 10.23919/DATE.2017.7927141)

- (en) Yue Yang, Wang Qiang et Anderson Jon, « Experimental Investigation of 400 Gb/s Data Center Interconnect Using Unamplified High-Baud-Rate and High-Order QAM Single-Carrier Signal », 2019, , p. 2-3 v9 (DOI 10.3390/app9122455)

- [(fr) facebook-lance-wedge-son-switch-open-source (accès direct article)]

- (en) Maotong Xu, Jelena Diakonikolas, Eytan Modiano et Suresh Subramaniam, « A Hierarchical WDM-Based Scalable Data Center Network Architecture », 2019, , p. 1 (DOI 10.1109/ICC.2019.8761186)

- (en) Mohammad Abu-Lebdeh, Diala Naboulsi, Roch Glitho et Constant Wette, « NFV Orchestrator Placement for Geo-Distributed Systems », 2017, , p. 1 (DOI 10.1109/NCA.2017.8171391)

- [(en) https://www.etsi.org/technologies/nfv/nfv (accès direct article)]

Reférence

- Site de datacentermap,

- Site connaissancedesenergies.org,

- Site du magazine Science,

- Site de clubic.com,

- Site alejandrobarros.com page 23,

- Site filiere-3e.fr,

- Livre Blanc Schneider Electric,

- Site lemondeinformatique,

- Site Asperitas,

- Site Efirack,

- Site Vertiv. Livre Blanc page 5,

- Site Greenit,

- Site lemondeinformatique.fr. Tribunal de Montreuil,

- Site legifrance.gouv.fr. Bruit voisinage,

- Site legifrance.gouv.fr. Bruit au Travail,

- Julian 2018, p. 3

- Site 2crsi,

- Site itsocial.fr,

- Site aitrends.David Turek,

- Site Airfal,

- Site pduwhips,

- Narsimha Reddy 2012, p. 3

- Site ieeexplore.ieee.org,

- Huusko Jyrki 2012, p. 20

- Site academia.edu,

- Site infomaniak.fr,

- Site tel.archives-ouvertes.fr,

- Site catalogue-bibliotheques.imt.fr,

- Site Intel.fr,

- Al-Mahruqi 2015, p. 3

- Toni Mastelic 2012, p. 5

- Mueen Uddin 2010, p. 3

- Site www.filiere-3e.fr,

- Yuling Li 2019, p. 4

- Site Actu Normandie,

- Site Greenit. Frédéric Bordage,

- Filippo Vanara 2020, p. 7

- Yan Yin 2019, p. 1

- Nicola Jones 2018, p. 2

- Leonel Hernandez 2017, p. 7

- Site lebigdata.fr,

- Ardito Luca 2013, p. 3

- Cécile Diguet 2019, p. 6

- Jae.H Kim 2011, p. 154

- Site journals.openedition. Olivier Boiral. 2004,

- Leylane Ferreira 2020, p. 97

- Wenfeng Xia 2017, p. 641

- Yue Yang 2019, p. 2

- Xu 2019, p. 1

- Farrington, 2009, p. 6

- Andrew Froehlich, et 2015 What-are-data-center-class-switches

- fabricplane2020

- Khattak2020_page37373

- Diego2014_page9

- Facebook lance Wedge

- NFV Orchestrator

- etsi.org

- Rafael Vidal Aroca 2018, p. 1770-1780

- Jiang 2020, p. 459 - 468

- Imani 2017, p. 1026 - 1031

- Shea 2013, p. 16 - 21

- Dhakal 2011, p. 1 - 6

- Zhu 2011, p. 59 - 69

- Pellegrini 2019, p. 1-21

- Gonzalez-Ferez 2015, p. 1

- Andrea Reale 2018, p. 1

- Site thrive.dxc.technology. Analyste Dave Cappucio,

- Site Spie.com,

- Site minefi.hosting.augure. Discours Bruno Le Maire,

Articles connexes

Vous trouverez-ci-dessous la liste non-exhaustive des articles en lien avec le sujet :

transformateurs électriques, onduleurs, groupes électrogènes, Bloc d'alimentation, Méthodes de refroidissement pour ordinateur, routeurs, Commutateur réseau, pare-feu, Unité de rack, Mémoire vive dynamique, sonde informatique , C Form-factor Pluggable, Quad Small Form-factor Pluggable, Multiplexage en longueur d'onde Microsystème électromécanique,Hyperviseur Processeur, Latence (informatique), Entrées-sorties, Microprocesseur à jeu d'instruction étendu, Processeur à jeu d'instructions réduit, General-purpose processing on graphics processing units, PHYceiver, Smartwatch, smartphone.

- Architectures, process et normes: 5G IEEE 802.3, ISO 50001, x86, x64, Architecture ARM, Parallélisme (informatique) Calcul distribué Service-level agreement, virtualisation, Unité de calcul en virgule flottante, FLOPS, Frontal (serveur), middleware

- Type d'utilisation :

Centre de données Informatique en nuage, Internet des objets, big data, Fog computing, Cloud gaming ou Jeu à la demande, Big Data, Intelligence artificielle, Machine learning, Deep learning, Simulateur quantique, blockchain, Superordinateur, Edge computing