Régression logistique

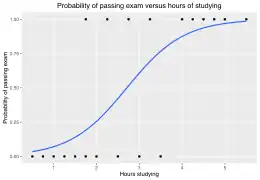

En statistiques, la régression logistique ou modèle logit est un modèle de régression binomiale. Comme pour tous les modèles de régression binomiale, il s'agit d'expliquer au mieux une variable binaire (la présence ou l'absence d'une caractéristique donnée) par des observations réelles nombreuses, grâce à un modèle mathématique. En d'autres termes d'associer une variable aléatoire de Bernoulli (génériquement notée ) à un vecteur de variables aléatoires . La régression logistique constitue un cas particulier de modèle linéaire généralisé. Elle est largement utilisée en apprentissage automatique.

| Type |

Modèle de régression (d), modèle linéaire généralisé, modèle discriminatif |

|---|---|

| Inventeur | |

| Aspect de |

Histoire

D'après de Palma et Thisse, la première mention du modèle logit vient de Joseph Berkson en 1944[1] et 1951[2] - [3].

Applications

La régression logistique est largement répandue dans de nombreux domaines. On peut citer de façon non exhaustive :

- En médecine, elle permet par exemple de trouver les facteurs qui caractérisent un groupe de sujets malades par rapport à des sujets sains.

- Dans le domaine des assurances, elle permet de cibler une fraction de la clientèle qui sera sensible à une police d’assurance sur tel ou tel risque particulier.

- Dans le domaine bancaire, pour détecter les groupes à risque lors de la souscription d’un crédit.

- En économétrie, pour expliquer une variable discrète. Par exemple, les intentions de vote aux élections.

Par exemple, Vincent Loonis utilise un modèle de régression logistique pour étudier les déterminants de la réélection des députés français depuis les débuts de la IIIe République[4].

Modèle

Notations

Soit la variable à prédire (variable expliquée) et les variables prédictives (variables explicatives).

Dans le cadre de la régression logistique binaire, la variable prend deux modalités possibles . Les variables sont exclusivement continues ou binaires.

- Soit un ensemble de échantillons, comportant (resp. ) observations correspondant à la modalité (resp. ) de .

- (resp. ) est la probabilité a priori pour que (resp. ). Pour simplifier, cela sera par la suite noté (resp. ).

- (resp. ) est la distribution conditionnelle des sachant la valeur prise par

- La probabilité a posteriori d'obtenir la modalité de (resp. ) sachant la valeur prise par est notée (resp. ).

Hypothèse fondamentale

La régression logistique repose sur l’hypothèse fondamentale suivante, où l'on reconnaît la mesure nommée « évidence » popularisée par I.J. Good, E.T Jaynes et Myron Tribus pour les besoins de l'inférence bayésienne en évitant des renormalisations continuelles sur [0,1] :

où représentent les valeurs prises respectivement par les variables .

Une vaste classe de distributions répondent à cette spécification, la distribution multinormale décrite en analyse discriminante linéaire par exemple, mais également d’autres distributions, notamment celles où les variables explicatives sont booléennes (0/1).

Par rapport à l’analyse discriminante toujours, ce ne sont plus les densités conditionnelles et qui sont modélisées mais le rapport de ces densités. La restriction introduite par l'hypothèse est moins forte.

Modèle LOGIT

La spécification ci-dessus peut être écrite de manière différente. On désigne par le terme LOGIT de l’expression suivante

- Il s’agit bien d’une « régression » car on veut montrer une relation de dépendance entre une variable à expliquer et une série de variables explicatives.

- Il s’agit d’une régression « logistique » car la loi de probabilité est modélisée à partir d’une loi logistique.

En effet, après transformation de l’équation ci-dessus, nous obtenons

Remarque : Équivalence des expressions

Nous sommes partis de deux expressions différentes pour aboutir au modèle logistique. Nous observons ici la concordance entre les coefficients et . Reprenons le LOGIT

Nous constatons que

Estimation — Principe du maximum de vraisemblance

À partir d’un fichier de données, nous devons estimer les coefficients de la fonction LOGIT. Il est très rare de disposer pour chaque combinaison possible des , même si ces variables sont toutes binaires, de suffisamment d’observations pour disposer d’une estimation fiable des probabilités et . La méthode des moindres carrés ordinaire est exclue. La solution passe par une autre approche : la maximisation de la vraisemblance.

La probabilité d’appartenance d’un individu à un groupe, que nous pouvons également voir comme une contribution à la vraisemblance, peut être décrite de la manière suivante

La vraisemblance d’un échantillon s’écrit alors :

Les paramètres qui maximisent cette quantité sont les estimateurs du maximum de vraisemblance de la régression logistique.

Estimation dans la pratique

Dans la pratique, les logiciels utilisent une procédure approchée pour obtenir une solution satisfaisante de la maximisation ci-dessus. Ce qui explique d’ailleurs pourquoi ils ne fournissent pas toujours des coefficients strictement identiques. Les résultats dépendent de l’algorithme utilisé et de la précision adoptée lors du paramétrage du calcul.

Dans ce qui suit, nous notons le vecteur des paramètres à estimer. La procédure la plus connue est la méthode Newton-Raphson qui est une méthode itérative du gradient (voir Algorithme d'optimisation). Elle s’appuie sur la relation suivante :

- est la solution courante à l'étape . est une initialisation possible ;

- est le vecteur des dérivées partielles premières de la vraisemblance ;

- est la matrice des dérivées partielles secondes de la vraisemblance ;

- les itérations sont interrompues lorsque la différence entre deux vecteurs de solutions successifs est négligeable.

Cette dernière matrice, dite matrice hessienne, est intéressante car son inverse représente l’estimation de la matrice de variance covariance de . Elle sera mise en contribution dans les différents tests d’hypothèses pour évaluer la significativité des coefficients.

Sous forme matricielle :

Évaluation

Matrice de confusion

L’objectif étant de produire un modèle permettant de prédire avec le plus de précision possible les valeurs prises par une variable catégorielle , une approche privilégiée pour évaluer la qualité du modèle serait de confronter les valeurs prédites avec les vraies valeurs prises par : c’est le rôle de la matrice de confusion. On en déduit alors un indicateur simple, le taux d’erreur ou le taux de mauvais classement, qui est le rapport entre le nombre de mauvaises prédictions et la taille de l’échantillon.

Lorsque la matrice de confusion est construite sur les données qui ont servi à élaborer le modèle, le taux d’erreur est souvent trop optimiste, ne reflétant pas les performances réelles du modèle dans la population. Pour que l’évaluation ne soit pas biaisée, il est conseillé de construire cette matrice sur un échantillon à part, dit échantillon de test. Par opposition à l’échantillon d’apprentissage, il n’aura pas participé à la construction du modèle.

Le principal intérêt de cette méthode est qu’elle permet de comparer n’importe quelle méthode de classement et sélectionner ainsi celle qui s’avère être la plus performante face à un problème donné.

Évaluation statistique de la régression

Il est possible d’exploiter un schéma probabiliste pour effectuer des tests d’hypothèses sur la validité du modèle. Ces tests reposent sur la distribution asymptotique des estimateurs du maximum de vraisemblance.

Pour vérifier la significativité globale du modèle, nous pouvons introduire un test analogue à l’évaluation de la régression linéaire multiple. L’hypothèse nulle s’écrit , que l’on oppose à l’hypothèse alternative : un des coefficients au moins est non nul

La statistique du rapport de vraisemblance s’écrit , elle suit une loi du à degrés de libertés.

- est le logarithme de la vraisemblance du modèle avec l’ensemble des variables (donc J+1 coefficients en comptant la constante) et,

- le logarithme de la vraisemblance du modèle réduit à la seule constante.

Si la probabilité critique (la p-value) est inférieure au niveau de signification que l’on s’est fixé, on peut considérer que le modèle est globalement significatif. Reste à savoir quelles sont les variables qui jouent réellement un rôle dans cette relation.

Évaluation individuelle des coefficients

Dans le cas où l’on cherche à tester le rôle significatif d’une variable. Nous réalisons le test suivant , contre .

La statistique de WALD répond à ce test, elle s’écrit , elle suit une loi du à degré de liberté.

N.B. : La variance estimée du coefficient est lue dans l’inverse de la matrice hessienne vue précédemment.

Évaluation d'un bloc de coefficients

Les deux tests ci-dessus sont des cas particuliers du test de significativité d’un bloc de coefficients. Ils découlent du critère de la « déviance » qui compare la vraisemblance entre le modèle courant et le modèle saturé (le modèle dans lequel nous avons tous les paramètres).

L’hypothèse nulle s’écrit dans ce cas , où représente un ensemble de coefficients simultanément à zéro.

La statistique du test suit une loi du à degrés de libertés.

Ce test peut être très utile lorsque nous voulons tester le rôle d’une variable explicative catégorielle à modalités dans le modèle. Après recodage, nous introduisons effectivement variables indicatrices dans le modèle. Pour évaluer le rôle de la variable catégorielle prise dans son ensemble, quelle que soit la modalité considérée, nous devons tester simultanément les coefficients associés aux variables indicatrices.

Autres évaluations

D’autres procédures d’évaluation sont couramment citées s’agissant de la régression logistique. Nous noterons entre autres le test de Hosmer-Lemeshow qui s’appuie sur le « score » (la probabilité d’affectation à un groupe) pour ordonner les observations. En cela, elle se rapproche d’autres procédés d’évaluation de l’apprentissage telles que les courbes ROC qui sont nettement plus riches d’informations que la simple matrice de confusion et le taux d’erreur associé.

Exemple

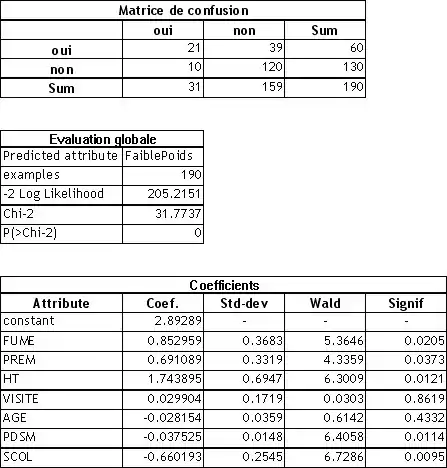

À partir des données disponibles sur le site du cours en ligne de Régression logistique (Paul-Marie Bernard, Université du Québec – Chapitre 5), nous avons construit un modèle de prédiction qui vise à expliquer le « Faible Poids (Oui/Non) » d’un bébé à la naissance. Les variables explicatives sont : FUME (le fait de fumer ou pas pendant la grossesse), PREM (historique de prématurés aux accouchements antérieurs), HT (historique de l’hypertension), VISITE (nombre de visites chez le médecin durant le premier trimestre de grossesse), AGE (âge de la mère), PDSM (poids de la mère durant les périodes des dernières menstruations), SCOL (niveau de scolarité de la mère : =1: <12 ans, =2: 12-15 ans, =3: >15 ans).

Toutes les variables explicatives ont été considérées continues dans cette analyse. Dans certains cas, SCOL par exemple, il serait peut-être plus judicieux de les coder en variables indicatrices.

Lecture des résultats

Les résultats sont consignés dans le tableau suivant.

- Dans la matrice de confusion, nous lisons que sur les données en apprentissage, le modèle de prédiction réalise 10 + 39 = 49 mauvaises prédictions. Le taux d’erreur en resubstitution est de 49/190 = 25,78 %

- La statistique du rapport de vraisemblance LAMBDA est égale à 31.77, la probabilité critique associée est 0. Le modèle est donc globalement très significatif, il existe bien une relation entre les variables explicatives et la variable expliquée.

- En étudiant individuellement les coefficients liés à chaque variable explicative, au risque de 5 %, nous constatons que FUME, PREM et HT sont néfastes au poids du bébé à la naissance (entraînent un faible poids du bébé) ; PDSM et SCOL en revanche semblent jouer dans le sens d’un poids plus élevé du bébé. VISITE et AGE ne semblent pas jouer de rôle significatif dans cette analyse.

Cette première analyse peut être affinée en procédant à une sélection de variables, en étudiant le rôle concomitant de certaines variables, etc. Le succès de la régression logistique repose justement en grande partie sur la multiplicité des outils d’interprétations qu’elle propose. Avec les notions d’odds, d’odds ratios et de risque relatif, calculés sur les variables dichotomiques, continues ou sur des combinaisons de variables, le statisticien peut analyser finement les causalités et mettre en évidence les facteurs qui pèsent réellement sur la variable à expliquer.

Déploiement

Pour classer un nouvel individu , nous devons appliquer la règle de Bayes :

ssi

Qui est équivalent à

ssi

Si nous considérons la fonction LOGIT, cette procédure revient à s’appuyer sur la règle d’affectation :

ssi

Prenons l’observation suivante = (FUME = 1 « oui » ; PREM = 1 « un prématuré dans l’historique de la mère » ; HT = 0 « non » ; VISITE = 0 « pas de visite chez le médecin pendant le premier trimestre de grossesse » ; AGE = 28 ; PDSM = 54.55 ; SCOL = 2 « entre 12 et 15 ans »).

En appliquant l’équation ci-dessus, nous trouvons . Le modèle donc prédit un bébé de faible poids pour cette personne.

Ce qui est justifié puisqu’il s’agit de l’observation n°131 de notre fichier, et elle a donné lieu effectivement à la naissance d’un enfant de faible poids.

Redressement

La règle d’affectation ci-dessus est valide si l’échantillon est issu d’un tirage au hasard dans la population. Ce n’est pas toujours le cas. Dans de nombreux domaines, nous fixons au préalable les effectifs des classes et , puis nous procédons au recueil des données dans chacun des groupes. On parle alors de tirage rétrospectif. Il est dès lors nécessaire de procéder à un redressement. Si les coefficients associés aux variables de la fonction logit ne sont pas modifiés, la constante en revanche doit être corrigée en tenant compte des effectifs dans chaque classe ( et ) et des vraies probabilités a priori et (cf. les références ci-dessous).

Variantes

La régression logistique s’applique directement lorsque les variables explicatives sont continues ou dichotomiques. Lorsqu’elles sont catégorielles, il est nécessaire de procéder à un recodage. Le plus simple est le codage binaire. Prenons l’exemple d’une variable habitat prenons trois modalités {ville, périphérie, autres}. Nous créerons alors deux variables binaires : « habitat_ville », « habitat_périphérie ». La dernière modalité se déduit des deux autres, lorsque les deux variables prennent simultanément la valeur 0, cela indique que l’observation correspond à « habitat = autres ».

Enfin, il est possible de réaliser une régression logistique pour prédire les valeurs d’une variable catégorielle comportant K (K > 2) modalités. On parle de régression logistique polytomique. La procédure repose sur la désignation d’un groupe de référence, elle produit alors (K-1) combinaisons linéaires pour la prédiction. L’interprétation des coefficients est moins évidente dans ce cas.

Notes et références

- (en) Joseph Berkson, « Application of the Logistic Function to Bio-Essay », Journal of the American Statistical Association, vol. 39, , p. 357-365

- (en) Joseph Berkson, « Why I Prefer Logits to Probits », Biometrics, vol. 7, , p. 327-329

- André de Palma et Jacques-François Thisse, « Les modèles de choix discrets », Annales d'Economie et de Statistique, (lire en ligne)

- Vincent Loonis, « Les déterminants de la réélection des députés français de 1871 à 2002 », Histoire & Mesure, vol. 21, no 1, (lire en ligne, consulté le )

Voir aussi

Bibliographie

- Ricco Rakotomalala, Pratique de la régression logistique

- M. Bardos, Analyse Discriminante - Application au risque et scoring financier, Dunod, 2001. (chapitre 3)

- Bernard, P.-M., "Analyse des tableaux de contingence en épidémiologie", Les Presses de l'Université du Québec, 2004

- Bouyer J., Hémon D., Cordier S., Derriennic F., Stücker I., Stengel B., Clavel J., Épidémiologie - Principes et méthodes quantitatives, Les Éditions INSERM, 1993

- Hosmer D.W., Lemeshow S., Applied logistic regression, Wiley Series in Probability and Mathematical Statistics, 2000

- Kleinbaum D.G., Logistic regression. A self-learning text, Springer-Verlag, 1994.

- Kleinbaum D.G., Kupper L.L., Muller E.M., Applied regression analysis and other multivariate methods, PWS-KENT Publishing Company, Boston, 1988.

- J.P. Nakache, J. Confais, Statistique Explicative Appliquée, Technip, 2003 (Partie 2)

- Pierre-François Verhulst, « Recherches mathématiques sur la loi d'accroissement de la population », Nouveaux Mémoires de l'Académie Royale des Sciences et Belles-Lettres de Bruxelles, no 18, , p. 1-42 (lire en ligne [PDF], consulté le )

- André de Palma et Jacques-François Thisse, « Les modèles de choix discrets », Annales d'Economie et de Statistique, (lire en ligne)

- (en) Thierry Magnac, « logit models of individual choice », dans Steven Durlauf et Lawrence Blume, The New Palgrave Dictionary of Economics, Palgrave Macmillan, (lire en ligne)

- (en) Ken Train, Discrete Choice Methods with Simulation, Cambridge University Press, , 2e éd., 408 p. (ISBN 978-0-521-74738-7, lire en ligne), p. 34-75 (Chapitre 3)

- (en) Andrew Gelman et Jennifer Hill, Data Analysis Using Regression And Multilevel/Hierarchical Models, Cambridge University Press, coll. « Analytical Methods for Social Research », , 1re éd., 648 p. (ISBN 978-0-521-68689-1, lire en ligne) (Chapitre 5)

![P(Y(\omega )=1\vert X(\omega ))^{{Y(\omega )}}\times [1-P(Y(\omega )=1\vert X(\omega ))]^{{1-Y(\omega )}}](https://img.franco.wiki/i/c8226cdb5ced961f7e24d0a7292330e95098d554.svg)

![L=\prod _{{\omega }}P(Y(\omega )=1\vert X(\omega ))^{{Y(\omega )}}\times [1-P(Y(\omega )=1\vert X(\omega ))]^{{1-Y(\omega )}}](https://img.franco.wiki/i/5990dfafda0774a22694d9f1fe9b7b13c5f502c3.svg)

![\Lambda =2\times [l(J+1)-l(1)]](https://img.franco.wiki/i/2e7ed02b457e015a38a64cef85634505053120b8.svg)

![W(q)=2\times [l(J+1)-l(J+1-q)]](https://img.franco.wiki/i/b95ef0db5485d38f4b477bd00c2081efd2d98e0a.svg)