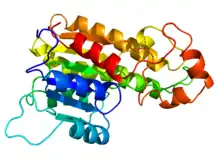

Modélisation de protéines par homologie

La modélisation de protéines par homologie, également connue sous le nom de modélisation comparative des protéines, se réfère à la construction d’un modèle d’une protéine « cible », dont la résolution est de niveau atomique, à partir de sa séquence d’acides aminés et d'une structure expérimentale tridimensionnelle d’une protéine homologue connexe (le « modèle »).

La modélisation par homologie repose sur l’identification d’une ou plusieurs structures protéiques connues susceptibles de ressembler à la structure de la séquence d’acides aminés recherchée et sur la production d’un alignement qui mappe des résidus (un acide aminé à l’intérieur d’une chaîne peptidique) dans la séquence d’acides aminés recherchée à des résidus dans la séquence d’acides aminés modèle. Cela repose sur l'intuition que la forme d'une protéine dépend de sa composition chimique, et notamment des interactions entre les différents champs de force générés par les atomes de la molécule.

La connaissance de la séquence d’acides aminés d'une protéine, permet donc une prédiction sur la forme que celle-ci aura. Pour simplifier la recherche de la forme, on ne va pas chercher à calculer le résultat de l'interaction des différents champs de forces, mais on va chercher des protéines qui ont une séquence d'acide aminé similaire et dont on connaît la forme à l'avance, parce qu'on l'a obtenu à partir de mesures faites en cristallographie ou résonance magnétique nucléaire. Comme les structures protéiques sont mieux conservées à travers l'évolution que les séquences d’acides aminés d’ADN, des niveaux détectables de similarité de séquence d’acides aminés impliquent habituellement une similarité structurelle importante. De plus, les séquences d’acides aminés qui n'ont une similitude limitée avec d'autres protéines, peuvent avoir des structures 3D très différentes.

Comme avec d’autres méthodes de prédiction de la structure, la pratique actuelle en modélisation par homologie est évaluée dans une expérience à grande échelle biennale dénommée Critical Assessment of Techniques for Protein Structure Prediction, ou CASP.

Qualité du modèle d’homologie

La qualité du modèle d’homologie est donc tributaire du choix de la protéine modèle et de la qualité de l’alignement de séquences d’acides aminés de la protéine cible avec ceux de la protéine de modèle.

L’approche peut être compliquée par la présence de lacunes d’alignement (communément appelés indels) qui indiquent une région structurelle présente dans la cible, mais pas dans le modèle, ou vice-versa. L’approche peut aussi être compliquée par des lacunes structurales dans la protéine modèle. Celle-ci peut être due à une trop faible résolution de la procédure expérimentale (habituellement la cristallographie aux rayons X) qui a été utilisée pour résoudre cette structure.

Les erreurs de modélisation sont significativement plus élevées dans les régions de coude (un coude est un élément de la structure secondaire des protéines caractérisé par un changement de direction de la chaîne polypeptidique), où les séquences d’acides aminés de la protéine cible et celles du modèle peuvent être complètement différentes.

Il est important de créer un modèle précis de cette région, parce que la fonction des protéines est déterminée par leur forme et les propriétés physico-chimiques de la surface exposée et que justement, un coude est une région où un changement conformationnel majeur a lieu. Comme les coudes ont des séquences très variables au sein même d’un motif structurel donné, les coudes correspondent souvent à des régions non alignées en alignements de séquences. Ce sont donc des régions où l'intuition motivant la modélisation par homologie, est inapplicable.

L’étendue de l’inexactitude de modélisation augmente avec le nombre d’acides aminés dans le coude. Les angles dièdres du coude des aminoacides côté chaînes sont souvent approchés au moyen d’une bibliothèque de rotamère, mais cela peut aggraver l’inexactitude de la chaîne latérale dans le modèle global.

Les erreurs de modélisation dans les chaînes latérales (une chaîne latérale est une partie de molécule rattachée au cœur ou à la chaîne principale de la structure) augmentent aussi quand la similarité diminue.

Ces différentes erreurs de positions atomiques sont cumulatives et font obstacle à l’utilisation de modèles d’homologie à des fins qui requièrent des données ayant une précision de niveau atomique, tels que les prédictions des effets médicamenteux.

Protéine multimérique

De même la structure quaternaire d’une protéine peut être difficile à prédire à partir de modèles d’homologie de ses sous-ensembles de chaînes protéiques.

La structure quaternaire d'une protéine multimérique est la manière dont sont agencées les différentes chaînes protéiques, ou sous-unités, à l'état natif les unes par rapport aux autres. Ce qualificatif ne s'applique qu'aux protéines multimériques, c'est-à-dire contenant plusieurs sous-unités. Ainsi on distingue les dimères (deux sous-unités), les trimères (trois sous-unités), les tétramères (quatre sous-unités), etc.

De manière générale, la structure quaternaire confère à la protéine sa fonction, mais il existe des exemples de protéines actives en dehors de leur complexe quaternaire. L'agencement des sous-unités peut conférer au complexe quaternaire un axe ou point de symétrie, mais ce n'est pas nécessaire.

Le principal élément de stabilisation des structures quaternaires est l'effet hydrophobe entre les acides aminés non polaires : les parties hydrophobes des monomères s'agglutinent de manière à minimiser leur surface exposée au solvant (effet entropique moteur de l'effet hydrophobe).

Néanmoins, la modélisation par homologie peut être utile pour parvenir à des conclusions qualitatives sur la biochimie de la séquence d’acides aminés recherchée, surtout dans la formulation d'hypothèses sur les raisons pour lesquelles certains résidus sont conservés, ce qui peut conduire à d’autres expériences pour tester ces hypothèses.

Par exemple, la disposition spatiale des résidus conservés pourrait suggérer qu’un résidu particulier est conservé pour stabiliser le pliage, pour participer dans certaines petites molécules de liaison, ou pour favoriser la liaison avec un autre des protéines ou des acides nucléiques.

La modélisation par homologie peut produire des modèles structuraux de qualité lorsque la cible et le modèle sont étroitement liés.

Motivation

L’optimisation de la vitesse et de la précision de la modélisation à grande échelle de structures de protéines est un élément clé des initiatives de la génomique structurale, en partie parce que le volume de données est, d'une part trop grand pour être traité manuellement et d'autre part parce qu'il est essentiel de fournir des modèles de qualité raisonnable aux chercheurs qui ont ces besoins mais qui ne sont pas eux-mêmes experts de la prédiction de structure protéique, par exemple les chercheurs élaborant de nouveaux médicaments.

Parce qu'il est fastidieux d’obtenir des informations sur la structure d'une protéine à partir de méthodes expérimentales telles que la cristallographie aux rayons x et la NMR protéique, la modélisation par homologie peut fournir des modèles structurels utiles pour générer rapidement des hypothèses sur la fonction de protéines et affiner des expérimentations.

La spectroscopie par résonance magnétique nucléaire des protéines (habituellement abrégée par NMR) est un domaine de la biologie structurale dans laquelle la spectroscopie RMN est utilisée pour obtenir des informations sur la structure et la dynamique de protéines, les acides nucléiques et leurs complexes.

Il y a cependant des exceptions à l'intuition que les protéines partageant une similitude des séquence d’acides aminés significative, partagent aussi une conformation 3D conformérie. Cependant, tel un réarrangement structural massif est peu probable au cours de l’évolution, surtout que la protéine est généralement sous la contrainte qu’il lui faut se replier correctement et exercer sa fonction dans la cellule. Par conséquent, la structure grossièrement repliée d’une protéine (sa «topologie») est plus conservée que sa séquence d’acides aminés et beaucoup mieux conservée que la séquence d’acides aminés d’ADN correspondante ;

Étapes de la production de modèles

La procédure de modélisation par homologie peut être décomposée en quatre étapes successives :

- la sélection de la ou des protéines modèle,

- l’alignement de la protéine cible et protéine modèle,

- la modélisation

- l’évaluation du modèle.

Les deux premières étapes sont souvent fusionnées, car les méthodes les plus courantes d’identification de modèles dépendent de la production des alignements de séquences d’acides aminés. Ces processus peuvent être effectués par itération afin d’améliorer la qualité du modèle final.

Sélection de l’alignement de la séquence d’acides aminés et du modèle

La méthode la plus simple d’identification de la protéine modèle repose sur l’alignement de séquence d’acides aminés par paires série avec l’aide de techniques de recherche de base de données tels que FASTA et BLAST. Des méthodes plus sensibles basées sur des alignements de séquences d’acides aminés multiples – dont PSI-BLAST est l’exemple le plus courant – mettent itérativement à jour leur matrice de notation de position matrice de similarité spécifique pour identifier successivement les protéines homologues connexes les plus lointaines.

Cette famille de méthodes permet d'identifier d'excellents modèles pour la séquence d’acides aminés de la protéine cible.

La méthode par enfilage de protéine, est également utilisable comme une technique de recherche pour identifier les modèles à utiliser dans les méthodes traditionnelles de modélisation par homologie. Des expériences récentes de CASP indiquent que certaines méthodes d’enfilage de protéines telles que RaptorX sont en effet plus sensibles que les méthodes basées sur la similitude des séquences d’acides aminés.

Lorsqu’une recherche BLAST est effectuée, une première approche est d’identifier les hits qui sont considérés comme suffisamment proches en évolution pour faire un modèle fiable d’homologie. D'autres facteurs peuvent faire pencher la balance dans certains cas marginaux ; par exemple, le modèle peut avoir une fonction similaire à celle de la séquence d’acides aminés recherchée, où il peut appartenir à un opéron homologue.

Souvent, plusieurs modèles candidats sont identifiés par ces approches. Bien que certaines méthodes peuvent générer des modèles hybrides avec une meilleure précision à partir de plusieurs modèles, la plupart des méthodes s’appuient sur un modèle unique. Par conséquent, choisir le meilleur modèle parmi les candidats est une étape clé. Ce choix est guidé par plusieurs facteurs, tels que la similarité des séquence d’acides aminés recherchée, du modèle et de leurs fonctions, la requête prévue et l’observation des structures secondaires du modèle.

La couverture des régions alignées est peut-être plus importante encore, la fraction de la structure de séquence d’acides aminés recherchée qui peut être prédite par le modèle et la vraisemblance du modèle qui en résulte. Ainsi, parfois plusieurs modèles d’homologie sont produits pour une séquence d’acides aminés unique, le candidat le plus probable sera choisi uniquement dans la dernière étape.

Cependant, des approches plus sophistiquées ont également été explorées. Par exemple un ensemble d’alignements par paires entre la séquence d’acides aminés cible et un seul modèle identifié est défini de manière stochastique comme un moyen d’explorer un « espace d’alignement » dans les régions de séquence d’acides aminés avec faible similitude locale.

La méthode d’« alignements profilé » génère tout d’abord un profil de séquence d’acides aminés recherché et le compare systématiquement à des profils de séquence d’acides aminés dont les structures sont résolues. On suppose que la modélisation à gros-grain inhérente à la construction de profil, réduit le bruit introduit par la dérive de séquence d’acides aminés dans des régions non essentielles.

Génération de modèle

Étant donné un modèle et un alignement, il est alors possible de générer un modèle de structure tridimensionnel de la protéine cible, qui sera représenté par un ensemble de coordonnées cartésiennes pour chaque atome dans la protéine. Trois grandes catégories de méthodes de génération de modèles ont été proposées.

Assemblage de fragment

La méthode originale de modélisation par homologie s’est appuyée sur l’assemblage d’un modèle complet à partir de fragments identifiés dans les structures apparentées. Ainsi les protéines non résolues pouvaient être modélisées en construisant d’abord un noyau et puis en le complétant par remplacement des régions variables par celles d’autres protéines appartenant à l’ensemble des structures résolus. Les implémentations actuelles de cette méthode se distinguent principalement par la façon dont elles traitent les régions qui ne sont pas conservées ou qui n’ont pas de modèle. Les régions variables sont souvent construites avec l’aide des bibliothèques de fragment.

Correspondance de Segment

La méthode par correspondance de segment divise la cible en une série de courts segments, ainsi, l’alignement de séquences d’acides aminés avec les modèles potentiels se fait sur les segments, plutôt que sur l’ensemble de la protéine. La sélection du modèle pour chaque segment est basée sur la similarité des séquences d’acides aminés, les comparaisons de coordonnées de carbone alpha et la prédiction des conflits stériques provoqués par les rayons de Van der Waals des atomes divergents entre la cible et le modèle.

Satisfaction de contraintes spatiales

La méthode de modélisation par homologie la plus courante s’inspire de calculs nécessaires à la construction d’une structure tridimensionnelle à partir de données générées par spectroscopie RMN. Un ou plusieurs alignements entre la protéine cible et la protéine modèle sont utilisés pour construire un ensemble de critères géométriques qui sont ensuite convertis en fonctions de densité de probabilité pour chaque contrainte.

Les restrictions appliquées aux coordonnées servent de base pour une procédure d’optimisation globale utilisant la minimisation d’énergie de gradient conjugué de manière itérative pour affiner les positions de tous les atomes lourds dans la protéine.

Cette méthode avait été considérablement élargie pour s’appliquer spécifiquement à la modélisation de coudes, qui peut être extrêmement difficile en raison de la grande flexibilité de coude dans les protéines en solution aqueuse.

Le logiciel le plus couramment utilisé en modélisation spatiale par contraintes est Modeleur et une base de données appelée ModBase a été établie pour des modèles fiables générés avec ce logiciel.

Modélisation de coudes

Les régions de la séquence d’acides aminés cible qui ne correspondent pas à un modèle sont modelées par la modélisation de coudes ; elles sont les plus sensibles aux grandes erreurs de modélisation et se produisent avec une fréquence plus élevée lorsque la cible et le modèle ont peu de similarité.

Les coordonnées des sections irréconciliables, qui ont été déterminées par programmes de modélisation de coudes, sont généralement beaucoup moins précises que celles obtenues par simple copie des coordonnées d’une structure connue, surtout si le coude est plus long que dix résidus.

Boucles courtes

En général, les prédictions les plus précises sont pour les boucles de moins de 8 acides aminés. Des boucles extrêmement courtes de trois résidus peuvent être déterminées à partir de la géométrie seule, à condition que les longueurs de liaison et les angles de liaison soient spécifiés. Des boucles légèrement plus longues sont souvent déterminées à partir d'une approche par de pièces de rechange, dans laquelle des boucles de longueur similaire sont prélevées dans des structures cristallines connues et adaptées à la géométrie des segments flanquants. Dans certaines méthodes, les longueurs de liaison et les angles de la région de boucle peuvent varier, afin d'obtenir un meilleur ajustement. Dans d'autres cas, les contraintes des segments flanquants peuvent être modifiées pour trouver des conformations de boucles plus «protéiniques». Il faut cependant considérer que les boucles des protéines peuvent ne pas être bien structurées et n'ont donc qu'aucune conformation précise ne peut être prédite; Des expériences de RMN indiquent que les boucles exposées aux solvants sont molles et peuvent adopter de nombreuses conformations, tandis que les conformations de boucle vues par cristallographie aux rayons X peuvent simplement refléter les interactions au sein du cristal, ou l'influence stabilisatrice de cristallisation des co-solvants.

Techniques ab Initio

Ces approches qui ne sont pas basées sur un modèle, utilisent un modèle statistique pour combler les lacunes créées par la structure de boucle inconnue. Certains de ces programmes incluent Modeller, Loopy et Rapper ; mais chacun de ces programmes approche le problème d'une manière différente. Par exemple, Loopy utilise des échantillons de paires d'angles de torsion pour générer la structure de boucle initiale, puis il révise cette structure pour maintenir une forme et une fermeture réalistes, tandis que RAPPER construit d'une extrémité de l'espace à l'autre en étendant la tige avec différents angles échantillonnés jusqu'à ce que l'écart soit fermé. Une autre méthode implique de subdiviser la boucle en deux segments puis de diviser et de transformer chaque segment jusqu'à ce que la boucle soit suffisamment petite pour être résolue. Les approches basées sur ces méthodes non-modèle sont assez précises jusqu'à douze résidus (acides aminés dans la boucle).

Il existe trois problèmes qui se posent lors de l'utilisation d'une technique non basée sur un modèle, car il existe des contraintes qui limitent les possibilités de modélisation des régions locales.

Évaluation du modèle

L’évaluation modèles par homologie sans faire de référence à la structure de la vraie cible est généralement réalisée avec deux méthodes : Par la méthode des potentiels statistiques ou par la méthode par calculs d’énergie basé sur la physique. Les deux méthodes produisent une estimation de l’énergie du ou des modèles évalués. Des critères indépendants sont nécessaires pour déterminer les seuils acceptables. Aucune des deux méthodes ne fournit une excellente exactitude structurelle, en particulier sur les types de protéines sous-représentés dans la PDB, tels que les protéines de la membrane.

Méthode des potentiels statistiques

Les méthodes des potentiels statistiques sont des méthodes empiriques basées sur les fréquences de contact entre résidus observés parmi les protéines de structure connue dans la PDB. Elles assignent un score de probabilité ou d’énergie à chaque interaction possible par paire entre les acides aminés et combinent ces scores d’interaction par paire en un score unique pour l’ensemble du modèle.

Certaines de ces méthodes peuvent également produire une évaluation des résidus qui identifie les régions mal renseignées dans le modèle, même si le modèle possède un score raisonnable au niveau global. Ces méthodes mettent l’accent sur le noyau hydrophobe et exposés aux solvants polaires d’acides aminés souvent présents dans les protéines globulaires.

Prosa et Dope sont des exemples de potentiels statistiques populaires. Les potentiels statistiques sont computationellement plus efficaces que les calculs d’énergie.

Méthode par calculs d’énergie

Les calculs basés sur l’énergie visent à capturer les interactions interatomiques qui sont physiquement responsables de la stabilité des protéines en solution, en particulier les interactions van der Waals et les interactions électrostatiques. Ces calculs sont effectués à l’aide d’un champ de force de mécanique moléculaire ; les protéines sont normalement trop grandes même pour des calculs semi-empiriques basée sur la mécanique quantique.

L’utilisation de ces méthodes repose sur l’hypothèse qu’un état natif d’une protéine est également celui de son énergie minimale. Ces méthodes utilisent habituellement la solvatation implicite, qui prévoit un rapprochement continu d’un bain de solvant pour une molécule de protéine unique sans nécessiter la représentation explicite des molécules de solvant individuels. Un champ de force construit spécifiquement pour le modèle d’évaluation est connu comme le champ de Force efficace (EFF) et repose sur des paramètres atomiques de CHARMM.

Un rapport de validation du modèle très vaste est possible en utilisant le logiciel de la Radboud Universiteit Nijmegen « What Check » ; il produit un document de nombreuses pages avec des analyses détaillées des aspects scientifiques et techniques du modèle. « What Check » est disponible sur un serveur Web ; il peut être également utilisé pour valider les structures déterminées expérimentalement des macromolécules.

Une nouvelle méthode pour le modèle d’évaluation s’appuie sur des techniques tels que les réseaux neuronaux, qui peuvent être entraînés en apprentissage automatique afin d’évaluer la structure directement ou pour établir un consensus entre les méthodes statistiques et celles axées sur l’énergie.

Méthodes de comparaison structurelle

L’évaluation de l’exactitude des modèles par homologie est simple lorsque la structure expérimentale est connue. La méthode la plus courante de la comparaison de deux structures protéiques utilise la métrique de la déviation de l'écart type pour mesurer la distance moyenne entre les atomes correspondants dans les deux structures après qu’elles ont été superposées.

Cependant, l'écart type sous-estime l’exactitude des modèles dont le noyau est essentiellement correctement modélisé, mais où certaines régions de coudes souples sont inexactes. Une méthode introduite pour l’évaluation de modélisation à CASP est le test de distance globale (GDT), il mesure le nombre total d’atomes dont la distance entre le modèle et la structure expérimentale se trouve sous une certaine distance de coupure. Les deux méthodes peuvent être utilisées pour n’importe quel sous-ensemble des atomes dans la structure, mais sont souvent appliqués aux seuls alpha carbone ou les protéines dorsales afin de minimiser le bruit créé par les états rotamériques mal modélisés.