Méthode contrainte-résistance

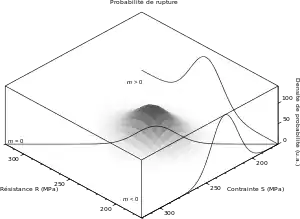

La méthode contrainte-résistance est une méthode d'essais visant à qualifier la fiabilité d'un système. C'est une approche statistique qui permet de relier la durée de vie (résistance) d'un produit aux sollicitations (contraintes) auxquelles il est soumis. Elle est adaptée aux cas où condition de résistance T ≥ t0 (durée de vie T supérieure à t0) peut s'exprimer sous la forme

- R ≥ S

ou encore

- m ≥ 0 avec m = R – S

où

- R est la résistance ;

- S est la contrainte (stress) ;

- m est la marge.

Le cas échéant, le durée de vie t0 peut être « une utilisation » ; la méthode contrainte-résistance est alors une version « probabilisée » de la notion d'état limite ultime (ELU). Si la durée de vie correspond à plusieurs cycles d'utilisation, on est dans une situation de type fatigue.

Problématique

Tout système finit par avoir une défaillance. Le terme système est très large ; dans le domaine industriel, cela concerne par exemple de l'électronique comme de la mécanique.

Cette défaillance va avoir des conséquences économiques — coût de maintenance, perte de production, destruction de bien — mais aussi potentiellement humaines — blessures, handicap, décès. Le cahier des charges prévoit en général une durée de vie du système, ainsi qu'un taux de disponibilité, c'est-à-dire le temps pendant lequel le système fonctionne réellement (donc on enlève les arrêts pour maintenance), et ce pour un niveau de performance attendu. Le concepteur de la machine doit fournir un programme de maintenance : maintenance prévisionnelle (arrêts programmés du système, changement systématique de pièces), maintenance conditionnelle (surveillance de paramètres permettant de savoir quand on doit changer une pièce).

La méthode de conception traditionnelle consiste à surdimensionner le système par un coefficient de sécurité : par exemple, si un système doit lever 1 t, on dimensionne le système pour pouvoir lever 2 t, donc avec un coefficient de sécurité de 2. On parle de méthode « déterministe » puisque les calculs ne font pas apparaître le hasard.

Cette méthode produit des systèmes sûrs mais largement surdimensionnés (« conservatifs »), donc chers et lourds.

Une méthode plus fine consiste à considérer la dispersion statistique des paramètres ; par exemple dans le cas du levage :

- dispersion des efforts, selon le vent, la brutalité des manipulations ;

- dispersion de la résistance de l'acier du câble de levage ;

- dispersion dans la fabrication des câbles.

On parle de méthode « fiabiliste », ou encore « probabiliste ».

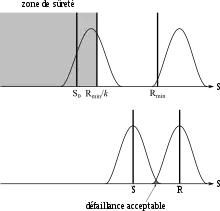

Dans notre exemple : l'acier du câble est caractérisé par sa résistance minimale garantie Rmin (typiquement 235 MPa). Le fournisseur garantit une résistance minimale ; cela signifie qu'en raison de la dispersion de sa production, il doit fournir des aciers de qualité souvent supérieure ; on a donc une courbe de dispersion (densité de probabilité) en grande partie à droite de Rmin. Si k est le coefficient de sécurité, alors la zone de sûreté (S ≤ R, m ≥ 0) est la zone à gauche de la valeur Rmin/k.

La contrainte nominale S0 est la force divisée par l'aire de la section droite du câble, σ = F/A ; la force correspond au poids de l'objet. Dans l'idéal économique, S0 devrait être exactement égal à Rmin/k ; dans la pratique, les sections de câble étant normalisées, on choisit A pour que l'on ait S0 < Rmin/k. On a ici deux sources de dispersion de la valeur :

- la force va être supérieure en raison du vent et de l'accélération au levage ;

- la section du câble va varier (aléa de production, dégradations admissibles du câble).

Cela se traduit par une contrainte réelle en général supérieure à S0. Le coefficient de sécurité garantit que l'on a Sréel < Rréel, et ce bien que l'on ait Sréel > S0 et Rréel < Rmin.

Dans une approche probabiliste, on dispose des densités de probabilité ƒS de la contrainte et ƒR de la résistance, et l'on admet un taux de défaillance α, qui est la probabilité que la contrainte dépasse la résistance

- .

Ce taux peut être pris très faible si le domaine est sensible (typiquement 10–7 soit 0,000 01 %, rappelons que l'on n'arrive jamais à 0). Cela permet de « rapprocher » les deux courbes, soit dans notre exemple ;

- choisir un matériau ayant une résistance garantie inférieure (par exemple 185 MPa), ou bien

- admettre une contrainte supérieure, c'est-à-dire :

- accepter le levage d'une charge plus importante, ou bien dans des conditions plus sévères (vent plus fort), ou bien

- prendre un câble de section plus petite.

On n'observera pas plus d'accident (ni moins, d'ailleurs), mais on aura fait des économies substantielles. Notons que si la méthode peut servir à réduire le coût de fabrication à durée de vie égale ou bien à calculer au mieux les périodes de maintenance et la durée de garantie, elle peut aussi servir à faire de l'obsolescence programmée.

Mise en œuvre de la méthode

La méthode contrainte-résistance nécessite de connaître les lois statistiques de la contrainte, ƒS, et de la résistance, ƒR. Cela impose une méthode de collection de données. Il peut s'agir d'essais ayant pour but de prouver un niveau de fiabilité en testant le plus petit nombre d'échantillons possible, sur un temps le plus court possible. Par échantillon, ou éprouvette, on entend un système sollicité en laboratoire.

Avec une approche déterministe, les coefficients de sécurité sont imposés par des normes ; ils ont été établis par l'expérience (recensement des accidents). Dans le cas d'une approche fiabiliste, il faut pouvoir prouver par des données, et donc des conceptions nouvelles par essais, que le taux de défaillance est inférieur au niveau α visé, ou encore que le niveau de fiabilité est supérieur à (1 - α). Le problème est que si un produit a une durée de vie longue, il faudra attendre longtemps avant de constater une défaillance, ce qui va à l'encontre d'un cycle de développement rapide : faut-il tester une voiture 10 ans avant de la vendre ? Sachant qu'en 10 ans la technologie aura peut-être radicalement changé.

La question est donc :

- je dois tester combien d'échantillons et pendant combien de temps pour pouvoir garantir un niveau de fiabilité donné.

Mais le traitement statistique concerne aussi les informations fournies par le service après-vente ou le service maintenance. Il faut donc être capable d'intégrer les pannes en service des systèmes chez des utilisateurs réels.

Lorsque l'on a une estimation des lois statistiques de la contrainte et de la résistance, on peut déterminer le niveau de fiabilité, par exemple avec la méthode FORM-SORM.

La méthode contrainte-résistance dans le contexte de la fiabilité en mécanique

Les méthodes de fiabilité prévisionnelle ont pour objectif de produire des estimations a priori de la fiabilité de dispositifs, appropriées aux mécanismes de défaillance susceptibles de les affecter. Ces estimations peuvent être utilisées en phase de conception pour démontrer que la fiabilité prévisionnelle est meilleure que la fiabilité allouée, ou en exploitation lorsque l'on souhaite par exemple améliorer la sûreté d'une installation ou en étendre la durée de fonctionnement.

Développées initialement pour les systèmes électroniques, ces méthodes ont été fondées à l'origine sur l'hypothèse que le taux de défaillance des composants est constant pendant leur période d'utilisation. Si cette hypothèse peut permettre de prendre en compte (avec précautions) des composants mécaniques simples, produits en grand nombre, susceptibles d'un mode de défaillance simple, elle n'est en général pas applicable aux systèmes à dominante « mécanique » pour lesquels les modes de défaillance (rupture, déformation, grippage, bruyance…) liés à la fatigue, à l'usure et au vieillissement apparaissent dès le début du cycle d'utilisation.

L'objectif de la « fiabilité en mécanique » est donc de mettre à disposition des concepteurs un ensemble de méthodes d'estimation de la fiabilité prévisionnelle juste nécessaires, prenant en compte les mécanismes réels de défaillance et adaptées à chaque cas particulier.

À l'issue des étapes « classiques » d'analyse prévisionnelle qualitative de la fiabilité (AMDEC, arbres de défaillances), trois approches de la fiabilité prévisionnelle de chaque composant sont possibles :

- Il s'agit de composants traités dans des recueils de données de type « taux de défaillance constant » relatifs à des composants similaires, utilisés sur des systèmes similaires, dans des conditions et avec un profil d'utilisation et de maintenance similaires. Il est alors possible, sous réserves de vérifier la validité des hypothèses, d'utiliser des taux de défaillance

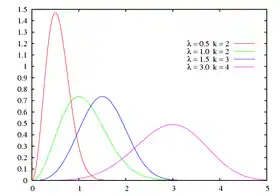

- Il s'agit de composants « standardisés » sur lesquels les fabricants disposent de données suffisantes pour fournir « sur catalogue » des méthodes de calcul de la fiabilité prévisionnelle paramétrées selon les conditions d'utilisation (spectre de charge). Les données prennent implicitement en compte les conditions de maintenance préventive des composants de référence. Ces méthodes donnent directement l'évolution du taux de défaillance et de la fiabilité du composant en fonction du temps. Les principales lois de mortalité utilisées sont la loi log-normale et la loi de Weibull. Ce type d'approche est applicable en particulier à des composants comme les roulements, ressorts, engrenages, composants électromécaniques…

- Le composant ne fait pas l'objet de standardisation, ou ses conditions d'utilisation sont spécifiques, il est alors préconisé d'appliquer des méthodes de type « contrainte-résistance » permettant de calculer la fiabilité prévisionnelle en prenant en compte les modèles d'endommagement adaptés à la physique des contraintes subies par le composant (usure, fatigue à grand nombre de cycles, fatigue oligocyclique…). L'application de ces méthodes permet alors d'enrichir les approches classiques du dimensionnement des composants mécaniques en quantifiant les risques liés à l'utilisation de « coefficients de sécurité » et en optimisant le dimensionnement en fonction des objectifs.

En résumé, la méthode Contrainte-Résistance permet, sous certaines conditions, d'évaluer la fiabilité d'une pièce mécanique soumise à des contraintes.

Cette fiabilité s'exprime par la probabilité que, sur l'ensemble de la mission, la contrainte mécanique subie en tout point de la pièce reste inférieure à la résistance de la pièce.

Points forts et limites de la méthode

Le domaine de pertinence de chaque approche de la fiabilité en mécanique est fortement dépendant :

- de la robustesse du retour d'expérience sur lequel s'appuient les données d'entrée ;

- du contexte et des objectifs de l'étude ;

- du fait des limites des méthodes (voir ci-après), une étude de fiabilité en mécanique n'a pas pour but de calculer la fiabilité d'un composant à la décimale près, mais plutôt d'effectuer dans le cas de systèmes sollicités dynamiquement une approche qui est beaucoup plus précise que l'utilisation de coefficients de sécurité, qui ne sont pertinents que dans des cas d'utilisation très spécifiques, et ne prennent pas en compte les incertitudes sur contrainte et résistance

- La « fiabilité en mécanique » ne se réduit pas à « la loi de Weibull » ou à la « méthode contrainte-résistance », le choix et la mise en œuvre des méthodes de prévision adaptées à chaque composant et à chaque contexte d'étude nécessitent une bonne connaissance des bases de la mécanique et de la fiabilité ;

- La « rigueur mathématique » des modèles et leur aptitude à « produire des décimales » ne doit pas faire oublier que la précision des estimations est dépendante :

- de l'exhaustivité des analyses qualitatives (c'est bien souvent une cause ou une combinaison de causes « oubliée » qui conduira à la défaillance),

- de la qualité des données d'entrée (il est parfois difficile de rassembler des données d'entrée robustes sur les facteurs endommageant, la distribution statistique des contraintes et des résistances),

- de l'écart entre le modèle et la réalité physique ;

- A contrario, les tables de taux de défaillance doivent être utilisées avec beaucoup de précaution en étant conscient du fait qu'elles ne représentent en général qu'une première approximation ;

- La méthode permet d'émettre des préconisations pour l'optimisation du dimensionnement, de la réalisation, de la maintenance ;

- Le calcul des contraintes (Résistance des Matériaux, éléments finis,...) et de leurs limites peut faire appel à des modèles et des méthodes de calcul mécanique affaire de spécialistes, et en constante évolution ;

- L'estimation de la fiabilité peut faire appel à des méthodes statistiques « sophistiquées » et des moyens de calcul importants.

- Même avec des données « de qualité » il faut être prudent sur l'exploitation de résultats obtenus pour de très faibles niveaux de probabilités de défaillance (exploitation des « queues » de distribution)

Identification des modes de défaillance et durée de vie

Un système peut présenter en général plusieurs modes de défaillance : différentes parties peuvent tomber en panne, et une partie donnée peut subir des pannes diverses. Pour pouvoir identifier ces modes de défaillance, il faut donc solliciter des échantillons jusqu'à la panne.

La probabilité d'apparition d'un mode de défaillance donné peut en général se décrire par une loi de Weibull. Cette loi est différente pour chaque mode de défaillance, en particulier en ce qui concerne le paramètre de forme k.

Et cette probabilité de défaillance dépend en général du niveau de contrainte S. Par « contrainte », on entend tout paramètre ayant une influence sur la durée de vie du produit : effort mécanique, vitesse de variation, température, hygrométrie, … Le niveau de contrainte détermine le paramètre d'échelle λ.

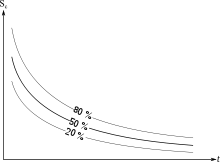

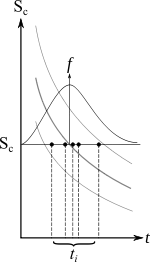

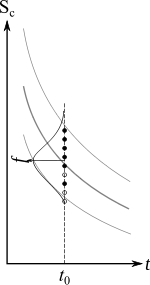

Supposons que l'on soumette n systèmes à un niveau de contrainte constant Sc. On regarde au bout de quelle durée tp un pourcentage p des systèmes ont défailli. On peut ainsi tracer un faisceau de courbes Sc(tp), qui répond à la question « quelle contrainte Sc puis-je appliquer pour que mon système ait une durée de vie t » ; on considère souvent la courbe pour laquelle la moitié des systèmes présente une défaillance, t50 %(Sc).

Le problème essentiel est que l'on dispose rarement de ces courbes. De telles courbes ont été établies pour la fatigue, les courbes de Wöhler S(N) (contrainte mécanique-nombre de cycles), ainsi que pour les guidages mécaniques (roulements, glissières). Mais un système industriel présente de nombreuses interactions qui rendent difficile l'utilisation de ces courbes élémentaires pour faire une qualification. C'est donc au concepteur ou au fabricant de faire les tests de qualification.

Essais pour déterminer la distribution de la défaillance

On est dans le cas d'un essai « ouvert » : on a une taille d'échantillon donnée n, et la loi statistique est inconnue. On fixe un niveau de contrainte Sc.

Pour obtenir les paramètres décrivant la loi de probabilité, on peut par exemple déterminer le taux cumulé de défaillance : si l'on a un échantillon de taille n, à chaque défaillance, le taux augmente de 1/n. Par exemple, la fonction de répartition d'une loi de Weibull est de la forme

ce qui donne

- .

c'est-à-dire l'équation d'une droite dans un repère adapté.

Essais censurés

Dans le cas d'essais censurés, on s'arrête lorsqu'un nombre r d'échantillons a présenté une défaillance (on a bien sûr r ≤ n). Cela revient à déterminer la durée de vie pour une contrainte donnée.

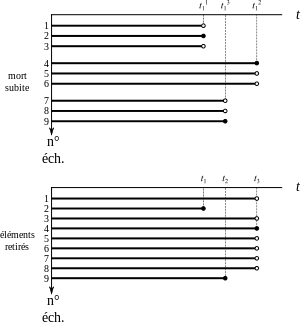

La première méthode est la méthode de la « mort subite » : on divise l'échantillon en r groupes de taille identique n' = n/r. On met en test un groupe d'échantillons, et l'on s'arrête lorsqu'un échantillon présente une défaillance. Ainsi, lorsque l'on a testé tous les groupes, on a bien r défaillances.

L'avantage de cette méthode est qu'elle ne nécessite que n' postes de travail ; par contre, la campagne d'essais a une durée moyenne r×T (T étant la durée de vie moyenne).

On obtient ainsi la durée t1i au bout de laquelle s'est produite la défaillance dans le groupe n° i (1 ≤ i ≤ r). Cela permet d'estimer la variable aléatoire T1 « durée menant à un taux de défaillance r/n », et l'on désire à partir de cela avoir une estimation de la variable aléatoire T « durée de vie du produit ». Notons que T1 représente le minimum dans un échantillon de taille n'. Si T suit une loi de Weibull de paramètres (λ, k), alors T1 suit aussi une loi de Weibull de même paramètre de forme λ ; les paramètres d'échelle sont reliés par

- k1 = (k/n' )1/λ.

La deuxième méthode est la méthode des « éléments retirés », ou de « l'incrément modifié ». Elle nécessite d'avoir n postes de travail, mais la campagne a une durée moyenne T.

On met tous les échantillons en test au même moment, et l'on s'arrête lorsque l'on a eu r défaillances. Notons que le nombre d'échantillons diminue au cours du temps. On peut par ailleurs, à chaque défaillance, arrêter les essais pour un certain nombre d'échantillons qui n'ont pas encore présenté de défaillance : comme la probabilité de défaillance augmente avec le temps, la taille de l'échantillon peut diminuer, ce qui permet de libérer des postes de travail, tout en conservant un niveau de confiance acceptable.

On a donc la durée de vie de chaque échantillon ayant présenté une défaillance, ti. C'est une réalisation de la variable aléatoire T « durée de vie du produit ». Le traitement statistique prend en compte la diminution de la taille de l'échantillon.

Le retour d'information du service après-vente rentre dans cette catégorie d'essais : le niveau de contrainte est imposé par l'utilisateur, et l'on décide à une date donnée d'analyser les statistiques de défaillance, ce qui revient à prendre les r défaillance parmi les n système en service. Le problème est rendu plus complexe par le fait que :

- il faut connaître le niveau de contrainte pour chaque utilisateur, à supposer qu'il soit constant…

- il faut connaître la durée d'utilisation du système ; par exemple, après un an de service, toutes les voitures n'ont pas parcouru le même nombre de kilomètres.

Essais tronqués

Dans le cas d'essais tronqués, on effectue des essais de durée t0 fixée, mais pour différentes contraintes S. Cela revient à rechercher la contrainte admissible pour une durée de vie programmée. On parle également d'essais de fatigue ou d'endurance.

Il existe plusieurs méthodes pour essayer de faire le moins d'essais possibles. La première est la méthode « de l'escalier ». On part d'une contrainte S0 que l'on estime proche de la contrainte de défaillance. Si, au bout de la durée t0, le système a présenté une défaillance, alors on diminue la contrainte d'un pas p pour l'essai suivant ; à l'inverse, si le système a résisté, on augmente la contrainte de p. On choisit en général p entre 1/20 et 1/10 de S0.

En raison du caractère aléatoire de la défaillance, la contrainte utilisée d'un essai à l'autre va « osciller » autour de la moyenne de la variable aléatoire. À la fin de la campagne, on a fait n essais et obtenu r défaillances. Pour une contrainte Si = S0 + i×p, on aura fait ni essais et obtenu ri défaillances. Cela permet d'estimer les paramètres de la variable aléatoire « contrainte admissible. »

Mais cette méthode ne permet de réaliser qu'un seul essai à la fois et ne présente pas de raffinement du pas p. Pour permettre de raffiner le pas, c'est-à-dire avoir un pas plus petit autour de la valeur que l'on veut déterminer, on peut utiliser la méthode itérative : pour passer de l'étape i à l'étape i + 1, on pondère le pas par le taux fi d'éléments défaillants obtenus à l'étape précédente :

- p0 étant le pas initial (déterminé comme précédemment),

- le terme α étant le taux de rupture que l'on veut tester, par exemple α = 0,5 si l'on veut la médiane de rupture,

- a étant un coefficient qui atténue la décroissance du pas en 1/i, et vaut environ 2.

On peut effectuer plusieurs tests simultanés à l'étape i, mais par contre on ne peut pas estimer l'écart type de la variable aléatoire.

Une autre méthode consiste à prendre des lots de n systèmes (3 ou 4), et de trouver la contrainte pour laquelle aucun de ces systèmes ne présente de défaillance au bout du temps t0. On commence à une contrainte S0, et on arrête l'essai dès qu'un système présente une défaillance (le niveau de contrainte initial est choisi suffisamment grand pour que cela arrive avant t0). L'essai suivant se fait à une contrainte inférieure d'un pas p constant. Les premières étapes sont rapides, puisque les contraintes sont élevées ; par contre, les dernières étapes sont longues puisque l'on s'approche au fur et à mesure de la durée t0.

On peut à l'inverse progresser en aggravant : on part d'une faible contrainte, pour laquelle on n'a aucune défaillance avant t0, et on l'augmente. Cette stratégie est plus longue, et le faible nombre de défaillance donne peu d'information, que ce soit qualitatives ou statistiques.

Autres stratégies d'essais

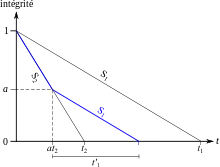

La méthode des dommages cumulés consiste à considérer que le dommage se forme au fur et à mesure, et qu'il est proportionnel au temps de sollicitation (loi linéaire) : si un système a l'état neuf a une intégrité cotée à 1, celle-ci décroît linéairement jusqu'à 0 (défaillance) pour une contrainte donnée. On considère deux niveaux de contrainte S1 et S2, avec S2 > S1 et un écart assez important.

On effectue un premier test à la contrainte S2, la défaillance se produit à l'instant t2. On effectue alors un second test en deux étapes :

- une première étape à la contrainte S2 pendant un temps a·t2 (a < 1) ; l'intégrité de l'éprouvette est vaut alors 1 – a ;

- puis une deuxième étape à la contrainte S1 ; la rupture se fait après un temps t'1.

Si l'essai se faisait entièrement à la contrainte S1, la défaillance aurait lieu à l'instant t1 = t'1/(1 – a). On a ainsi un essai accéléré, à condition que t2 + t'1 < t1 (d'où l'intérêt d'avoir S2 très supérieur à S1).

La méthode des essais mixtes consiste à profiter du fort taux de défaillance à contrainte élevées : contrairement à la méthode des n éprouvettes non cassées ou des essais censurés, on continue les essais à contraintes élevées jusqu'à défaillance de plusieurs systèmes.

Essais pour démontrer un objectif

On se fixe un objectif de fiabilité (1 – α) au bout d'un temps t donné, et il s'agit d'établir la campagne d'essais.

La manière la plus rapide consiste à vérifier que l'on n'a aucune défaillance sur le lot d'échantillon : la durée d'essais est t, ou moins si l'on effectue des tests accélérés. La question est donc :

- Combien d'échantillon dois-je tester, et pendant combien de temps ?

Cette méthode d'essais sans défaillance présente toutefois un problème : elle ne permet pas de constater les modes de défaillance, donc ne donne aucune indication sur la maintenance et la prévision des défaillances.

Banc d'essais avant livraison

Un certain nombre de problèmes surviennent de manière précoce en raison de problèmes de fabrication. On peut détecter ces problèmes en soumettant les systèmes à des bancs d'essai avant de les livrer. Le problème consiste à appliquer une contrainte suffisante pour faire apparaître un défaut dans un délai raisonnable, mais pas trop importante pour ne pas fragiliser un système qui serait initialement exempt de défaut.

Essais accélérés

On peut dans la plupart des cas accélérer matériellement les essais. Cela implique en général de travailler avec un seul composant du système, voire sur une éprouvette prélevée sur une pièce ; ou tout du moins de travailler avec un sous-ensemble comprenant peu de composants.

La première idée consiste à augmenter la contrainte, tout en s'assurant que l'on ne change pas le mode de défaillance. Le problème est alors d'estimer le facteur d'accélération.

Lorsque le système est soumis à des sollicitations cycliques (fatigue), on peut faire des cycles plus rapides. Cela augmente les accélérations subies (la vitesse de variation des sollicitations fluctue plus rapidement), il faut s'assurer que ce phénomène ne provoque pas de changement de mode de défaillance. Il faut également un système d'essais capable d'effectuer ces cycles.

Notons également que la sollicitation a souvent un caractère aléatoire important. En laboratoire, on s'attache à utiliser une loi de chargement simple, sinusoïdal. Il faut utiliser une sinusoïde donnant un dommage équivalent au chargement réel ; on utilise par exemple la méthode du comptage rainflow.

On peut également simplifier les sollicitations : plutôt que de reproduire les sollicitations identiques à la réalité, on applique des sollicitations simplistes mais provoquant un dommage équivalent. Le problème principal est d'estimer l'équivalence des dommages. On peut pour cela avoir recours à un calcul par éléments finis.

Bibliographie

- Fiches pédagogiques de l'Institut de Maîtrise des Risques : Fiabilité Prévisionnelle en Mécanique, Fiabilité en Mécanique – la méthode Contrainte-Résistance

- CAZAUX, POMEY, RABBE, JANSSEN, La fatigue des métaux, éd. Dunod, 5e édition, 1969

- C. MARCOVICI et J. C. LIGERON, Utilisation des Techniques de Fiabilité en Mécanique, éd. Lavoisier, 1974

- J. C. LIGERON, La Fiabilité en Mécanique, éd. Desforges, 1979

- Maitriser l'usure et le frottement, Ministère de l'industrie, Programme national d'innovation, 1980

- BARTHELEMY, Notions pratiques de mécanique de la rupture, éd. Eyrolles, 1990

- C. BATHIAS, J. P. BAILON, La Fatigue des Matériaux et des Structures, éd. Hermès, 1997

- T. R. MOSS, The Reliability Data Handbook, ed. Professional Engineering Publishing, 2005

- SHIGLEY, Mechanical Engineering Design, ed. Mc Graw Hill, 8th edition, 2006

- J. C. LIGERON, Cours de fiabilité en mécanique – Groupe de travail IMdR M2OS, mise à disposition 2009

- B. HAUGEN, Probabilitic Approach to Design, éd. Wiley and Sons, 1980

- O. DITLEVSEN, H. O. MADSEN, Structural Reliability Methods, éd. Wiley and Sons, 1996

- N. RECHO, Rupture des structures par fissuration, éd. Hermès, 1995

- H. PROCACIA – P. MORILHAT, Fiabilité des structures des installations industrielles, éd. Eyrolles, 1996

- A. LANNOY, Lifetime management of structures, ESReDA DNV, 2004

- M. LEMAIRE et al., Fiabilité des structures : couplage mécano-fiabiliste statique, éd. Hermes, 2005

- J. BAROTH et al., Fiabilité des ouvrages, sûreté, sécurité, variabilité, maintenance, éd. Eyrolles, 2011