Biais algorithmique

Un biais algorithmique est le fait que le résultat d'un algorithme d'apprentissage ne soit pas neutre, loyal ou équitable.

Le biais algorithmique peut se produire lorsque les données utilisées pour entraîner un algorithme d'apprentissage automatique reflètent les valeurs implicites des humains impliqués dans la collecte, la sélection, ou l'utilisation de ces données[1]. Les biais algorithmiques ont été identifiés et critiqués pour leur impact sur les résultats des moteurs de recherche[2], les services de réseautage social[3], le respect de la vie privée[4], et le profilage racial[5]. Dans les résultats de recherche, ce biais peut créer des résultats reflétant des biais racistes, sexistes ou d'autres biais sociaux ou culturels, malgré la neutralité supposée des données[6]. Un exemple concret est celui des interprètes en ligne qui traduisent systématiquement le terme anglais "nurse" (neutre) en "infirmière" (féminin) et le terme "doctor" (neutre) en "docteur" (masculin). L'étude des biais algorithmiques s'intéresse particulièrement aux algorithmes qui reflètent une discrimination « systématique et injuste »[7].

Le biais algorithmique n'est pas nécessairement une volonté délibérée des concepteurs de l'algorithme de tromper les utilisateurs. Il est d'autant plus important pour ceux-ci d'en avoir conscience que l'usage d'un algorithme biaisé que l'on suppose objectif peut fortement influencer leurs opinions. Cette problématique pose la question du manque de rétrocontrôle des concepteurs d'algorithmes sur leur création déjà soulevée par les ingénieurs des grandes plateformes de l'Internet[8].

Définitions

Un algorithme est biaisé lorsque son résultat n'est pas neutre, loyal ou équitable. Cette définition repose donc sur trois notions : la neutralité, la loyauté et l'équité. Les biais algorithmiques peuvent conduire à des situations de discrimination[9].

Équité algorithmique

Pour éviter que les algorithmes soient biaisés, certaines recherches comme Pedreshi 2008 visent à développer des algorithmes qui respectent des principes d'équité[9] - [10].

Cette approche suppose de définir l'équité. Corbett-Davies et Goel 2018 distinguent trois définitions[11] :

- l'anti-classification consiste à ne pas prendre en compte les variables susceptibles de discriminer (par exemple le genre ou la race)

- la parité de classification consiste à faire en sorte que la performance du modèle soit la même entre les différents groupes

- la calibration consiste à faire en sorte que les résultats conditionnellement au risque estimé soient indépendants des différents groupes.

Hamilton (2016) distingue aussi l'équité individuelle et l'équité de groupe. L'équité individuelle garantit que les individus aux caractéristiques similaires soient traitées de la même manière tandis que l'équité de groupe traite les personnes des différents groupes de manière différente de manière à obtenir une égalité de résultats[12].

Origines

Les biais de l'algorithme peuvent résulter des biais cognitifs du programmeur de l'algorithme, des biais statistiques liées notamment aux données d'apprentissage ou encore des biais économiques[9].

Biais des programmeurs

Les programmeurs qui développent des algorithmes peuvent être sujets à de nombreux biais cognitifs. Parmi ces biais, le biais du mouton de Panurge consiste à utiliser une modélisation populaire sans s'assurer de sa pertinence dans un contexte donné. Le biais de confirmation consiste à favoriser sa vision du monde sans prendre en compte les données qui ne vont pas dans son sens[9].

Les data scientists qui programment les algorithmes ne sont pas représentatifs de la population en général. Une étude de l'institut AI Now de 2018 souligne que seuls 15% du personnel de recherche en intelligence artificielle chez Facebook et 10% chez Google sont des femmes[13] - [14].

La surreprésentation des hommes blancs parmi les data scientists et la sous représentation des minorités peut conduire les data scientists à ne pas assez prendre en compte les biais et les discriminations potentiels. C'est ce que D'Ignazio et Klein 2020 appellent le "risque de privilège" (privilege hazard)[14].

Biais statistiques

Les biais statistiques peuvent provenir des données contenues en entrée de l'algorithme ou de l'algorithme lui même[9].

En 2015, un algorithme d'évaluation de curriculum vitæ développé par Amazon a été arrêté quand on s'est aperçu qu'il discriminant fortement les CV feminins[9] - [15].

Les biais peuvent aussi venir de la méthode statistique par exemple le biais de variable omise, le biais de sélection ou le biais d'endogénéité[9].

Biais économiques

Les biais économiques sont liés aux incitations économiques des acteurs[9].

Par exemple, Lambrecht et Tucker 2017 ont montré qu'il était plus rentable de cibler les annonces de publicité pour des emplois dans la technologie vers des hommes que vers des femmes[16] - [9].

Biais algorithmiques par domaine d'application

Plongements lexicaux

Les modèles de word embeddings (plongements lexicaux) peuvent reproduire les biais psychologiques humains.

Caliskan, Bryson et Narayanan 2017 étudient le modèle de plongement vectoriel GloVe (en) et montrent que l'on retrouve des associations implicites entre des mots porteuses de préjugés. Ils proposent une méthode de mesure des préjugés inspirée du test d'association implicite[17].

Reconnaissance faciale

Selon Buolamwini et Gebru 2018, les femmes sont moins facilement reconnues par les logiciels de reconnaissance faciale d'IBM, Microsoft et Face ++. Sur 1270 portraits officiels de personnalités politiques qui leur ont été soumis, Face ++ a vu juste pour 99,3% des hommes, mais seulement 78,7% des femmes. Ainsi, 95,9% des erreurs de l'entreprise concernaient des femmes[18] - [19].

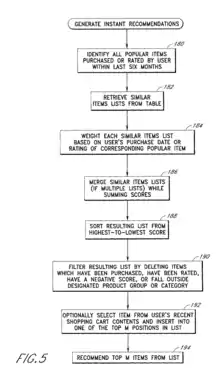

Algorithmes de recommandation

Les algorithmes de recommandation peuvent conduire à des résultats biaisés vers certains contenus.

Par exemple, les travaux de rétro-ingénierie sur l'algorithme de recommandation de YouTube mené par Guillaume Chaslot et l'association Algotransparency montrent que l'algorithme a tendance à favoriser les contenus à caractère complotistes[20].

Agents conversationnels

En 2016, l'agent conversationnel Tay développé par Microsoft et déployé sur Twitter a du être retiré après 24 heures à la suite de la tenue de propos à caractère raciste[21].

Justice prédictive

Dans certains états américains, la justice des libertés et de la détention appuie ses décisions de libération anticipée des détenus, sur des algorithmes d'évaluation du risque ; on appelle cela la justice prédictive. En 2016, une enquête de l'ONG ProPublica a mis en évidence que l'algorithme de la société Northpointe (en), bien que ses concepteurs affirment ne pas prendre directement en compte la race, avait un biais raciste[22] - [23].

Lutte contre le biais algorithmique

Il existe plusieurs possibilités pour lutter contre le biais algorithmique. Selon TechCrunch il faudrait créer des bases de données partagées et règlementées qui empêcheraient les individus de manipuler les données. En effet, en admettant que l'intelligence coïncide avec l'absence de préjugés, les algorithmes ne sont pas encore assez intelligents, donc exempts de préjugés, pour se corriger eux-mêmes ; en attendant qu'ils en soient capables il faut donc que des humains, conscients de ce qu'est un préjugé, les contrôlent afin d'éviter qu'ils n'augmentent les orientations gauchies résultant des données biaisées à travers lesquelles ils apprennent[24].

L’une des principales difficultés de la lutte contre le biais algorithmique est l’opacité du fonctionnement des algorithmes[25]. Cette opacité peut avoir quatre origines[26] ; le secret intentionnellement mis en place par les entreprises qui veulent protéger leur propriété intellectuelle, l'analphabétisation des utilisateurs et des chercheurs, mais aussi le fait que avec leur évolution au cours du temps certains algorithmes peuvent devenir illisible du fait de leur complexité et enfin certains algorithmes, notamment ceux des grands services en lignes, sont juste trop grands pour être étudiés[27]. Si certains chercheurs ont essayé de développer des méthodes pour améliorer la transparence[28] d’autres, comme Shoshana Zuboff et Ruha Benjamin affirment que les algorithmes ne peuvent pas être approchés comme des objets isolés mais plutôt comme faisant partie de grand assemblage culturel et socio-technique[29]

Audit des algorithmes et rétro ingénierie

Pour documenter les biais algorithmiques, il faut pouvoir les auditer. Pour cela, Angwin et al. 2016 ont collecté des données et développé leur propre modèle pour être en mesure de mettre en évidence, le biais de l'algorithme d'évaluation des risques de récidive[23].

Théorie critique et approches éthnographiques

D'après la sociologue Angèle Christin, il existe, avec les audits, deux autres façons d’aborder le problème du biais algorithme[30]. La première est l’approche historique et culturelle. Elle consiste en une reconsidération des évènements de biais algorithmique dans des séquences plus longues en s’appuyant sur la sociologie critique. Les algorithmes reproduiraient des structures préexistentes de discrimination[31], surveillance[32] et de marchandisation[33]. Le seconde est l’approche ethnographique. Elle permet d’un coté de déterminer quelles forces structurelles permettent l’émergence de biais et de l’autre coté, considérer comment les algorithmes sont influencés par leurs usages quotidiens. Angèle Christin propose trois méthodes dans le cadre de cette approche pour étudier les algorithmes. “Algorithmic refraction” consiste en l’examen des reconfigurations qui ont lieu pendant l’usage des algorithmes et leur interaction avec le public et les institutions. “Algorithmic comparaison” désigne l’analyse de différents usages d’un même algorithme dans différents domaines pour comprendre l’émergence de biais dans les différences d’applications et de fonctionnement. Finalement, “algorithmic triangulation” repose sur l’usage d’algorithmes secondaires pour recueillir des données sur l’algorithme étudié.

Régulations

États-Unis

Les États-Unis n'ont pas de législation d'ensemble qui régule les biais algorithmiques. Le traitement de cette question peut se faire à l'échelle fédérale ou à l'échelle d'un état, et varie selon les secteurs, selon l'utilisation qui en est faite et selon l'industrie ou l'administration concernée. En 2017, la ville de New York a voté une loi instituant une commission contrôlant l'utilisation des algorithmes dans la ville[34].

Critiques

Dans une tribune publiée sur le site de la revue Data & Society, la chercheuse Kinjal Dave critique l'usage du terme biais pour désigner les préjudices des algorithmes. Selon elle, le terme de biais issu de la psychologie sociale renvoie à une imperfection de l'individu alors que les algorithmes constitueraient selon elle des forces institutionnelles[35].

D'Ignazio et Klein 2020 reprennent aussi cette critique. Pour elles, parler de biais algorithmique et laisser croire que l'on pourrait corriger ces biais relèverait de la diversion. Plutôt que de parler de biais, elles préfèrent parler d'oppression[23].

Bibliographie

- Michael Rovatsos, Brent Mittelstadt et Ansgar Koene, Landscape summary: bias in algorithmic decision-making, Centre for Data Ethics and Innovation (en), pdf, 2019

- Algorithme, contrôle des biais S. V. P., rapport de l'Institut Montaigne, Mars 2020, lire en ligne

Filmographie

- 2020 : Coded bias réalisé par Shalini Kantayya[36]

Notes et références

- (en) Helen Nissenbaum, « How computer systems embody values », Computer, vol. 34, no 3, , p. 120–119 (DOI 10.1109/2.910905, lire en ligne, consulté le )

- (en) Lucas Introna et Helen Nissenbaum, « Defining the Web: the politics of search engines », Computer, vol. 33, no 1, , p. 54–62 (DOI 10.1109/2.816269, lire en ligne, consulté le )

- (en) Kate Crawford, « Can an Algorithm be Agonistic? Ten Scenes from Life in Calculated Publics », Science, Technology, & Human Values, vol. 41, no 1, , p. 77–92 (DOI 10.1177/0162243915589635)

- (en) Zeynep Tufekci, « Algorithmic Harms beyond Facebook and Google: Emergent Challenges of Computational Agency », Colorado Technology Law Journal Symposium Essays, vol. 13, , p. 203–216 (lire en ligne, consulté le )

- (en) Lisa Nakamura, The new media of surveillance, Londres, Routledge, , 149–162 p. (ISBN 978-0-415-56812-8)

- (en) Laura Sydell, « Can Computers Be Racist? The Human-Like Bias Of Algorithms », sur NPR.org, National Public Radio / All Things Considered (consulté le )

- (en) Batya Friedman et Helen Nissenbaum, « Bias in Computer Systems », ACM Transactions on Information Systems, vol. 14, no 3, , p. 330–347 (lire en ligne, consulté le )

- (en) Paul Lewis, « ‘Our minds can be hijacked’: the tech insiders who fear a smartphone dystopia », Daily,

- Patrice Bertail, David Bounie, Stephan Clémençon et Patrick Waelbroeck, « Algorithmes : biais, discrimination et équité », sur https://www.telecom-paris.fr (consulté le ).

- (en) Pedreshi, « Discrimination-aware data mining », Proceedings of the 14th ACM SIGKDD international conference on Knowledge discovery and data mining, (DOI 10.1145/1401890.1401959, lire en ligne, consulté le )

- (en) Sam Corbett-Davies et Sharad Goel, « The Measure and Mismeasure of Fairness: A Critical Review of Fair Machine Learning », Arxiv.org, (lire en ligne).

- Evan Hamilton, Benchmarking Four Approaches to Fairness-Aware Machine Learning, Haverford College Computer Science, 2016

- Sarah West Myers, Meredith Whittaker, and Kate Crawford. “Discriminating Systems: Gender, Race and Power in AI,” AI Now Institute, 2019, https://ainowinstitute.org/discriminatingsystems.pdf.

- (en) Catherine D'Ignazio et Lauren F. Klein, « 1. The Power Chapter », dans Data Feminism, MIT Press, (lire en ligne).

- (en) Jeffrey Dastin, « Amazon scraps secret AI recruiting tool that showed bias against women », sur Reuters.com, (consulté le ).

- (en) Anja Lambrecht et Catherine Tucker, « Algorithmic discrimination ? : apparent algorithmic bias in the serving of stem ads », Unpublished manuscript, Massachusetts Institute of Technology,

- (en) Aylin Caliskan, Joanna J. Bryson et Arvind Narayanan, « Semantics derived automatically from language corpora contain human-like biases », Science, (DOI 10.1126/science.aal4230, lire en ligne).

- (en) Joy Buolamwini et Timnit Gebru, « Gender Shades: Intersectional Accuracy Disparities inCommercial Gender Classification – MIT Media Lab », Proceedings of Machine Learning Research, (lire en ligne)

- (en) « Gender Shades », sur gendershades.org (consulté le ).

- (en) Paul Lewis et Erin McCormick, « How an ex-YouTube insider investigated its secret algorithm », The Guardian, (lire en ligne).

- (en) James Vincent, « Twitter taught Microsoft’s friendly AI chatbot to be a racist asshole in less than a day », The Verge, (lire en ligne).

- (en) Julia Angwin, Jeff Larson, Surya Mattu et Lauren Kirchner, « Machine Bias », ProPublica, (lire en ligne)

- (en) Catherine D'Ignazio et Lauren F. Klein, « 2. Collect, Analyze, Imagine, Teach », dans Data Feminism, MIT Press, (lire en ligne)

- « Comment lutter contre les biais algorithmiques ? », sur Microsoft RSLN, (consulté le )

- Frank Pasquale, The Black Box Society, Harvard University Press, (ISBN 978-0-674-73606-1, lire en ligne)

- Jenna Burrell, « How the machine ‘thinks’: Understanding opacity in machine learning algorithms », Big Data & Society, vol. 3, no 1, , p. 205395171562251 (ISSN 2053-9517 et 2053-9517, DOI 10.1177/2053951715622512, lire en ligne, consulté le )

- (en-US) « Google Is 2 Billion Lines of Code—And It's All in One Place », Wired, (ISSN 1059-1028, lire en ligne, consulté le )

- Diakopoulos, N et Friedler, S, « How to hold algorithms accountable », MIT Technology Review,

- Nick Seaver, « Algorithms as culture: Some tactics for the ethnography of algorithmic systems », Big Data & Society, vol. 4, no 2, , p. 205395171773810 (ISSN 2053-9517 et 2053-9517, DOI 10.1177/2053951717738104, lire en ligne, consulté le )

- (en) Angèle Christin, « The ethnographer and the algorithm: beyond the black box », Theory and Society, vol. 49, nos 5-6, , p. 897–918 (ISSN 0304-2421 et 1573-7853, DOI 10.1007/s11186-020-09411-3, lire en ligne, consulté le )

- (en-US) Ruha Benjamin, Race after technology : abolitionist tools for the New Jim Code, (ISBN 978-1-5095-2640-6, 1-5095-2640-4 et 978-1-5095-2639-0, OCLC 1078415817, lire en ligne)

- 祖博夫 (Zuboff, Shoshana), 1951- 文字作者, 監控資本主義時代 = The age of surveillance capitalism : the fight for a human future at the new frontier of power (ISBN 978-957-13-8116-9, 957-13-8116-0 et 978-957-13-8117-6, OCLC 1199122574, lire en ligne)

- David Beer, The Data Gaze: Capitalism, Power and Perception, SAGE Publications Ltd, (ISBN 978-1-5264-3692-4 et 978-1-5264-8534-2, lire en ligne)

- (en) Julia Powles, « New York City’s Bold, Flawed Attempt to Make Algorithms Accountable », The New Yorker, (ISSN 0028-792X, lire en ligne, consulté le )

- (en) Kinjal Dave, « Systemic Algorithmic Harms », Data & Society, (lire en ligne).

- (en) « Filmmaker — CODED BIAS », sur CODED BIAS (consulté le ).