Distance statistique

En mathématiques, et plus précisément en théorie des probabilités et en statistique, la notion de distance statistique sert à mesurer l'écart entre deux lois de probabilité. Les distances statistiques sont notamment utilisées en théorie de l'information, en statistique, en apprentissage automatique, et en cryptologie.

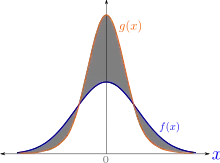

Lorsqu'aucune précision n'est donnée, la « distance statistique » entre deux lois fait généralement référence à la distance en variation totale.

Il existe cependant d'autres notions de distance statistique, plus spécialisées, qui ne sont pas nécessairement équivalentes à la distance en variation totale. Comme il ne s'agit bien souvent pas de distances, au sens des espaces métriques, le terme de divergence est parfois utilisé.

Familles de divergences

Soit P et Q des lois de probabilité, définies sur un espace , avec P absolument continue par rapport à Q. Pour toute fonction convexe f telle que f(1) = 0, on définit la « f-divergence[1] - [2] - [3] » de P par rapport à Q par :

Les choix possibles de la fonction f permettent d'obtenir plusieurs constructions classiques[4] - [5] :

- la distance en variation totale correspond au choix .

- la divergence de Kullback-Leibler correspond au choix [Note 1].

- la distance de Hellinger correspond au choix [6].

Une autre construction est la « α-divergence[7] - [Note 2] » qui est plus adaptée aux lois discrètes, et est définie pour tout par

Ici encore des choix particuliers de permettent d'obtenir des mesures de distance classiques :

- la distance de Bhattacharyya correspond (à un facteur multiplicatif près) au choix [8] - [9].

- la divergence de Kullback-Leibler correspond au choix .

Il existe encore d'autres familles, notamment les β- et γ-divergences[10] et les divergences de Bregman, qui recoupent en partie les deux familles discutées ci-dessus.

Autres constructions

D'autres distances statistiques n'appartiennent pas aux familles discutées ci-dessus, notamment :

- la distance de Kolmogorov-Smirnov ;

- la distance de Wasserstein ;

- la distance de Lévy-Prokhorov ;

- la distance de Mahalanobis ;

- la distance de Łukaszyk-Karmowski;

- la distance d'Itakura-Saito.

Notes et références

Notes

- La « divergence inverse » de Kullback-Leibler est obtenue en prenant .

- Parfois appelée « divergence de Rényi » du fait de sa proximité avec l'entropie de Rényi.

Références

- (de) Imre Czizár, « Eine informationstheoretische Ungleichung und ihre Anwendung auf den Beweis der Ergodizität von Markoffschen Ketten », Publ. Math. Inst. Hungar. Acad. Sci., , p. 85–108

- (en) Tetsuzo Morimoto, « Markov Processes and the H-Theorem », Journal of the Physical Society of Japan, vol. 18, no 3, , p. 328–331 (ISSN 0031-9015 et 1347-4073, DOI 10.1143/jpsj.18.328, lire en ligne, consulté le )

- (en) S. M. Ali et S. D. Silvey, « A General Class of Coefficients of Divergence of One Distribution from Another », Journal of the Royal Statistical Society. Series B (Methodological), vol. 28, no 1, , p. 131–142 (lire en ligne, consulté le )

- (en) F. Liese et I. Vajda, « On Divergences and Informations in Statistics and Information Theory », IEEE Transactions on Information Theory, vol. 52, no 10, , p. 4394–4412 (ISSN 0018-9448, DOI 10.1109/tit.2006.881731, lire en ligne, consulté le )

- (en) Yihong Wu, « ECE598YW: Information-theoretic methods in high-dimensional statistics », sur www.stat.yale.edu, University of Illinois, (consulté le )

- (en) Vaart, A. W. van der., Asymptotic statistics, Cambridge University Press, (ISBN 0-521-49603-9, 9780521496032 et 0521784506, OCLC 38738910, lire en ligne)

- (en) Amari, Shunichi., Differential-Geometrical Methods in Statistics, Springer New York, , 294 p. (ISBN 978-1-4612-5056-2 et 1461250560, OCLC 840279903, lire en ligne)

- (en) Frank Nielsen et Sylvain Boltz, « The Burbea-Rao and Bhattacharyya Centroids », IEEE Transactions on Information Theory, vol. 57, no 8, , p. 5455–5466 (ISSN 0018-9448 et 1557-9654, DOI 10.1109/tit.2011.2159046, lire en ligne, consulté le )

- (en) T. Kailath, « The Divergence and Bhattacharyya Distance Measures in Signal Selection », IEEE Transactions on Communications, vol. 15, no 1, , p. 52–60 (ISSN 0096-2244, DOI 10.1109/tcom.1967.1089532, lire en ligne, consulté le )

- (en) Andrzej Cichocki, Shun-ichi Amari, Andrzej Cichocki et Shun-ichi Amari, « Families of Alpha- Beta- and Gamma- Divergences: Flexible and Robust Measures of Similarities », Entropy, vol. 12, no 6, , p. 1532–1568 (DOI 10.3390/e12061532, lire en ligne, consulté le )