Classement international des universités

Un classement académique international sélectionne des institutions universitaires selon un nombre restreint d’indicateurs quantitatifs pour établir une hiérarchie selon le modèle d’une ligue des champions. Ils soulèvent des calculs sophistiqués pour tenir compte d’une réalité complexe et diversifiée.

Il y a deux types de classements :

- les classements de réputation fondés sur des critères subjectifs ;

- les classements de performance où l’on compte les résultats scientifiques obtenus par les universités (publications, diplômes, prix, etc.)

Généralement, les classements pondèrent ces critères, penchant tantôt plutôt du côté de la réputation, tantôt plutôt du côté de la performance. Ces différences de critères produisent des classements hétéroclites et donnent ainsi lieu à des critiques[1] - [2]. Les universités cherchent à s'ajuster aux classements[3].

Classements

Classement de Shanghai

Le classement de Shanghai compare 1 000 institutions d'enseignement supérieur sur la pondération de six indicateurs, principalement liés à la recherche : nombre de prix Nobel et médailles Fields parmi les élèves, parmi les professeurs, nombre de citations de chercheurs, nombre d'articles publiés dans Science et Nature, nombre d'articles dans Science Citation Index et Social Sciences Citation Index. La note obtenue est divisée par le nombre de chercheurs. La méthode de calcul favorise les établissements de grande taille.

Times Higher Education World University Rankings

Le journal britannique The Times publie depuis 2004 le Times Higher Education World University Rankings dans le mensuel dédié Times Higher Education. Les critères s'intéressent à l'enseignement et la recheche et mêlent des données objectives (notamment bibliométriques) et des éléments subjectifs liés à la réputation de l'établissement.

En 2009, Times Higher Education a annoncé la fin de sa collaboration avec Quacquarelli Symonds et la signature d'un accord avec Thomson Reuters. Quacquarelli Symonds réalise alors le QS World University Rankings, son propre classement.

Classement QS

Le classement mondial des universités QS est un classement annuel des universités publié par Quacquarelli Symonds (en) depuis 2011 à la suite de sa rupture avec le Times. Il utilise des indicateurs similaires à celui du Times.

Classement de Leiden

Le Centre d'étude des sciences et technologies (CWTS) de l'université de Leyde publie chaque année une série de classements issus d'indicateurs bibliométriques.

Les indicateurs concernent l'impact scientifique, la collaboration, le Libre accès et la parité. Les données distinguent cinq domaines scientifiques. Le classement se fonde sur la répercussion des publications.

Center for World University Rankings

Le Center for World University Rankings (CWUR) est né en 2012 en Arabie saoudite. Depuis 2016 il est édité aux Émirats arabes unis[4].

Les critères sont liés à la qualité de vie et à la performance de recherche[5].

Round university ranking

Le Global University Ranking publie un classement sur 800 universités depuis 2010, en Russie[6]. Il utilise l'enseignement (40 %), la recherche (40 %), le caractère international (10 %) et le budget (10 %).

Mines ParisTech

Depuis 2007, Mines ParisTech publie son classement international professionnel des établissements d'enseignement supérieur avec pour seul critère le nombre d'anciens étudiants figurant parmi les dirigeants exécutifs des 500 plus grandes entreprises mondiales[7].

Critiques

Le rapport du sénateur Joël Bourdin[8], publié en 2008, distingue des critiques sur la légitimité de la mesure et sur la méthode.

Légitimité

Les classements internationaux (rankings) comparent souvent des institutions difficilement comparables.

Ainsi, ces classements mettent sur un même pied des universités généralistes, des grandes écoles, ou encore Harvard, alors que cette dernière dispose d’un budget annuel de 3 milliards de dollars pour vingt mille étudiants.

Les rankings agrègent des indicateurs difficilement comparables.

Le choix d’indicateurs pour chacune des missions de l’université (enseignement, recherche, services à la cité, …) et leur agrégation pour obtenir un score unique conduit généralement à « additionner des pommes et des poires ». Pour prendre un exemple, le nombre d’articles publiés dans des revues prestigieuses a probablement moins d’importance que le taux d’encadrement des étudiants si vous cherchez une université où étudier, mais elle en aura plus si vous êtes une entreprise désireuse d'entamer un partenariat de recherche. Et l’addition entre ce nombre d’articles et le taux d’encadrement n’a pas grande signification.

Cela explique les grandes variations que l’on peut observer, pour la même université, d’un classement à l’autre et même d’une année à l’autre dans le même classement.

Par construction, les rankings privilégient le monde anglophone et les grandes universités spécialisées telles que les écoles polytechniques.

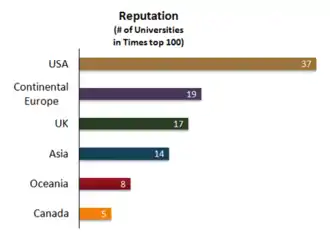

Pour les raisons évoquées ci-dessus, les rankings sont conçus avec un modèle d’université idéale. Implicitement, ce modèle est bien souvent celui des grandes universités anglo-saxonnes. Il n’est donc pas étonnant de voir que les universités nord-américaines occupent les premiers rangs, suivis des universités anglaises. De même, les universités qui se spécialisent dans un petit nombre de domaines porteurs grimpent plus facilement dans ces classements. Les universités européennes généralistes de service public ne cadrent donc pas forcément avec les critères utilisés pour ces classements.

Méthode

Le chercheur québécois Yves Gingras souligne le peu de pertinence d'un indicateur du classement de Shanghai, qui fait varier de 100 rangs la position de l'université Humboldt de Berlin, en 2008, selon qu'on lui attribue ou non le prix Nobel obtenu par Einstein en 1922[9].

Le rapport Bourdin soulève plusieurs limites méthodologiques :

«

- Les mesures et pondérations choisies ne font l'objet d'aucune justification théorique. Les utilisateurs des classements sont invités à partager des choix dont ils ne sont pas toujours bien informés. De façon générale, la légitimité des indicateurs synthétiques est incertaine, d'une part parce qu'ils agrègent des données disparates, et d'autre part, parce qu'ils résultent de choix qui placent en fait l'observateur supposé en situation d'acteur.

- La source des indicateurs est problématique, dans le cas de données déclarées par les universités elles-mêmes. Des études menées aux États-Unis ont montré que ces données étaient l'objet de manipulations, ou que certaines règles étaient modifiées par les universités en sorte d'améliorer artificiellement leur place dans les classements[10].

- Les indicateurs choisis ont parfois un caractère indirect (utilisation de « proxies »). Ainsi par exemple, que mesurent, en réalité, les enquêtes de réputation telles que celles effectuées dans le cadre du classement du Times (TH-QS) ? Mesurent-elles la sélectivité de l'établissement, la qualité de sa recherche, son prestige historique ? Ces mesures créent des effets de rémanence, car la réputation d'un établissement dépend en partie des classements passés.

- Les indicateurs retenus sont liés entre eux, en sorte que la dimension « multicritères » du classement est en partie superficielle. Dans le cas du classement de Shanghai, les critères bibliométriques se chevauchent (« nombre d'articles référencés au niveau international » et « nombre d'articles publiés dans les revues « Science » et « Nature » » par exemple) ou recoupent indirectement d'autres critères comme l'obtention de distinctions académiques (prix Nobel, médailles Fields). Dans le cas du classement du TH-QS, la réputation dépend aussi de ce qui est mesuré par les autres indicateurs employés, en sorte que les mêmes éléments sont pris en compte plusieurs fois pour la réalisation d'un classement, dans une mesure qu'il est difficile d'évaluer.

- Enfin, les écarts statistiques ne sont pas toujours suffisamment significatifs pour qu'un classement établissement par établissement, par ordre décroissant de performance soit réellement pertinent. Le classement de Shanghai s'effectue d'ailleurs par tranche de 50 puis de 100 établissements, à compter du 100e établissement. Or les écarts sont-ils vraiment plus significatifs avant qu'après la centième place ?

»

Voir aussi

Articles connexes

Liens externes

- Notice dans un dictionnaire ou une encyclopédie généraliste :

Notes et références

- Du bon usage des classements universitaires internationaux

- Le problème du classement de Shanghai, c’est qu’il existe

- Ellen Hazelkorn, « Universities have become isolated from their publics ».

- « About | CWUR | Center for World University Rankings », sur cwur.org (consulté le )

- CWUR Methodology

- http://rankingwatch.blogspot.com/2015/09/looking-inside-engine-structure-of.html Looking Inside the Engine: The Structure of the Round University Rankings University - Ranking Watch (Septembre 2015)

- Face à Shangaï, les Mines dégainent leur classement, L'Express, 18 septembre 2008

- Enseignement supérieur : le défi des classements, Rapport d'information 442 par Joël Bourdin, juillet 2008.

- Yves Gingras, La fièvre de l'évaluation de la recherche, Centre universitaire de recherche sur la science et la technologie, mai 2008

- Voir par exemple: Dill, D.D., Soo, M. Academic quality, league tables, and public policy: A cross-national analysis of university ranking systems, Higher Education volume 49, pages 495–533 (2005).

Liens externes

- Notice dans un dictionnaire ou une encyclopédie généraliste :