Paradoxe de Stein

Le paradoxe de Stein est un résultat de statistique, dû au statisticien Charles Stein, exposé dans un article de 1956[1], puis étendu dans un article co-écrit avec Willard James en 1961[2]. Ce résultat n'est pas paradoxal à proprement parler, mais surprenant et contre intuitif. Il constitue un pas important dans l'introduction des estimateurs contractants (en) (shrinkage estimators en anglais) en montrant que l'estimateur de James-Stein (en) domine strictement l'estimateur du maximum de vraisemblance. Son caractère paradoxal vient du fait qu'il justifie de combiner des observations sans rapport entre elles pour estimer leurs espérances.

Énoncé

Soient variables aléatoires réelles indépendantes ayant des distributions normales d'espérances , et toutes de variance . Le paradoxe concerne l'estimation des espérances .

Il est facile de montrer que l'estimateur du maximum de vraisemblance estime par , par , ... , par .

Notons le vecteur aléatoire de ayant pour coordonnées et le vecteur de ayant pour coordonnées . L'estimateur du maximum de vraisemblance de est alors simplement . Cet estimateur est non biaisé, et il s'agit de l'estimateur non biaisé de plus petite variance. Cependant, le paradoxe de Stein est que si , il existe un meilleur estimateur : l'estimateur de James-Stein (nommé d'après Willard James et Charles Stein), défini par , où est le carré de la norme de .

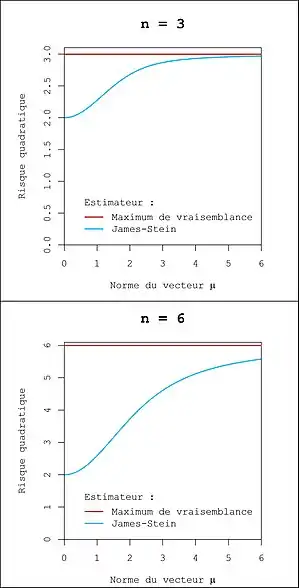

Le mot meilleur ici est à prendre au sens du risque quadratique. Le risque quadratique d'un estimateur est défini par : (ce risque correspond à une erreur quadratique moyenne multiparamétrique). L'estimateur de James-Stein est meilleur au sens qu'il a un plus faible risque quadratique que l'estimateur du maximum de vraisemblance, et ce quel que soit . On dit que l'estimateur de James-Stein domine l'estimateur du maximum de vraisemblance. Cette domination est stricte car il existe des valeurs de pour lesquelles le risque de l'estimateur de James-Stein est strictement plus petit que celui de l'estimateur du maximum de vraisemblance.

Énoncé formel

Ce résultat peut être énoncé de manière plus concise:

Théorème — Soit , et . Soit et . Alors . De plus, il existe au moins un pour lequel l'inégalité précédente est stricte. |

Démonstration

Reprenons les notations précédentes et calculons le risques quadratiques des deux estimateurs.

Risque quadratique de l'estimateur du maximum de vraisemblance

Le risque quadratique de vaut :

Risque quadratique de l'estimateur de James-Stein

Le risque quadratique de est

qu'on peut réécrire

- .

Or,

- où désigne le produit scalaire.

Donc

Calculons maintenant .

Chaque intégrale de cette somme peut-être simplifiée en utilisant une intégration par partie en écrivant :

- et .

D'où

En sommant sur , on obtient que

Et donc, le risque de l'estimateur de James-Stein est

Étant donné que , on a ainsi que le risque quadratique de l'estimateur de James-Stein est strictement inférieur à celui du maximum de vraisemblance.

Remarques

On remarque que le risque de l'estimateur de James-Stein ne dépend que la norme de , et qu'il atteint sa valeur minimale, 2, lorsque . En effet, suit alors une Loi inverse χ² d'espérance , donnant alors le risque . Pour toute valeur de , le gain d'utiliser l'estimateur de James-Stein augmente avec .

Interprétation

Paradoxe

Ce résultat est qualifié de paradoxe car il serait naturel de s'attendre à ce que l'estimateur du maximum de vraisemblance soit meilleur. En effet, l'estimation de dans l'estimateur de James-Stein utilise toutes les observations, même si ne sont porteurs d'aucune information sur puisque leurs distributions ne dépendent pas de et qu'elles sont indépendantes de . Il en va de même pour les estimations de . Les variables aléatoires n'ayant possiblement aucun rapport, il est étrange que la meilleure stratégie ne soit pas d'estimer l'espérance en utilisant uniquement l'observation .

Pour illustrer cela[3], supposons qu'on s'intéresse à la proportion d'électeurs qui comptent voter pour Trump à une élection, à la proportion de nouveau-nés filles en Chine, et à la proportion de britanniques ayant les yeux bleus. Pour cela, on dispose de trois observations : le résultat d'un sondage électoral, le nombre de filles nées dans un hôpital chinois et le nombre de personnes aux yeux bleus dans une ville anglaise (ces observations sont issues de lois binomiales, mais elles peuvent facilement être approximées, après transformation, par des lois normales). Alors, en utilisant l'estimateur de James-Stein, on estimera en particulier la proportion de votant pour Trump en utilisant le nombre de filles nées dans l'hôpital chinois et le nombre de personnes aux yeux bleus dans la ville anglaise !

Explication

En réalité, il serait peu judicieux d'utiliser l'estimateur de James-Stein dans l'exemple précédent. Cet estimateur a certes le plus petit risque quadratique combiné sur les trois estimations, mais il n'a pas le plus petit risque quadratique pour une estimation particulière. En général, l'estimateur de James-Stein a tendance à dégrader la plupart des estimations mais à en améliorer sensiblement quelques-unes, ces quelques améliorations compensent les dégradations. Dans l'exemple précédent, il est probable que deux des trois estimations soient moins bonnes avec l'estimateur de James-Stein qu'avec le maximum de vraisemblance, mais que la troisième soit suffisamment meilleure pour réduire le risque quadratique total. En pratique, un statisticien intéressé uniquement à la proportion de filles parmi les nouveau-nés en Chine n'aurait très certainement pas intérêt à utiliser cet estimateur comme décrit précédemment, de même pour quelqu'un intéressé uniquement par la proportion d'électeurs de Trump ou uniquement par le nombre de personnes aux yeux bleus. Pour que cet estimateur ait un intérêt, il faut qu'un statisticien soit intéressé simultanément à ces trois estimations, ce qui est peu probable.

Estimateur contractant

L'estimateur de James-Stein est un exemple d'estimateur contractant (en), c'est-à-dire qui ramène artificiellement les valeurs estimées vers 0. D'autres exemple de tels estimateurs sont les estimateurs de type Lasso ou ceux utilisant une régularisation de Tikhonov (Ridge regression en anglais). Il est donc naturel que le gain de risque quadratique obtenu en utilisant l'estimateur de James-Stein plutôt que le maximum de vraisemblance soit maximal lorsque .

Le risque quadratique d'un estimateur peut se décomposer en . Le premier terme de cette décomposition augmente avec le biais de l'estimateur et le second avec sa variance. La contraction des estimations a pour effet d'augmenter le biais mais de diminuer la variance. La diminution de variance surpasse l'augmentation du biais de telle sorte que le risque quadratique diminue.

Le choix de contracter vers 0 est arbitraire et des estimateurs de James-Stein peuvent être construits en contractant vers n'importe quelle valeur selon:

.

Quelle que soit la valeur de , l'estimateur de James Stein contractant vers domine strictement le maximum de vraisemblance. Bradley Efron et Carl Morris ont montré en 1973[4], qu'utiliser lorsque est un meilleur choix que .

Généralisations du résultat

L'estimateur de James-Stein peut facilement être amélioré en prenant la partie positive du facteur de contraction donnant l'estimateur : où désigne la partie positive.

Le résultat de Stein de 1956 utilise 3 hypothèses : les ont des distributions normales, leurs variances sont connues et identiques, et ils sont indépendants. Cependant ce résultat a été étendu et toutes ces hypothèses ne sont pas nécessaires : le paradoxe de Stein a été généralisé à des problèmes d'estimations où les variances des différentes variables aléatoires peuvent être différentes et inconnus, et même à des problèmes où les distributions ne sont pas normales.

L'utilisation du risque quadratique n'est pas indispensable non plus. L'estimateur de James-Stein peut être adapté à une large classe de fonctions de risque pour lesquelles il domine toujours l'estimateur du maximum de vraisemblance[5].

Références

- (en) Charles Stein, « Inadmissibility of the Usual Estimator for the Mean of a Multivariate Normal Distribution », Proceedings of the Third Berkeley Symposium on Mathematical Statistics and Probability, The Regents of the University of California, (lire en ligne, consulté le )

- (en) Willard James et Charles Stein, « Estimation with quadratic loss », Breakthroughs in statistics, , p. 443-460 (lire en ligne)

- (en) Richard J. Samworth, « Stein's Paradox », Eureka, , p. 38-41 (lire en ligne)

- (en) Bradley Efron et Carl Morris, « Stein's Estimation rule and its competitors - an empirical Bayes approach », Journal of the American Statistical Association, (lire en ligne)

- Lawrence D. Brown, « On the Admissibility of Invariant Estimators of One or More Location Parameters », Annals of Mathematical Statistics, (lire en ligne)

![{\displaystyle {\frac {(x_{i}-\mu _{i})}{(2\pi )^{\frac {n}{2}}}}e^{-{\frac {1}{2}}\lVert {\vec {x}}-{\vec {\mu }}\rVert ^{2}}={\frac {\partial }{\partial x_{i}}}\left[-{\frac {1}{(2\pi )^{\frac {n}{2}}}}e^{-{\frac {1}{2}}\lVert {\vec {x}}-{\vec {\mu }}\rVert ^{2}}\right]}](https://img.franco.wiki/i/0229de52118cc118229251ee5e83681016031068.svg)

![{\displaystyle {\frac {\partial }{\partial x_{i}}}\left[{\frac {x_{i}}{\lVert {\vec {x}}\rVert ^{2}}}\right]={\frac {\lVert {\vec {x}}\rVert ^{2}-2x_{i}^{2}}{\lVert {\vec {x}}\rVert ^{4}}}}](https://img.franco.wiki/i/19c8b8e8b658c4c9e41fdc9de4f6dfa1a2836831.svg)