Redresseur (réseaux neuronaux)

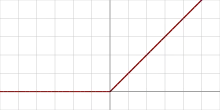

En mathématiques, la fonction Unité Linéaire Rectifiée (ou ReLU pour Rectified Linear Unit) est définie par :

pour tout réel

Elle est fréquemment utilisée comme fonction d'activation dans le contexte du réseau de neurones artificiels pour sa simplicité de calcul, en particulier de sa dérivée.

Variations

Un désavantage de la fonction ReLU est que sa dérivée devient nulle lorsque l'entrée est négative ce qui peut empêcher la rétropropagation du gradient[1]. On peut alors introduire une version appelée Leaky ReLU définie par :

pour tout réel

Le paramètre est un réel strictement positif et inférieur à 1 La dérivée est alors égale à lorsque x est strictement négatif, ce qui permet de conserver la mise à jour des poids d'un perceptron utilisant cette fonction d'activation.

Notes et références

- « Activation Functions | Fundamentals Of Deep Learning », sur Analytics Vidhya, (consulté le )

![{\displaystyle \epsilon \in ]0,1[}](https://img.franco.wiki/i/3e65a42e37f9c6d7501b8eafd54ac00ac93739f6.svg)