Canal de communication (théorie de l'information)

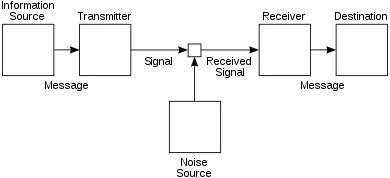

En théorie de l'information, un canal de communication ou canal de transmission est un support (physique ou non) permettant la transmission d'une certaine quantité d'information, depuis une source (ou émetteur) vers un destinataire (ou récepteur). Souvent, le canal altère l'information transmise, par exemple en ajoutant un bruit aléatoire.

La quantité d'information qu'un canal de communication peut transporter est limitée : on parle de capacité du canal.

Définition et enjeux

On peut décomposer simplement un système de communication en trois grandes parties[S 1] : une source d'information (associée à un transmetteur), un destinataire (associé à un récepteur), et le canal de communication, qui assure la liaison entre les deux. Selon les modèles de canaux, l'information transmise peut être discrète ou continue.

Souvent, le canal est équipé d'un modèle probabiliste qui décrit le signal sortant en fonction du signal entrant. Cela correspond à des situations réelles comme la transmission d'un signal logique sur un fil ou d'un message sur l'Internet, car les canaux réels ne sont pas entièrement fiables et les erreurs ne se produisent pas de façon systématique.

L'objectif du destinataire est donc de reconstituer le message original à partir de l'information transmise par le canal, ce qui donne lieu à l'usage de codes et plus spécifiquement de codes correcteurs d'erreurs.

Canal de communication discret

Définitions

Canal discret (Définition) — Un canal de communication est dit discret[S 2] lorsqu'il transmet une séquence de symboles où .

L'ensemble fini des valeurs possibles des est appelé alphabet.

Le télégraphe est un exemple de système dans lequel le canal de communication est dit discret : on transmet une suite de symboles élémentaires (code Morse). Les signaux logiques comme le binaire sont également discrets.

Débit et capacité

Le débit d'information est défini en fonction du nombre de signaux pouvant circuler pendant une durée .

La capacité d'un canal de communication constitue une limitation de la quantité d'information que la source peut transmettre vers le récepteur. Elle est définie comme le maximum du débit.

Débit (Définition) — Le débit est donné par :

Capacité (Définition) — La capacité est définie par :

Modèle probabiliste

On considère un canal dont l'alphabet d'entrée est et l'alphabet de sortie est . Cela signifie que les symboles du message émis sont des lettres de et que ceux du message reçu sont des lettres de . Le canal est défini par une loi de probabilité décrivant la probabilité de la sortie en fonction de l'entrée.

Supposons que l'on envoie un symbole dans le canal ; la probabilité que le symbole sortant soit est notée . Si les deux alphabets sont identiques, la probabilité que le symbole soit transmis de façon fidèle est .

Dans le cas général, on modélise le symbole transmis par une variable aléatoire de loi (avec ). Différents choix existent pour cette loi, notamment :

- La loi uniforme :

- Lorsque le message transmis est un mot , une définition naturelle est : la proportion d'apparition de la lettre dans .

Dans cette situation, le symbole en sortie du canal est aussi une variable aléatoire, , dont la loi dépend de celle de :

On retrouve alors la capacité du canal en observant l'information mutuelle entre l'entrée et la sortie. L'information mutuelle représente informellement la quantité d'information de qui a été préservée par le passage dans le canal. La capacité du canal de communication est alors définie par :

La borne supérieure porte sur la distribution de probabilité de . Pour exploiter toute la capacité du canal, il faut donc choisir judicieusement les symboles que l'on y envoie, car tous ne sont pas traités également.

Principaux types

Canaux parallèles

Lorsque est un canal d'entrée et de sortie , on définit pour tout le canal qui représente copies indépendantes et parallèles de . Il prend son entrée dans et produit une sortie dans selon la distribution de probabilité :

Mesure de la performance d'un canal

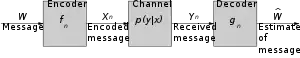

Lorsqu'on veut transmettre par un canal un message parmi messages possibles, on choisit un code représenté par deux fonctions :

- Un encodeur

- Un décodeur

Le message est transmis par le canal puis réinterprété à l'aide du décodeur pour donner une estimation du message original. Plusieurs mesures peuvent être utilisées pour interpréter la performance du canal, notamment :

- La probabilité d'erreur . Dans le cas d'un canal discret (et en supposant que est tiré uniformément), cette probabilité s'exprime par :

- La probabilité d'erreur maximale, qui représente le pire cas pour la transmission :

Il y a un compromis naturel entre le nombre de messages différents transmis et la probabilité d'erreur de transmission . On s'intéresse souvent au meilleur que l'on peut obtenir pour une certaine valeur maximale de , noté .

La valeur particulière est appelée capacité à zéro-erreur de et est définie en faisant tendre vers la limite :

Notes et références

Références

- C. E. Shannon, A mathematical theory of communication, (œuvre écrite), Inconnu, Short Hills (d), , [lire en ligne]

- p. 381

- p. 382