Test de performance

Un test de performance est un test dont l'objectif est de déterminer la performance d'un système informatique.

L'acception la plus courante de ce terme est celle dans laquelle ces tests logiciels vont avoir pour objectif de mesurer les temps de réponse d'un système applicatif en fonction de sa sollicitation. Cette définition est donc très proche de celle de test de charge où l'on mesure le comportement d'un système en fonction de la charge d'utilisateurs simultanés. Seuls les tests de charge permettent de valider correctement une application ou un système avant déploiement, tant en qualité de service qu'en consommation de ressources.

Types de tests

Ces tests peuvent être de plusieurs types, notamment :

- Test de charge : il s'agit d'un test au cours duquel on va simuler un nombre d'utilisateurs virtuels prédéfinis, afin de valider l'application pour une charge attendue d'utilisateurs. Ce type de test permet de mettre en évidence les points sensibles et critiques de l’architecture technique. Il permet en outre de mesurer le dimensionnement des serveurs, de la bande passante nécessaire sur le réseau, etc. ;

- Test de performance : proche du Test de charge, il s'agit d'un test au cours duquel on va mesurer les performances de l'application soumise à une charge d'utilisateurs. Les informations recueillies concernent les temps de réponse utilisateurs, les temps de réponse réseau et les temps de traitement d’une requête sur le(s) serveur(s). La nuance avec le type précédent réside dans le fait qu'on ne cherche pas ici à valider les performances pour la charge attendue en production, mais plutôt vérifier les performances intrinsèques à différents niveaux de charge d'utilisateurs ;

- Test de dégradations des transactions : il s'agit d'un test technique primordial au cours duquel on ne va simuler que l'activité transactionnelle d'un seul scénario fonctionnel parmi tous les scénarios du périmètre des tests, de manière à déterminer quelle charge le système est capable de supporter pour chaque scénario fonctionnel et d'isoler éventuellement les transactions qui dégradent le plus l'ensemble du système. Ce test peut tenir compte ou non de la cadence des itérations, la représentativité en termes d'utilisateurs simultanés vs. sessions simultanées n'étant pas ici un objectif obligatoire, s'agissant ici plutôt de déterminer les points de contention générés par chaque scénario fonctionnel. La démarche utilisée est d'effectuer une montée en charge linéaire jusqu'au premier point de blocage ou d'inflexion. Pour dépasser celui-ci, il faut paramétrer méthodiquement les composants systèmes ou applicatifs afin d'identifier les paramètres pertinents, ce jusqu'à obtention des résultats satisfaisants. Méthodologiquement, ce test est effectué avant les autres types de tests tels que performance, robustesse, etc. où tous les scénarios fonctionnels sont impliqués ;

- Test de stress : il s'agit d'un test au cours duquel on va simuler l'activité maximale attendue tous scénarios fonctionnels confondus en heure de pointe de l'application, pour voir comment le système réagit au maximum de l'activité attendue des utilisateurs. La durée du palier en pleine charge, en général de 2 heures, doit tenir compte du remplissage des différents caches applicatifs et clients, ainsi que de la stabilisation de la plateforme de test suite à l'éventuel effet de pic-rebond consécutif à la montée en charge. Dans le cadre de ces tests, il est possible de pousser le stress jusqu'à simuler des défaillances systèmes ou applicatives afin d'effectuer des tests de récupération sur incident (Fail-over) ou pour vérifier le niveau de service en cas de défaillance ;

- Test de robustesse, d'endurance, de fiabilité : il s'agit de tests au cours desquels on va simuler une charge importante d'utilisateurs sur une durée relativement longue, pour voir si le système testé est capable de supporter une activité intense sur une longue période sans dégradations des performances et des ressources applicatives ou système. Le résultat est satisfaisant lorsque l'application a supporté une charge supérieure à la moitié de la capacité maximale du système, ou lorsque l'application a supporté l'activité d'une journée ou plusieurs jours/mois/années, pendant 8 à 10 heures, sans dégradation de performance (temps, erreurs), ni perte de ressources systèmes ;

- Test de capacité, test de montée en charge : il s'agit d'un test au cours duquel on va simuler un nombre d'utilisateurs sans cesse croissant de manière à déterminer quelle charge limite le système est capable de supporter. Éventuellement, des paramétrages peuvent être effectués, dans la même logique que lors des tests de dégradation, l'objectif du test étant néanmoins ici de déterminer la capacité maximale de l'ensemble système-applicatif dans une optique prévisionnelle (cf. capacity planning, gestion de la capacité en français) ;

- Test aux limites : il s'agit d'un test au cours duquel on va simuler en général une activité bien supérieure à l'activité normale, pour voir comment le système réagit aux limites du modèle d'usage de l'application. Proche du test de capacité, il ne recouvre pas seulement l'augmentation d'un nombre d'utilisateurs simultanés qui se limite ici à un pourcentage en principe prédéfini, mais aussi les possibilités d'augmentation du nombre de processus métier réalisés dans une plage de temps ou en simultané, en jouant sur les cadences d'exécutions, les temps d'attente, mais aussi les configurations de la plateforme de test dans le cadre d'architectures redondées (Crash Tests) ;

- Test de résilience : il s'agit d'un test au cours duquel on va simuler une activité réelle tout en simulant des pannes en environnement réel et de vérifier que le système informatique continue à fonctionner. Proche du test de robustesse, il permet de s'assurer de la résilience des applications et de l'infrastructure sous-jacente. Pour provoquer les pannes pendant le test, on peut utiliser des chaos monkey qui mettent aléatoirement hors service des instances dans l’environnement de test.

- Il existe d'autres types de tests, plus ciblés et fonction des objectifs à atteindre dans la campagne de tests :

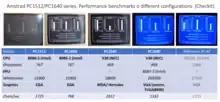

- Test de Benchmark (comparaisons de logiciel, matériels, architectures…),

- Tests de non-régression des performances,

- Tests de Composants,

- Tests de Volumétrie des données,

- Tests de Fonctionnement, etc.

Étant entendu qu'en principe un type de test correspond à un type d'objectif, et que dans une matrice de couverture des tests les résultats se recoupent obligatoirement, il est rare (et coûteux) de réaliser l’ensemble de ces tests pour une application donnée.

Si l'application est déjà en production, ou en phase pilote, on peut aussi, afin de connaître les performances du système, réaliser une métrologie, qualifiée de surveillance de la production, qui permettra d'observer dans le détail le fonctionnement du système sur la base d'actions réelles des utilisateurs. Les résultats d'une telle campagne de métrologie permettant de connaître les fonctionnalités réellement utilisées, et leur fréquence d'utilisation, ils peuvent ensuite servir de base pour orienter les tests à réaliser dans des simulations futures, ou servir de base à une solution de supervision de la production.

Définition du plan de tests

Le plan de tests est l'expression du besoin de la campagne de tests, et c'est le premier livrable du processus des tests. On y trouve la présentation du projet (résumé, architecture technique et logicielle), les objectifs, le modèle de charge, le type de tests à réaliser, les scénarios fonctionnels (ou cas d'utilisation) à tester accompagnés des jeux de données nécessaires, et un planning d'exécution de ces tests. Ce document reprend des éléments des entrées au processus des tests, notamment le cahier des charges des tests établi par le « client » (en général, une MOE) auquel est joint le Document d'Architecture Technique. Bien évidemment, la réussite du processus est directement liée à la précision et la complétude des informations fournies en entrée.

Les jeux de données permettent de simuler au plus juste la réalité. Un jeu de données peut, par exemple, consister en n logins et n mots de passe, permettant ainsi de simuler des utilisateurs différents se connectant à l'application.

Le modèle de charge consiste, à partir d'un modèle d'usage de l'application (nombre d'utilisateurs simultanés, nombre de processus métier réalisés, périodes d'utilisation, heures de pointe…) à modéliser la charge qui devra être simulée et qui se devra d'être représentative de l'activité réelle ou attendue de l'application en pic, en général lors d'un test de stress, en tenant compte de l'environnement des tests. Cette modélisation contient donc un nombre d'utilisateurs à simuler, leur répartition sur les différents scripts (scénarios fonctionnels), leurs rythmes d'exécution respectifs. Accessoirement, le modèle peut tenir compte des profils de montée ou descente de charge des groupes d'utilisateurs, si cela revêt une importance très particulière (par exemple lorsque l'on veut simuler des « rafales » de transactions), sachant que par principe les performances en charge cible doivent être indépendantes de la montée en charge (après stabilisation).

Présentation des résultats et Bilan des Tests

Le Bilan des Tests, livrable obligatoire et essentiel du processus de test, donne les résultats obtenus lors des tests effectués, éventuellement un avis de mise en production, mais aussi des préconisations applicatives ou systèmes pour résoudre les problèmes de performance.

Corrélé au Plan de Test, il permet de valider que les résultats obtenus sont conformes aux objectifs attendus, dans un contexte technique précis (production, préproduction, dédié, modélisé…), éventuellement optimisé, avec des hypothèses de charge clairement identifiées et définies par les MOA, et/ou MOE, et/ou Production.

À ce titre, il restitue des résultats selon trois vues :

- Vue Métier : nombre de clients de l'application connectés, nombre de processus métier réalisés ;

- Vue Utilisateur : temps de réponse des transactions, taux d'erreur ;

- Vue Technique : consommations des ressources systèmes (CPU, Mémoire, I/O), consommations applicatives (métriques applicatives telles que sessions, attentes dans les pools threads/connexions, etc.).

L'ensemble des données restituées dans le bilan donne donc un niveau de qualité de service de l'application, en charge, qui est à rapprocher des attendus prédéfinis dans le Plan de Test. Il doit permettre aux équipes de production d'anticiper les ressources à mettre à disposition, ainsi que les paramétrages à mettre en œuvre.

Méthodologie

Les tests de performance doivent être implémentés et réalisés tout au long du cycle de développement, et ce le plus tôt possible. Un résultat plus ou moins précis maintenant vaut mieux qu’un résultat très précis plus tard.

- Tester de façon large, puis de façon approfondie.

- Tester dans un environnement contrôlé.

- L'environnement de test doit être dans la mesure du possible identique à l’environnement de production, à défaut à une échelle étalonnée reconnue fiable permettant d'établir des abaques.

Étape 1 : Analyse de Référence (l’analyse préliminaire consiste en l’enregistrement d’un ou de plusieurs scénarios (ou cas d'utilisation) pour mieux comprendre l’application et l’étendue du test).

- Définir le système à tester, les processus métier, et les objectifs (métiers, techniques, économiques).

- Définir les scénarios, par rapport à une analyse complète des risques métiers et techniques.

- Définir le modèle de charge, par rapport au modèle d'usage de l'application.

- Caractériser les données pour chaque scénario.

- Enregistrer les scénarios.

Étape 2 : Tests Préliminaires.

- Mettre en œuvre des moyens et définir la plate-forme de test.

- Exécuter les tests de charge (préliminaires).

- Analyser les résultats.

Étape 3 : Test de Charge à Grande Échelle

- Mettre en œuvre des moyens et définir la plate-forme de test.

- Exécuter les tests de charge.

- Analyser les résultats.

- Optimiser le système.

Outillage nécessaire

Comme il s'agit en général de simuler un nombre d'utilisateurs important, il s'avère nécessaire d'automatiser ces tests. L'automatisation des tests, que ce soit pour des tests de performance ou non, nécessite de répondre à deux problèmes :

- être capable d'enchaîner des actions sur le système selon des scénarios qui ont du sens pour les objectifs de test ;

- valoriser ces actions sur des données qui sont pertinentes à la fois vis-à-vis des scénarios et de l'état du système au moment où l'on exécute ces tests.

Prenons par exemple le cas du test de performance d'un portail eCommerce dans lequel on va adresser plus particulièrement la fonction de constitution d'un panier d'achat. Il faut disposer d'un mécanisme d'automatisation des actions de sélection d'article, de validation de commande, etc. Mais il faut également valoriser ces actions en donnant les articles qui seront effectivement commandés par les utilisateurs virtuels (simulés) dans le cadre du test de performance. Or, la nature et le nombre de ces articles peuvent varier en fonction du contenu de la base de données d'articles de l'application, du profil de consommateur de l'utilisateur simulé, ou encore de la période de l'année que l'on simule dans le test.

Une plate-forme de test de performances va généralement comporter :

- Un injecteur de charge (appelé aussi générateur ou moteur de charge) : logiciel qui va être capable de simuler les actions des utilisateurs et de ce fait générer la charge sur l'application. Ces actions sont définies dans des scripts automatisant des scénarios et valorisés sur un lot de données particulier. On peut donc distinguer deux catégories d'outils :

- les simulateurs d'utilisateurs qui, grosso modo, instancient les scripts de test sur un grand nombre d'utilisateurs (virtuels),

- les générateurs de données qui vont permettre de valoriser les scripts utilisés et ainsi assurer que chaque utilisateur virtuel n'effectue pas exactement la même opération ce qui n'aurait pas beaucoup de sens du point de vue des performances mesurées ensuite ;

- Des sondes : placées au niveau du système cible, elles permettent de remonter des mesures dont l'objet est de savoir comment réagissent individuellement des composantes du système. Les éléments sur lesquels on va en général placer des sondes sont l'utilisation de la mémoire, processeur, disque et réseau. Il est évidemment préférable d'utiliser des sondes qui ne perturbent pas le système, en privilégiant au maximum les API disponibles en natif au sein des composants techniques, et en évitant l'utilisation d'agents.

Les solutions de tests de performances Web vont permettre de simplifier et d'automatiser les tests : création plus ou moins automatisée des scénarios de tests, configuration des scénarios avec ou sans script, simulation d'utilisateurs virtuels avec collecte des mesures (et génération automatique de rapports), etc.

Il est utile de se souvenir que les outils de test de performance peuvent générer des effets de sonde, et qu'il faut donc les utiliser ou les configurer de manière que ce risque soit réduit.

Acteurs et outils du marché

Plusieurs outils permettent de réaliser des tests de performances ; ce qui les différencie, ce sont notamment :

- La technologie employée (mode graphique, mode protocolaire, scripting, monitoring, reporting) ;

- Le type d'application testée (web, SAP, Oracle, RDP, Citrix, Mainframe, Windows Sockets…) ;

- Le prix des licences ;

- Le coût de la mise en œuvre (en dehors des licences) ;

- La maturité et l'efficacité du produit ;

- Le support.

Selon plusieurs cabinets d'analyse tels IDC[1] ou Gartner Group, des leaders se démarquent sur le marché, mais il existe aussi quantité de produits Open Source ou à prix réduits, surtout pour les applications Web. Les solutions les plus représentatives du secteur sont :

- HP LoadRunner/Performance Center[2], de Hewlett-Packard ;

- WebLOAD[3], de RadView Software ;

- Oracle Load Testing[4] - [5]

- Rational Performance Tester (en)[6], de IBM ;

- Powerhouse User Satisfaction Performance (Loadtesting solution)[5]

- Micro Focus Silk Performer[7] ;

- Quotium QTest[8] ;

- NeoLoad (en)[9], de Neotys ;

- Apache JMeter[10] (logiciel libre, le leader du marché) de Apache Software Foundation ;

- Smartbear Software (LoadUiweb Pro) ;

- Gatling[11]

Gestion des données de test

On distingue dans la gestion des données de test deux principaux types d'acteurs. Il y a ceux qui s'appuient sur les données de production et proposent des outils d'extraction et de transformation des données de production et ceux qui s'appuient sur des mécanismes de génération pour produire à partir de rien (ou presque) les jeux de données de test.

Les outils basés sur l'extraction sont particulièrement pertinents pour construire des bases de test de référence comme des catalogues de produits. D'ailleurs, n'importe quel outil d'extraction de base de données doit pouvoir faire l'affaire. Toutefois, IBM avec Optim et Micro Focus (ex-Compuware) avec FileAid se sont positionnés sur ce marché avec des outils qui, à l'origine, servent à faire de la duplication de base de données (pour traiter des problématiques d'archivage des données anciennes, par exemple).

Une solution basée sur la génération automatique est quasiment incontournable pour produire les différentes transactions (constitution d'un panier d'achat par exemple) qui vont servir à valoriser les scripts de test. Si la variabilité du comportement des utilisateurs virtuels est un critère de pertinence pour la campagne de test alors chacune des transactions injectées dans une campagne de test doit être originale et globalement l'ensemble des transactions doivent avoir une cohérence vis-à-vis des objectifs de tests. Sur le marché des outils de génération de données on trouve moins d'acteurs, mais on peut noter Grid-Tools, une société anglaise qui édite DataMaker et GenieLog qui édite l'atelier de production de jeux de données GEDIS Studio.

Organismes du secteur

- Le TPC (Transaction Processing Performance Council) est un organisme indépendant des constructeurs qui définit des protocoles de test et publie des classements, suivant plusieurs critères[12]. Le plus connu est le TPC-C pour le transactionnel, mais il existe des classements pour les systèmes décisionnels (TPC-H). Les classements ne sont pas faits seulement suivant la puissance, mais aussi suivant le rapport coût/performance[13].

- Le Standard Performance Evaluation Corporation (SPEC) est un organisme indépendant sans but lucratif qui établit et publie des tests de performance de systèmes, en particulier un test de mesure de puissance CPU[14].

Notes et références

- IDC Corporate USA

- HP LoadRunner/Performance Center.

- RadView WebLOAD.

- Oracle Application Testing Suite.

- « User Satisfaction Performance : au-delà du test de charge », sur atakama-technologies.com (consulté le )

- IBM Rational Performance Tester.

- Borland Silk Performer.

- Quotium QTest.

- Neotys NeoLoad.

- Apache JMeter.

- Gatling.

- Protocoles de test du TPC.

- Classement TPC suivant le rapport coût/performance.

- Mesures des puissances CPU par la SPEC.

Voir aussi

Articles connexes

Liens externes

- (de) heise online, « PassMark PerformanceTest »

- (en) « Linux Benchmark Suite »,