Nat (information)

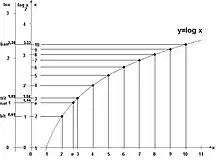

Un nat (parfois aussi appelé nit ou nepit) est une unité logarithmique de mesure de l'information ou de l'entropie, basée sur le logarithme néperien et les puissances de e plutôt que sur le logarithme en base 2 qui définit le bit. Le nat est l'unité naturelle pour l'entropie en théorie de l'information. Les systèmes d'unités naturelles qui normalisent la constante de Boltzmann à 1 mesurent effectivement une entropie en nats. Quand l'entropie de Shannon est donnée avec le logarithme naturel,

elle donne implicitement une valeur en nats. Un nat vaut environ 1,44 bits (exactement ), ou 0,434 bans ().

Historique

Alan Turing a utilisé le ban. Boulton et Wallace (1970) employèrent le terme de nit pour la longueur minimale d'un message, qui a été par la suite remplacé par nat pour éviter toute confusion avec le nit comme unité de luminosité.

Références

- (en) J. W. Comley, D. L. Dowe, P. Grünwald (éditeur), I. J. Myung (éditeur) et M. A. Pitt (éditeur), Advances in Minimum Description Length : Theory and Applications, Cambridge, MIT Press, (ISBN 0-262-07262-9, lire en ligne), « Minimum Message Length, MDL and Generalised Bayesian Networks with Asymmetric Languages »

- (en) Fazlollah M. Reza, An Introduction to Information Theory, New York, Dover, , 496 p. (ISBN 978-0-486-68210-5, LCCN 94027222, lire en ligne)