Adaptation de domaine

L'adaptation de domaine[1] - [2] - [3] - [4] - [5] (domain adaptation en anglais) est un champ de recherche de l'apprentissage automatique, et plus précisément de l'apprentissage par transfert. L'objectif est d'effectuer une tâche d'adaptation d'un système d'apprentissage d'un domaine (une distribution de probabilité) source vers un domaine (une distribution de probabilité) cible. Lorsque plusieurs domaines sources sont disponibles, on parle alors d’adaptation de domaine multi-sources[6].

Un peu de formalisme

Soit l'espace d'entrée ou de description des données et l'espace de sortie ou l'ensemble d'étiquetage. L'objectif en apprentissage automatique est d'apprendre un modèle mathématique (une hypothèse) permettant d'affecter une étiquette à une donnée. Ce modèle est appris à partir d'un échantillon d'apprentissage .

En apprentissage supervisé classique (sans adaptation de domaine), on suppose que les exemples sont tirés i.i.d. selon une distribution sur (fixe et inconnue). Le but est alors d'apprendre (à partir de ) de telle sorte qu'il étiquette au mieux de nouvelles données issues de la distribution (autrement dit qu'il commette le moins d'erreurs possible sur ).

La principale différence entre l’apprentissage supervisé classique et l’adaptation de domaine réside dans l’étude de deux distributions et différentes sur . La tâche d’adaptation consiste à transférer des connaissances du domaine source vers le domaine cible . L'objectif est alors d'apprendre (à partir d'échantillons étiquetés ou non issus des deux domaines) tel qu'il étiquette au mieux de nouvelles données issues du domaine cible .

La question majeure soulevée par ce problème est la suivante : si un modèle a été appris à partir d'un domaine source, quelle sera sa capacité à étiqueter correctement des données provenant du domaine cible ?

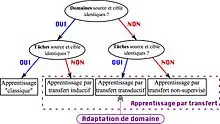

Les différents types d'adaptation de domaine

On distingue différents contextes d'adaptation de domaine. Ils diffèrent par l'information dont on dispose pour la tâche cible.

- L'adaptation de domaine non supervisée : l'ensemble d'apprentissage contient un ensemble de données étiquetées sources, un ensemble de données non étiquetées sources et un ensemble de données non étiquetées cibles.

- L'adaptation de domaine semi-supervisée : dans cette situation, on dispose de plus d'un (petit) ensemble de données étiquetées cibles.

- L'adaptation de domaine supervisée : on parle d'adaptation de domaine supervisée lorsque toutes les données cibles disponibles sont étiquetées (Ce contexte est assez peu étudié dans la littérature).

Trois grands principes algorithmiques

Les algorithmes de repondération

Le but est de repondérer l'échantillon étiqueté source de telle sorte qu'il ressemble le plus possible à l'échantillon cible (au sens de la mesure d'erreur considérée)[7] - [8].

Les algorithmes itératifs

Une méthode pour adapter consiste à itérativement "auto-étiqueter" les données cibles. Le principe est simple :

- un modèle est appris à l'aide des données étiquetées disponibles ;

- étiquette automatiquement des données cibles ;

- un nouveau modèle est appris à partir des nouvelles données étiquetée.

D'autres méthodes itératives sans auto-étiquetage existent dans la littérature, mais requièrent généralement des données étiquetées cibles.

Les algorithmes de recherche d'un espace commun

Il est courant dans la littérature de rechercher ou de construire un espace de représentation commun aux deux domaines [9] - [10]. En effet, si on réussit à plonger les deux distributions de nos domaines dans un espace où elles semblent similaires, un transfert d'apprentissage de la source vers la cible peut avoir lieu en entraînant un modèle avec la nouvelle représentation de la source.

Aujourd'hui, il y a une tendance à créer cet espace invariant pendant la phase d'entraînement d'un réseau de neurones via le mécanisme de rétropropagation du gradient. Cela est possible en utilisant notamment un coût d'adaptation modélisant une distance entre les deux distributions des domaines. Le coût globale à minimiser devient alors la somme d'un coût d'apprentissage grâce auquel le réseau va apprendre avec les données étiquetées, et d'un coût d'adaptation qui va encourager la création d'un espace invariant pour les deux domaines dans lequel le réseau va les plonger avant d'effectuer sa tâche (typiquement classification).

Pour rechercher cet espace invariant, le coût d'adaptation doit satisfaire en pratique trois contraintes :

- Il doit être différentiable car on souhaite utiliser la rétropropagation du gradient en se basant sur ce dernier

- Il faut être capable de l'estimer raisonnablement à partir d’échantillons provenant des deux distributions puisque nous n'avons pas directement accès à ces distributions.

- Il ne doit pas être trop gourmand en termes de calculs et d'espace mémoire.

Dans la littérature, il existe de nombreux candidats qui répondent à ces conditions. Actuellement, il y a une tendance à l’utilisation de distances basées sur des noyaux reproduisant[10] ou bien dérivées de la théorie du transport optimal[11].

Notes et références

- (en) John S. Bridle et Stephen J. Cox, « RecNorm: Simultaneous normalisation and classification applied to speech recognition », Conference on Neural Information Processing Systems (NIPS), , p. 234–240

- (en) Shai Ben-David, John Blitzer, Koby Crammer, Alex Kulesza, Fernando Pereira et Jennifer Wortman Vaughan, « A theory of learning from different domains », Machine Learning Journal, no 79(1-2), , p. 151–175

- (en) Yishay Mansour, Mehryar Mohri et Afshin Rostamizadeh, « Domain Adaptation: Learning Bounds and Algorithms », Proceedings of Conference on Learning Theory (COLT),

- Emilie Morvant, Apprentissage de vote de majorité pour la classification supervisée et l’adaptation de domaine : Approches PAC-Bayésiennes et combinaison de similarités, (lire en ligne), chap. 2

- (en) Ievgen Redko, Emilie Morvant, Amaury Habrard, Marc Sebban et Younès Bennani, Advances in Domain Adaptation Theory, ISTE Press - Elsevier, , 187 p. (ISBN 9781785482366, lire en ligne)

- (en) Koby Crammer, Michael Kearns et Jennifer Wortman, « Learning from Multiple Sources », Journal of Machine Learning Research, no 9, , p. 1757-1774

- (en) Jiayuan Huang, Alexander J. Smola, Arthur Gretton, Karsten M. Borgwardt et Bernhard Schölkopf, « Correcting Sample Selection Bias by Unlabeled Data », Proceedings of Neural Information Processing Systems (NIPS), , p. 601-608

- (en) Hidetoshi Shimodaira, « Improving predictive inference under covariate shift by weighting the log-likelihood function », Journal of statistical planning and inference, no 90.2, , p. 227-244

- Yaroslav Ganin et Victor Lempitsky, « Unsupervised domain adaptation by backpropagation », Proceedings of the 32nd International Conference on International Conference on Machine Learning - Volume 37, JMLR.org, iCML'15, , p. 1180–1189 (DOI 10.5555/3045118.3045244, lire en ligne, consulté le )

- Mingsheng Long, Yue Cao, Zhangjie Cao et Jianmin Wang, « Transferable Representation Learning with Deep Adaptation Networks », IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 41, no 12, , p. 3071–3085 (ISSN 1939-3539, DOI 10.1109/TPAMI.2018.2868685, lire en ligne, consulté le )

- Nicolas Courty, Rémi Flamary, Devis Tuia et Alain Rakotomamonjy, « Optimal Transport for Domain Adaptation », IEEE Transactions on Pattern Analysis and Machine Intelligence, vol. 39, no 9, , p. 1853–1865 (DOI 10.1109/tpami.2016.2615921, lire en ligne, consulté le )